2019

UNIVERSIDADE DE LISBOA

FACULDADE DE CIÊNCIAS

DEPARTAMENTO DE INFORMÁTICA

SolAR: REALIDADE AUMENTADA PARA APOIO AO

APROVEITAMENTO DA ENERGIA SOLAR EM FACHADAS DE

EDIFÍCIOS

Carolina Branco Meireles

Mestrado em Informática

Trabalho de Projecto orientado por:

Profª. Doutora Maria Beatriz Duarte Pereira do Carmo

Profª. Doutora Ana Paula Boler Cláudio

iii

Agradecimentos

Este trabalho não poderia ter sido concretizado sem o apoio constante dos meus pais, avós e orientadoras. A todos eles, um misto de profunda gratidão e imensa estima.

Agradeço, também, aos meus irmãos João e Luís: a um por sempre ter acreditado e puxado por mim, ao outro por ter estado sempre incrivelmente presente quando precisei.

Agradeço ao Pedro Cardoso a força inspiradora, ao José Soeiro a possibilidade de ter trabalhado com uma mente incomum, ao Hugo Garcia as sugestões e o entusiasmo pela app SolAR, e ao Eduardo Kiesse a poesia que sempre vai surgindo, sorrateira, pelos dias - não vá o espanto decidir ausentar-se do espanto das coisas.

Um agradecimento especial ao Doutor Luís Redinha e ao Doutor Miguel Otero por todo o dedicado acompanhamento no processo demorado de recuperação da minha saúde. Sem eles, a história ter-se-ia contado de um modo diferente: não necessariamente menos feliz, mas decerto menos plena.

v

Resumo

A Realidade Aumentada (RA) consiste na combinação, em tempo real, de conteúdo gerado computacionalmente com o mundo real. Esta tecnologia é actualmente aplicada em múltiplas e distintas áreas como a Medicina, a Educação, o Entretenimento, a Indústria, a Segurança, a Robótica, entre outras. Os recentes desenvolvimentos dos dispositivos móveis, tais como tablets e smartphones, vieram potenciar as possibilidades de aplicações desta tecnologia, assim como a sua difusão, já que à sua portabilidade, popularidade e preço acessível se adicionaram outras características fundamentais à RA como, por exemplo, a existência de sensores (bússola, giroscópio e acelerómetro), de uma câmara de alta resolução, de conectividade wireless, de um sistema de geolocalização e de um maior desempenho.

Neste documento apresenta-se um projecto de desenvolvimento de uma aplicação de realidade aumentada, a SolAR, concretizada para o sistema operativo Android e vocacionada para tablets. Esta aplicação permite a visualização em RA de dados relativos à radiação solar, bem como a simulação de colocação de uma ou mais matrizes de módulos fotovoltaicos e a apresentação de informação sobre o seu custo e rendimento energético. Para além do aprimoramento de algumas das funcionalidades já realizadas em trabalho anterior, pretendeu-se com este projecto aumentar as operações disponíveis, nomeadamente a possibilidade de adicionar, seleccionar, editar, eliminar e guardar matrizes de módulos fotovoltaicos, bem como adicionar outras funcionalidades relevantes como a possibilidade de alinhamento manual das paredes virtuais com as paredes captadas pela câmara e o trancamento da imagem da câmara para maior conforto de utilização das funcionalidades desenvolvidas.

Foram realizados testes com utilizadores para avaliar as novas funcionalidades integradas e a usabilidade da aplicação

Palavras-chave: Realidade Aumentada, Visualização, Computação Móvel, Dados Científicos,

vii

Abstract

Augmented Reality (AR) consists in the real-time combination of computationally generated content in a real-world setting. This technology is currently applied in multiple and distinct areas of study such as: Medicine, Education, Entertainment, Industry, Security and Robotics, amongst others. The recent developments of mobile devices, for instance tablets and smartphones, enlarged the range of possible applications in this technology as well as its diffusion, since to its portability, popularity and accessible prices, were added other fundamental features to AR: presence of sensors (compass, gyroscope and accelerometer), a high resolution camera, wireless connectivity, a geolocation system and a higher performance.

This document describes the SolAR project, an AR solution developed for tablets with the Android operating system. This application allows the visualization of data related to solar radiation in AR, as well as the simulation of placement of one or more solar photovoltaic module matrices, displaying information regarding its cost and energy efficiency. In addition to the improvement of some of the previous functionalities, the available operations were extended, notably the possibility of adding, selecting, editing, removing and saving matrixes of photovoltaic modules. Moreover, relevant functionalities were added to the application like the manual alignment the virtual walls with the real ones captured by the camera of the tablet and also a camera image locking option for a more comfortable user experience.

User tests were performed to evaluate the newly integrated functionalities and the application’s usability.

Keywords: Augmented Reality. Visualization, Scientific Data, Mobile Computation, Solar

ix

Índice

Capítulo 1 - Introdução ... 1 1.1 Motivação ... 1 1.2 Objectivos ... 1 1.3 Contribuições ... 2 1.4 Planeamento Inicial ... 2 1.5 Organização do documento ... 3Capítulo 2 - Trabalho Relacionado ... 5

2.1 Conceito de RA e sua evolução ... 5

2.2 Desafios da RA em Dispositivos Móveis ... 6

2.3 Visualização de Informação Contextualizada em RA ... 8

2.4 Visualização de dados científicos em RA ... 11

2.5 Ferramentas para RA – exemplos do ARKit e ARCore ... 15

2.6 Práticas recomendadas para RA ... 17

2.7 Biblioteca RUBI Glare e Visualização de Dados de Radiação Solar ... 18

2.7.1 Contextualização ... 18

2.7.2 Dados sobre radiação solar ... 20

2.7.3 Visualização dos dados de radiação solar em RA ... 22

2.7.4 Middleware ... 24

Capítulo 3 – Aplicação SolAR ... 25

3.1 Dados ... 25

3.2 Software e Hardware ... 26

3.2.1 Gradle e Android Studio ... 26

3.2.2 OpenGL ES ... 27

3.2.3 Dispositivos móveis usados ... 27

3.3 Matrizes responsáveis pela criação do mundo virtual ... 28

3.4 Ajustes da camada de RA ... 29

3.4.1 Câmara e área de desenho ... 29

3.4.2 Parâmetros de projecção da câmara virtual ... 31

3.4.3 Calibração manual ... 32

3.5 Componentes da aplicação SolAR ... 33

3.6 Resumo ... 33

Capítulo 4 - Localização e Orientação ... 35

4.1 Sensores de movimento e posição ... 35

4.2 Azimuth, Pitch e Roll ... 35

4.3 Acelerómetro e Magnetómetro ... 36

4.4 Optimização da Orientação do Dispositivo ... 37

x

4.5.1 Do dispositivo e da Terra ... 38

4.5.2 Dos sensores do dispositivo e do OpenGL ... 40

4.6 Determinação da Localização... 40

4.7 Rotações da Câmara ... 41

4.7.1 Generalização do center of view ... 43

4.8 Resumo ... 43

Capítulo 5 – Módulos Fotovoltaicos ... 45

5.1.1 Alinhamento dos módulos fotovoltaicos com a parede ... 45

5.1.2 Melhoria do algoritmo da colocação dos módulos fotovoltaicos ... 46

5.1.3 Construção de matrizes de módulos fotovoltaicos ... 47

5.1.4 Desenho das matrizes de módulos fotovoltaicos ... 47

5.1.5 Adição de transparência aos módulos fotovoltaicos ... 49

5.1.6 Movimento da matriz de módulos fotovoltaicos ... 49

5.1.7 Imposição de limites ao movimento da matriz de módulos fotovoltaicos ... 50

5.1.8 Limitação do número de módulos fotovoltaicos da parede ... 53

5.1.9 Reconhecimento do módulo fotovoltaico seleccionado ... 54

5.1.10 Adição de Contornos ... 57

5.1.11 Eliminação de módulos fotovoltaicos ... 57

5.1.12 Guardar uma configuração de matrizes de módulos fotovoltaicos ... 59

5.1.13 Feedback energético e financeiro ... 60

5.1.14 Colocação de módulos fotovoltaicos em mais do que uma parede ... 61

5.1.15 Considerações sobre memória ... 62

5.2 Resumo ... 62

Capítulo 6 – Interface Com o Utilizador ... 63

6.1 Aparência geral da app SolAR ... 63

6.2 Valores por omissão ... 64

6.3 Escala de Cores e Bússola ... 64

6.4 Toolbar ... 64

6.5 Botões e opções tomadas de modo a assegurar a consistência da IU ... 65

6.6 Criação dos Ícones ... 66

6.7 Os dois modos diferentes de interacção da app SolAR ... 67

6.7.1 Modo de Vista Não Trancada ... 67

6.7.2 Modo de Vista Trancada ... 68

6.8 Resumo ... 75

Capítulo 7 - Testes com o Utilizador ... 77

7.1 Procedimento ... 77

xi

7.3 Participantes ... 78

7.4 Resultados ... 80

7.4.1 Realização de Tarefas ... 80

7.4.2 Perguntas de Resposta Aberta ... 81

7.4.3 Avaliação de Funcionalidades e SUS ... 82

7.5 Resumo ... 83

Capítulo 8 – Conclusões e Trabalho Futuro ... 85

Bibliografia ... 87

Anexo A - Principais Classes e Métodos Desenvolvidos ... 93

Anexo B - Influência da Altitude ... 97

Anexo C – Pormenores técnicos para programador ... 99

Anexo D - Memória em Android ... 101

Anexo E - Manual de Utilização da WSolAR... 103

Anexo F - Guião de Testes com o Utilizador ... 113

xiii

Lista de Figuras

Figura

2.1 - Exemplos de marcas fiduciais clássicas (direita) (AugmentedReality, 2007) e exemplo de uma marca usada pelo Vuforia; o modelo virtual surge sobre a marca ou "image target"escolhida (unity, 2019) ... 7

Figura

2.2 - Abordagem automática (Honkamaa, et al., 2007) ... 7Figura

2.3 - Sistemas de tracking para exteriores [adaptado de (Bostanci, et al., 2013)] ... 8Figura

2.4 - Touring Machine (Feiner, et al., 1997)... 8Figura

2.5 - Equipamento usado pela LifeClipper2 ... 9Figura

2.6 - Aplicação MARA da Nokia Research Center ... 9Figura

2.7 - Wikitude AR Travel Guide ... 10Figura

2.8 - App Blippar (Blippar, 2011) ... 10Figura

2.9 - Google Maps com VPS: os locais são identificados através de placas sobrepostas à imagem da câmara (à esquerda); as direcções são dadas através de setas sobrepostas à imagem da câmara (à direita) ... 11Figura

2.10 - Níveis de detalhe abrangidos pelo CityGML ... 12Figura

2.11 - Simulação da Poluição em RA (Graf, et al., 2010) ... 12Figura

2.12 - Exemplo da interface do SiteLens, suportando a representação de dados em RA usando (a) caixas de texto, esferas, (b) cilindros (c) e fumo (White, et al., 2009) ... 13Figura

2.13 - Multicopter sobrevoando o cenário (Koch, et al., 2011) ... 13Figura

2.14 - Interface da HYDROSYS (HYDROSYS, 2010) ... 14Figura

2.15 - Simulação de correntes de ar em RA (Ritterbusch, et al., 2013) ... 15Figura

2.16 - Simulação da velocidade e distribuição de finas partículas de poeira em RA (Ritterbusch, et al., 2013) ... 15Figura

2.17 - Screenshot da app Woorld (Funomena LLC, 2016) ... 16Figura

2.18 - Screenshot da app Just a Line (Google Creative Lab, 2018) ... 17Figura

2.19 - Capacidade mundial global de energia solar fotovoltaica de 2007 a 2017, por país ou região (REN21, 2018) ... 19Figura

2.20 - Investimentos em energias renováveis durante o ano de 2017 (REN21, 2018) .... 19Figura

2.21 - Níveis de radiação global correspondentes à Primavera e ao Verão (Redweik, et al., 2013) ... 21Figura

2.22 - Níveis de radiação solar anual de alguns edifícios da Faculdade de Ciências (Redweik, et al., 2013) ... 21Figura

2.23 - Modos de visualização desenvolvidos por José Pedrosa: (a) Superfícies coloridas, (b) Glifos coloridos, (c) Superfícies com glifos e (d) Superfícies coloridas com deformação (Pedrosa, 2013)... 23Figura

2.24 - RUBI Glare: Visualização com glifos (Pedrosa, 2013) ... 23xiv

Figura

2.26 - Escala de tons de cinzento (Silva, 2013) ... 24Figura

2.27 - Escala de tons de cinzento invertida (Silva, 2013) ... 24Figura

3.1 - Coordenadas e Matrizes do OpenGL ES ... 29Figura

3.2 - Stretching e Cropping (Grubert, et al., 2013) ... 30Figura

4.1 - Ângulo Pitch (Google Developer, 2018) ... 36Figura

4.2 - Ângulo Roll (Google Developer, 2018) ... 36Figura

4.3 - Esquema do sistema Sensor Fusion de Paul Lawitzki. ... 37Figura

4.4 - Sistema de Coordenadas num smartphone (pngimg, 2013) ... 38Figura

4.5 - Sistema de Coordenadas num tablet (pngimg, 2013) ... 38Figura

4.6 - Posicionamento do sistema de coordenadas da Terra ... 39Figura

4.7 - Calibração do magnetómetro (Google Developer, 2018) ... 39Figura

5.1 - Representação do módulo fotovoltaico com os seus vectores directores ... 45Figura

5.2 - Screenshot da app Solar mostrando o problema de transparência ocorrido ... 49Figura

5.3 - Esquema das possibilidades de posicionamento de ma parede em relação aos eixos principais: N(x) corresponde à componente X do vector normal e N(z) à componente Z do mesmo vector. ... 51Figura

5.4 - Simplificação do método inBoundingBox() para o caso 3 da Figura 6.3 ... 52Figura

5.5 - Esquema da intersecção do raio com a bounding sphere [Adaptado de (Brothaler, 2013)] ... 56Figura

5.6 - Exemplo da reinserção de um módulo fotovoltaico ... 59Figura

5.7 - Screenshot da ferramenta Memory Profiler do Android Studio na altura em que a app SolAR se auto-encerrava por excesso de memória. ... 62Figura

6.1 - Screenshot da app SolAR identificando as suas componentes principais ... 63Figura

6.2 - Exemplo de mensagem Toast da app SolAR ... 66Figura

6.3 - Criação de dois ícones diferentes para a app SolAR ... 67Figura

6.4 - Screenshot dos botões presentes na Toolbar no modo de vista não trancada ... 67Figura

6.5 - Screenshot da app SolAR mostrando a opção de Ajuda do modo de vista não trancada ... 68Figura

6.6 – Parte da Toolbar do modo de vista trancada da app SolAR. ... 69Figura

6.7 - Spinner da app SolAR representando os dois diferentes modos de adição de módulos fotovoltaicos ... 70Figura

6.8 - Os Number Pickers que permitem a escolha das linhas e colunas que compõem a matriz de módulos fotovoltaicos a ser adicionada no modo Manual ... 71Figura

6.9 - Contorno encarnado numa matriz seleccionada da app SolAR ... 71Figura

6.10 - Parte de um screenshot da app SolAR que mostra módulos fotovoltaicos apagados numa matriz de módulos fotovoltaicos... 72Figura

6.11 - Dialog apresentando o feedback financeiro e energético de uma configuração de 24 módulos fotovoltaicos cobrindo uma área de 115.2m2 ... 72Figura

6.12 - Dialog apresentada pela opção de eliminação ... 73Figura

6.13 - Dialog das Definições dos Módulos Fotovoltaicos ... 74xv

Figura

7.1 Gráficos que mostram a distribuição dos participantes por faixa etária (esquerda) egénero (direita) ... 79

Figura

7.2 - Gráfico que representa a dispersão dos utilizadores por área de estudos ... 79Figura

7.3 - Nível de familiaridade com dispositivos móveis numa escala de 1 a 5, sendo 1 "Nada Familiar" e 5 "Muito Familiar" ... 80Figura

7.4 - Principal configuração de módulos fotovoltaicos escolhida para a realização da terceira tarefa ... 81Figura

7.5 - Gráfico representando o nível de relevância, de 1 a 5, das funcionalidades implementadas, conforme avaliado pelos testes com o utilizador ... 82Figura A.

0.1 - Screenshot da app SolAR com um valor de altitude que melhora o alinhamento dos elementos virtuais ... 97Figura A.

0.2 - Screenshot da app SolAR com um valor de altitude que permite a oclusão das paredes que se encontram por detrás das paredes efectivamente visíveis ... 97Figura B.

0.1 - Screenshot da app SolAR com a opção "Depurar excesso da GPU" activada ... 102Figura D.

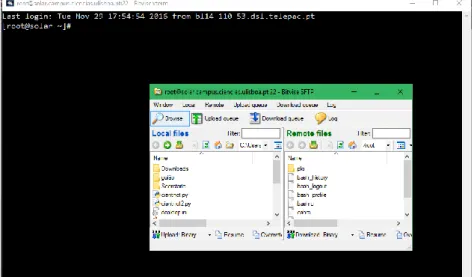

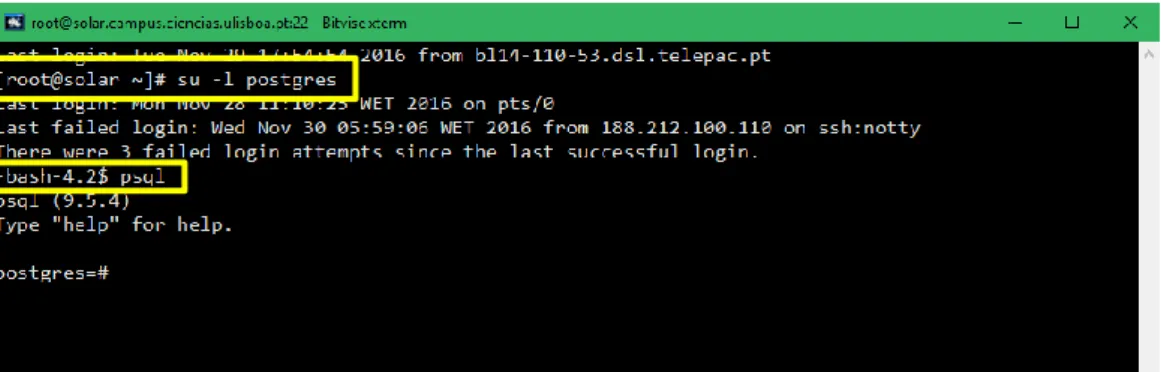

0.1 – Janela do software Bitvise SSH Client com campos a preencher salientados a encarnado ... 103Figura D.

0.2 - Janela do software Bitvise SSH Client. ... 104Figura D.

0.3 – As duas janelas disponíveis para o acesso e edição dos dados do serviço Web 104 Figura D.

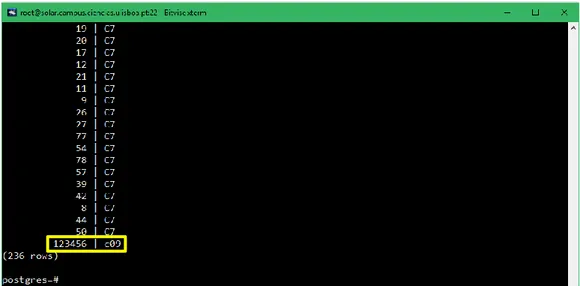

0.4 – Uso da consola disponível para aceder ao serviço Web. ... 105Figura D.

0.5 - Esquema da Base de Dados (concebido por Daniel Soares) ... 106Figura D.

0.6 - Exemplo de adição de uma fachada no serviço Web. ... 107Figura D.

0.7 – Janela da consola mostrando os primeiros valores do campo "fachada" ... 107Figura D.

0.8 - Janela da consola mostrando os últimos valores do campo "fachada" ... 108Figura D.

0.9 – Alteração do nome do edifício de uma fachada recorrendo ao serviço Web. ... 109Figura D.

0.10 - Verificação da alteração efectuada ... 109Figura D.

0.11 - Eliminação do valor inserido aos dados ... 109Figura D.

0.12 - Verificação da eliminação efectuada ... 110Figura D.

0.13 - Inserção de dados seguindo o Segundo Método ... 110Figura D.

0.14 - Linha que concretiza a actualização dos novos ficheiros. ... 111Figura D.

0.15 – Tabelas do serviço Web que não se encontram preenchidas. ... 111xvii

Lista de Tabelas

Tabela

3.1 - Propriedades dos tablets testados ... 28 Tabela

7.1 - Valores mínimo, máximo, da média, da moda e do desvio padrão correspondentes à avaliação de relevância de cada uma das funcionalidades avaliadas ... 83xviii

Lista de Acrónimos e Siglas

ADT Android Developer Tools

API Application Programming Interface

app application

DEGGE Departamento de Engenharia Geográfica Geofísica e Energia

DI Departamento de Informática

EPCGI Encontro Português de Computação Gráfica e Interacção

FCUL Faculdade de Ciências da Universidade de Lisboa

FOV Field Of View

GPS Global Positioning System

GPU Graphics Processing Unit

HMD Head-Mounted Display

KML Keyhole Markup Language

IDE Integrated Development Environment

IU Interface com o Utilizador

LiDAR Light Detection and Ranging

LOD Level Of Detail

LogCat Logistics Capability Assessment Tool

MARA Mobile Augmented Reality Applications

MARQ Mobile Augmented Reality Quest

OST Optical See-Through

PV Photovoltaic Module

RA Realidade Aumentada

REN21 Renewable Energy Policy Network for the 21th Century

RV Realidade Virtual

SIG Sistemas de Informação Geográfica

SUS Scale Usability Test

UAV Unmanned Aerial Vehicle

VBO Vertex Buffer Object

VPS Visual Positioning System

VST Video See-Through

WGS84 World Geodesic System

1

Capítulo 1 - Introdução

Neste capítulo será apresentado o enquadramento que torna este projecto relevante para a actualidade. De seguida explicitar-se-ão os objectivos deste projecto, as principais contribuições efectuadas, o planeamento inicial do mesmo, bem como a organização do presente documento.

1.1 Motivação

A utilização de dispositivos móveis, como smartphones e tablets, está actualmente generalizada devido ao seu preço acessível, à sua portabilidade e à diversidade de funcionalidades que oferece. Uma vez que os dispositivos móveis possuem uma boa capacidade de processamento e estão equipados com câmaras, sensores (como acelerómetros, magnetómetros e giroscópios) e sistemas de geolocalização e conectividade em rede, é possível utilizá-los para a execução de aplicações de Realidade Aumentada (RA) tornando-as acessíveis a um público muito vasto.

Como tal, o desenvolvimento de aplicações capazes de proporcionar experiências de Realidade Aumentada através de dispositivos móveis é plenamente justificável, assim como a representação de dados científicos relacionados com as necessidades actuais da sociedade. No caso específico deste projecto, os dados científicos dizem respeito à radiação solar, estando estritamente relacionados com os actuais problemas de sustentabilidade energética.

O aproveitamento da energia solar requer a utilização de uma área relativamente vasta de módulos fotovoltaicos para produzir uma quantidade significativa de energia. Consequentemente, o uso das fachadas dos edifícios, para além dos telhados, oferece uma área complementar que não deve ser menosprezada na instalação destes sistemas de energia renovável. Uma vez que as fachadas dos edifícios são superfícies adequadas à apresentação de informação em RA, aplicações que exibam estes dados recorrendo a esta tecnologia, e fazendo uso dos mesmos para fornecer feedback sobre possíveis sistemas renováveis a instalar em edifícios, não só são úteis ao utilizador comum como também podem contribuir para a divulgação do uso da energia solar (Carmo, et al., Augmented Reality for support decision on solar radiation harnessing, 2016).

1.2 Objectivos

O facto da Realidade Aumentada permitir a visualização de informação no seu contexto, isto é, no próprio lugar de onde a informação foi extraída, é uma mais-valia para a análise de dados científicos in loco, uma vez que possibilita uma melhor apreensão dos mesmos. Porém, esta visualização acarreta uma série de desafios, nomeadamente no que respeita ao alinhamento dos elementos virtuais da aplicação com as imagens captadas, em tempo real, pela câmara do dispositivo.

2

Este trabalho teve como principal objectivo o desenvolvimento de uma aplicação para tablets que permita ao utilizador comum verificar o rendimento que pode extrair de um sistema energético solar que instale nas fachadas de um edifício. Dada a natureza dos dados da aplicação, esta também pode ser usada como ferramenta de apoio para técnicos ou investigadores da área (Carmo, et al., Augmented Reality for support decision on solar radiation harnessing, 2016).

A aplicação que se apresenta neste projecto veio continuar os trabalhos desenvolvidos por José Pedrosa, Silvana Silva e Daniel Soares no âmbito de trabalhos autónomos supervisionados de mestrado do Departamento de Informática (DI) da Faculdade de Ciências da Universidade de Lisboa (FCUL). José Pedrosa desenvolveu a visualização de dados em RA, Silvana Silva actualizou a versão do OpenGL ES para a 2.0 e adicionou a possibilidade de inserção de um módulo fotovoltaico na fachada de um edifício, e Daniel Soares criou a camada de middleware de apoio à aplicação. As contribuições destes autores são descritas no capítulo sobre o trabalho relacionado. Para além da necessidade de um melhor alinhamento entre o modelo virtual tridimensional e as imagens reais captadas pela câmara, eram objectivos iniciais deste projecto melhorar a interface com o utilizador e acrescentar a possibilidade de adicionar mais de um módulo fotovoltaico a uma fachada. Este trabalho tem sido desenvolvido em colaboração com o Departamento de Engenharia Geográfica Geofísica e Energia (DEGGE).

1.3 Contribuições

A primeira fase do projecto consistiu essencialmente na familiarização com a plataforma Android e com o código já desenvolvido por José Pedrosa, Silvana Silva e Daniel Soares. De seguida realizaram-se as seguintes contribuições principais:

Actualizações do código;

Melhoria da aquisição dos valores da orientação;

Redefinição e ajustamento de parâmetros de forma a permitir uma melhor sobreposição dos elementos virtuais com as imagens reais captadas pela câmara;

Adição de novas funcionalidades concernentes à manipulação dos módulos fotovoltaicos e consequente extracção de informação;

Melhoria da interface com o utilizador;

Ligação do projecto ao Middleware desenvolvido por Daniel Soares.

Uma parte inicial deste projecto foi publicada juntamente com o trabalho realizado por Silvana Silva no artigo intitulado“AugmentedRealityforsupportdecisiononsolarradiationharnessing”,em 2016, no Encontro Português de Computação Gráfica e Interacção (EPCGI) (Carmo, et al., Augmented Reality for support decision on solar radiation harnessing, 2016).

1.4 Planeamento Inicial

O planeamento inicial deste projecto consistia no seguinte agendamento: 1 de Outubro a 30 de Novembro

3

- Familiarização com a plataforma de Realidade Aumentada já desenvolvida.

- Pesquisa de trabalhos relacionados quer no domínio da visualização, quer no domínio da Realidade Aumentada.

- Escrita do relatório preliminar. 30 de Novembro a 30 de Abril

- Melhoramentos das funcionalidades já existentes

- Concretização de diferentes abordagens de adaptação da visualização. - Integração de novas funcionalidades.

30 de Abril a 30 de Junho

- Testes de avaliação das soluções de adaptação. - Melhoramentos em função dos resultados dos testes. - Escrita do relatório final.

Este planeamento não pôde ser cumprido devido a um problema de saúde que obrigou a um adiamento da conclusão do trabalho.

1.5 Organização do documento

Neste capítulo realçou-se a pertinência deste projecto na actualidade, especificaram-se os objectivos e problemas principais do mesmo, resumiram-se as contribuições realizadas, e apresentou-se o planeamento inicial, o resto do documento encontra-apresentou-se organizado da apresentou-seguinte forma:

Capítulo 2 – Trabalho Relacionado

Capítulo onde são referidas as principais abordagens relacionadas com a aplicação de RA do projecto, nomeadamente sobre RA em dispositivos móveis, visualização de dados em ambientes exteriores e visualização de dados científicos; são também apresentadas as funcionalidades já existentes na aplicação.

Capítulo 3 – Aplicação SolAR

Capítulo que começa por apresentar os dados usados no âmbito da aplicação SolAR, as actualizações de software efectuadas e os dispositivos testados. De seguida explicam-se os diversos ajustes efectuados para o correcto funcionamento da camada de RA e apresentam-se as componentes da aplicação.

Capítulo 4 – Localização e Orientação

Capítulo onde se descrevem as alterações efectuadas com o intuito de melhorar os sistemas de posicionamento e tracking da app SolAR, bem como a explicação do modo como estes sistemas funcionam no Android.

Capítulo 5 – Módulos Fotovoltaicos

Capítulo que detalha a elaboração das diferentes funcionalidades que constituem as opções de interacção existentes na app, todas elas envolvendo módulos fotovoltaicos.

Capítulo 6 – Interface com o Utilizador

Capítulo onde a interface de utilizador é apresentada e se justificam as opções escolhidas para a elaboração da mesma.

4

Capítulo que apresenta os resultados dos testes com o utilizador feitos à app SolAR.

Capítulo 8 – Conclusão e Trabalho Futuro

5

Capítulo 2 - Trabalho Relacionado

Dado que o objectivo deste trabalho é o desenvolvimento de uma aplicação de visualização de dados de radiação solar em RA, pretende-se com este capítulo apresentar o conceito de realidade aumentada, destacar a visibilidade crescente dos dispositivos móveis como meios de suporte desta tecnologia, e contextualizar e aprofundar as questões relacionadas com os desafios da computação móvel e da visualização de dados científicos em RA. Estas questões têm vindo a ser abordadas por diversos autores cujos trabalhos serviram de ponto de partida para o presente projecto.

2.1 Conceito de RA e sua evolução

A Realidade Aumentada (RA) consiste numa combinação de tecnologias que permite a sobreposição, em tempo real, de conteúdo gerado computacionalmente (Mekni & Lemieux, 2014). Esta sobreposição pode ser feita sobre uma exibição de vídeo ao vivo num smartphone ou tablet (tecnologia video see-through ou VST) ou sobre um dispositivo óptico (tecnologia optical see-through ou OST) (Grubert & Grasset, 2013). À semelhança da Realidade Virtual (RV), que procura criar um mundo artificial que o utilizador possa experienciar e explorar interactivamente através dos seus sentidos (especialmente o da visão), a RA também procura proporcionar ao utilizador uma experiência interactiva. Porém, não se encontra nos objectivos da RA criar um ambiente inteiramente artificial, mas sim suplementar o mundo real com informação relevante (Höllerer & Feiner, 2004), sendo que os produtos com maior sucesso no mercado são aqueles que colmatam uma necessidade ou solucionam problemas reais (Aukstakalnis, 2017).

Otermo“RealidadeAumentada”foiprimeiramenteapresentadopelosinvestigadoresThomas Caudell e David Mizell em 1990 (Caudell & Mizell, 1992), a quem foram solicitadas melhorias de custo e eficiência nos procedimentos envolvidos na manufactura aeronáutica da Boeing. Com o intuito de solucionar este problema, Caudell e Mizell propuseram a disponibilização de toda a informação necessária ao trabalhador através de um head-mounted display (HMD). Desta forma a informação passou a estar disponível in loco através de gráficos elucidativos, nomeadamente texto e símbolos, permitindo um aumento da eficiência dos procedimentos envolvidos (Villagomez, 2012). Hoje em dia esta tecnologia é aplicada em múltiplas e distintas áreas como a Medicina, a Educação, o Entretenimento, a Indústria, a Segurança, a Robótica, entre outras.

Os recentes desenvolvimentos dos dispositivos móveis, tais como tablets e smartphones, vieram exponenciar a gama de aplicações desta tecnologia, assim como a sua difusão, já que à sua portabilidade e popularidade se adicionaram outras características fundamentais à RA como, por exemplo, a existência de sensores (bússola, giroscópio e acelerómetro), de uma câmara de alta resolução, de conectividade wireless, de um sistema de geolocalização, de um ecrã de dimensões

6

superiores e de um maior desempenho (Mekni & Lemieux, 2014). Aplicações de RA para as plataformas Android e iOS4 como a Layar, a Junaio, a Wikitude, a Google Googles e a ShopSavvy permitem visualizar e explorar informação digital relacionada com objectos e lugares do mundo real, captados através da vista da câmara do dispositivo móvel. Estas aplicações têm despertado um interesse crescente por parte dos utilizadores, incluindo-se cada vez mais no dia-a-dia de um número considerável de pessoas (Olsson & Salo, 2011).

Grandes empresas como a Apple, o Facebook, a Microsoft, a Google e a Intel estão a seguir de perto os avanços da RA, bem como a investir nesta tecnologia, com o objectivo de a tornar acessível ao grande público (Papagiannis, 2017).

Em Julho de 2016, o jogo de RA Pokémon GO foi lançado pela Niantic (Pokemon GO, 2018) e o seu êxito divulgou os sistemas de realidade aumentada baseados na localização (location based AR) (Munis, 2018). Pela primeira vez, a RA chegou em massa ao público, abrangendo mais de 100 milhões de pessoas, despertando o interesse e familiaridade do público para com esta tecnologia (Scoble & Israel, 2016). Niantic é uma empresa vocacionada para a criação de jogos de RA para smartphones, resultante da união da Nintendo com a Google. Outras empresas seguiram-lhe o exemplo lançando jogos de RA baseados em filmes já conhecidos como o Jurassic World Alive da Ludia Inc, (Ludia Inc, 2018) e o Ghostbusters World da FourThirtyThree Inc (FourThirtyThree Inc., 2018), tendo a Niantic lançado um novo jogo de RA em Julho de 2019, em parceria com a Warner Bros, baseado no mundo fictício do Harry Potter (Niantic, Inc., 2019).

Snapchat, uma plataforma social com mais de 500 milhões de downloads na Google Play (Snap Inc, 2018), tem contribuído, desde 2015, para a popularização da Realidade Aumentada. No Snapchat, a comunicação é feita através de vídeo, sendo permitida a sobreposição de objectos virtuais (as denominadas “lenses” na app), que se adaptam à face dos utilizadores, sobre a imagem da câmara. Cada publicação nesta rede social tem um tempo de vida de 24 horas, momento a partir do qual a publicação“auto-elimina-se”,deixandodeestarvisível/disponívelparaqualquerutilizador(Wadhera, 2016). Em 2017, a Snap Inc apresentou a Lens Studio (Snap Inc, 2017) que permite que os utilizadores criem as suas próprias lenses, e as disponibilizem para que outros utilizadores as usem, tornando a experiência de RA mais interactiva e personalizada (Lens Studio, 2018).

2.2 Desafios da RA em Dispositivos Móveis

Um dos maiores desafios da RA em dispositivos móveis diz respeito ao alinhamento dos objectos virtuais com as imagens reais captadas em tempo real, já que se este não for suficientemente verosímil, a coexistência dos mundos real e virtual ficará comprometida, havendo um desfasamento notório entre as imagens captadas pela câmara e os objectos virtuais (Azuma, 1997).

Para a identificação das posições precisas onde os objectos virtuais devem ser colocados sobre as imagens reais recorre-se a diferentes técnicas, nomeadamente a marcas naturais e fiduciais.

As marcas naturais dizem respeito às propriedades do próprio objecto e pressupõem um conhecimento prévio do mesmo. Estas podem ser pontos, linhas ou padrões característicos, que são detectados e identificados através da análise das imagens captadas pela câmara.

As marcas fiduciais são padrões bidimensionais físicos simples associados a um identificador que os faz corresponder a um modelo virtual. Quando se dá a sua detecção, o identificador da marca é reconhecido e o modelo virtual é posicionado sobre a mesma. Hoje em dia, as marcas usadas podem corresponder a imagens esteticamente mais agradáveis e contextualizadas como é o caso das imagens

7

permitidas pelo Vuforia, um SDK de RA para dispositivos móveis que permite a criação de aplicações de RA. A Figura 2.1 mostra alguns exemplos de marcas de RA usadas.

Para o funcionamento de uma aplicação de RA não basta, porém, identificar onde é que os modelos virtuais se encontram no espaço físico (isto é, concretizar a registration), é preciso segui-los quando estes se movem ou o utilizador se move; tal é conseguido através do tracking (Grubert & Grasset, 2013).

Honkamaa, et al. propuseram um sistema de tracking para mini-PCs que fosse executado em tempo real e que recorresse à leitura dos valores do acelerómetro para gerar uma estimativa do movimento da câmara do dispositivo. Este sistema seguia duas abordagens distintas para o alinhamento e posicionamento do objecto tridimensional na cena: uma abordagem automática que recorria ao GPS do dispositivo e a informação geográfica recolhida através da Google Earth para calcular a posição do objecto (ver Figura 2.2); e uma abordagem semiautomática onde a distância do utilizador ao objecto e a sua orientação eram fornecidos de um modo manual ao dispositivo através de uma interacção táctil com o objecto virtual (Honkamaa, Siltanen, Jäppinen, Woodward, & Korkalo, 2007).

Os diferentes tipos de tracking para outdoors encontram-se representados no esquema da Figura 2.3. Nele surgem os quatro diferentes modos de tracking existentes para exteriores: sistemas vision-based, onde se inserem as já referidas marcas fiduciais e naturais; sistemas baseados em sensores inerciais como acelerómetros e giroscópios; sistemas com GPS; e sistemas que fundem duas ou três destas possibilidades (Bostanci, Kanwal, Ehsan, & Clark, 2013). No âmbito deste projecto é usada a fusão do GPS com os valores obtidos através dos sensores inerciais.

Figura 2.1 - Exemplos de marcas fiduciais clássicas (direita) (AugmentedReality, 2007) e exemplo de uma marca usada pelo Vuforia; o modelo virtual surge sobre a marca ou "image target" escolhida (unity, 2019)

Figura 2.2 - Abordagem automática (Honkamaa, Siltanen, Jäppinen, Woodward, & Korkalo, 2007)

8

Figura 2.3 - Sistemas de tracking para exteriores [adaptado de (Bostanci, Kanwal, Ehsan, & Clark, 2013)]

2.3 Visualização de Informação Contextualizada em RA

Ao longo do tempo têm sido apresentadas diferentes soluções para a apresentação de informação contextualizada em RA. A Touring Machine (1997) foi uma das primeiras soluções móveis de RA a mostrar o potencial inerente à exploração de um ambiente urbano complementada por informações virtuais fornecidas em tempo real. Esta explorava três características fundamentais:

1. Apresentação integrada da informação virtual sobre o ambiente real;

2. Possibilidade de explorar um ambiente exterior de alguma dimensão (o campus universitário);

3. Combinação de múltiplos dispositivos e interacções tecnológicas.

Com o intuito de guiar o utilizador através do campus universitário, apresentando informações sobre os edifícios existentes na sua vizinhança, a Touring Machine recorria ao Global Positioning

System (GPS) e à orientação fornecida pelo magnetómetro para obter a posição actual do utilizador e a

sua direcção. Deste modo, o utilizador podia caminhar livremente pelo campus universitário, recebendo informações adicionais sobre o mesmo, contendo todo o equipamento necessário a esta tecnologia dentro de uma mochila que transportava consigo para onde quer que fosse dentro do campus (Feiner, MacIntyre, Höllerer, & Webster, 1997). Este equipamento pode ser visto na Figura

2.4.

9

Semelhante à Touring Machine, LifeClipper2 (LifeClipper2, 2008) é um projecto comercial orientado para o planeamento urbano e para o turismo que explora a RA em ambientes exteriores. Para tal possui três módulos distintos:

1. O módulo de tracking que detecta a posição do utilizador e a sua linha de visão; 2. O módulo de apresentação que combina os objectos virtuais com o mundo real;

3. E o módulo de interacção, responsável pelas interacções externa e interna da aplicação. A Figura 2.5 mostra o equipamento usado pela LifeClipper2.

Figura 2.5 - Equipamento usado pela LifeClipper2

MARA (Mobile Augmented Reality Applications), um protótipo de uma aplicação desenvolvida pela Nokia Research Center, foi demonstrada no International Symposium on Mixed and Augmented

Reality (ISMAR) em 2006. Tal como as duas aplicações anteriores, esta aplicação também recorre à

RA para fornecer informações adicionais sobre o local onde se encontra o utilizador (MARA, 2007). Um exemplo da sua interface pode ser vista na Figura 2.6.

Figura 2.6 - Aplicação MARA da Nokia Research Center

Também usada para fins turísticos, a Wikitude Augmented Reality Travel Guide é uma aplicação inicialmente desenvolvida para a plataforma Android (Ruffner & Deibler, 2010) que recorre a uma base de dados global com mais de 350 000 pontos de interesse, apresentando objectos virtuais (imagens e texto) com informações referentes aos pontos de interesse abrangidos pela imagem captada pela câmara do smartphone, informando o utilizador da distância a que se encontra dos mesmos, bem como da sua altura (Jesus & Oliveira, 2009). A Figura 2.7 mostra o exemplo de uma interface desta aplicação.

10

Já a Blippar (Blippar, 2011) e a Google Lens (Google LLC, 2017) são aplicações móveis de RA que fornecem informação contextualizada através da análise da imagem captada pela câmara, e consequente tentativa de identificação do que está a ser visualizado. A Figura 2.8 mostra um

screenshot da app Blippar, reconhecendo um edifício através de um sistema de tracking vision-based

sem marcas.

Figura 2.8 - App Blippar (Blippar, 2011)

Em Maio de 2018, na conferência Google I/O, Aparna Chennapragada, representante da Google Lens, RV e RA da Google, anunciou o Visual Positioning System (VPS) que recorre à câmara do dispositivo para identificar pistas visuais que permitam o dispositivo identificar com maior precisão a localização e orientação do utilizador. Deste modo, um utilizador que tenha a Google Maps iniciada poderá receber informação sobre um dado trajecto a executar através de um sistema de realidade aumentada contendo setas e placas sobrepostas à imagem da câmara (Google Developers, 2018).

A Figura 2.9 mostra a demo apresentada na Google I/O para mostrar as melhorias na navegação do Google Maps com o VPS.

11

2.4 Visualização de dados científicos em RA

A designação de Visualização de Dados Científicos surgiu nos finais da década de 1980 (McCormick, DeFanti, & Brown, 1987) relacionada com a visualização de dados numéricos, com referência espacial e/ou temporal, sem uma geometria pré-definida para a sua representação, e normalmente obtidos por medição ou simulação. Um exemplo de dados deste tipo são os da radiação solar usados pela app SolAR.

O interesse crescente de diversas áreas, como o planeamento urbano, a gestão de desastres e instalações, o turismo, a indústria de telecomunicações, a navegação pedestre e automóvel e a simulação ambiental, em aplicações de RA que permitam navegar no espaço tridimensional conduziu à construção de modelos 3D de várias cidades e à necessidade de um modelo tridimensional padrão, liderado pelo CityGML (CityGML, CityGML - A GML3 Application Profile for virtual 3D City Models, 2005).

CityGML contém os aspectos geométrico, topológico e semântico de uma cidade nos seus

modelos 3D. Deste modo é possível memorizar a sua forma e configuração. Esta possibilidade é particularmente importante para a gestão de desastres, já que permite o acesso a informações relacionadas com as áreas e os volumes dos edifícios. Por conseguinte, torna-se possível estimar, por exemplo, a extensão dos danos provocados por um terramoto ou o fluxo de gases existentes num determinado local, bem como auxiliar o planeamento da evacuação de um edifício, simulando percursos possíveis ou aplicando algoritmos que calculem o caminho mais curto existente entre dois pontos. Outra das vantagens do CityGML é o facto de considerar diferentes níveis de detalhe, tornando-o ajustável para áreas de diferentes magnitudes (Kolbe, Gröger, & Plümer, 2005). A Figura

2.10 mostra os diferentes níveis de detalhe (LOD – Level Of Detail) abrangidos pela CityGML.

Figura 2.9 - Google Maps com VPS: os locais são identificados através de placas sobrepostas à imagem da câmara (à esquerda); as direcções são dadas através de setas sobrepostas à imagem da câmara (à direita)

12

Graf, et al. (Graf, Santos, & Stork, 2010) desenvolveram uma framework para auxiliar o planeamento urbano. Esta envolve a simulação de fenómenos físicos (como a poluição e o ruído) e sua visualização por forma a avaliar o seu impacto sobre os objectos reais. A simulação é definida através de uma escolha prévia de parâmetros e condições-fronteira, sendo o resultado mostrado sobre os objectos físicos que representam os objectos reais através de um HMD, como se pode ver na Figura

2.11.

Figura 2.11 - Simulação da Poluição em RA (Graf, Santos, & Stork, 2010)

Também vocacionado para o planeamento urbano, SiteLens é o protótipo de uma aplicação que permite a denominada situated visualization, isto é, a visualização de dados relevantes no próprio lugar a que dizem respeito, com o intuito de ampliar a compreensão das diversas correlações existentes entre os dados visualizados e o local da sua origem. Desta forma é possível visualizar in loco algumas características do meio que não são visíveis a olho nu como os níveis de tráfego automóvel existentes ao longo do dia e a sua densidade populacional.

Este mecanismo recorre à conversão de dados no formato KML (Keyhole Markup Language) para permitir a interoperabilidade com o Google Earth e o Google Maps e suporta a visualização em dispositivos móveis e fixos.

Todas as informações com correspondência espacial são sobrepostas dinamicamente à vista principal do SiteLens, sendo o seu alinhamento efectivado recorrendo a marcas fiduciais. Porém, informações que não detenham esta particularidade também são apresentadas, sob a forma de uma caixa de texto informativa no canto superior esquerdo da interface, como se pode ver na Figura

2.12(a).

A Figura 2.12(c) mostra a representação natural, com nuvens de fumo negras, usada pelo

SiteLens para mostrar os níveis de monóxido de carbono (CO) existentes num local (White & Feiner,

2009).

13

Este protótipo possui ainda as opçõesde“trancamento”deimagemedeampliaçãosemântica.A primeira possibilita a interrupção da visualização em tempo real, fundamental para uma análise cuidadada“imagemretida”,e a segunda permite o acesso a informações detalhadas sobre cada ponto dos dados.

Combinando conceitos de tecnologias de RA com o uso de multicopter aircrafts controlados por rádio, Koch, et al. desenvolveram uma ferramenta de suporte às fases iniciais de planeamento da construção de edifícios e cidades que permite a visualização de informação virtual contextualizada. Para este fim, um multicopter equipado com duas câmaras integradas sobrevoa um cenário físico composto por uma série de marcas ópticas. À medida que o multicopter as sobrevoa, as imagens captadas pelas suas câmaras são transferidas, via wireless, para um laptop. Simultaneamente, um

software previamente instalado no laptop processa as imagens transferidas substituindo as marcas

fiduciais existentes no cenário físico pelo modelo tridimensional correspondente. Deste modo, é possível visualizar o modelo tridimensional do cenário segundo o ponto de vista do multicopter, permitindo uma navegação completa no modelo 3D (Koch, et al., 2011).

A Figura 2.13 mostra o multicopter usado pela ferramenta a sobrevoar o cenário físico.

HYDROSYS, uma ferramenta para análise de recursos naturais para dispositivos móveis e

laptops, potencialmente apoiados por um veículo aéreo não tripulado (UAV), fornece aos seus

utilizadores a capacidade de prever e analisar mudanças ambientais criteriosamente localizadas que afectem a qualidade da água, para que as medidas necessárias à reposição da sua qualidade sejam

Figura 2.12 - Exemplo da interface do SiteLens, suportando a representação de dados em RA usando (a) caixas de texto, esferas, (b) cilindros (c) e fumo (White & Feiner, 2009)

14

atempadamente tomadas, evitando prejuízos maiores (Nonymous, 2011). A Figura 2.14 mostra a interface desta ferramenta.

Ritterbush, et al. apresentaram um método de visualização que procura tornar o elevado volume de dados envolvido nas simulações mais compreensível, ao permitir a sua visualização sobre as imagens do mundo real a que dizem respeito, captadas pela câmara de um dispositivo móvel, em tempo real. Para tal recorre aos modelos virtuais tridimensionais das ruas e dos edifícios que são alvo de estudo, adoptando o padrão CityGML que possui todas as informações necessárias à simulação das grandezas pretendidas. Desta forma é possível simular, por exemplo, as correntes de ar existentes num determinado local ou a velocidade e distribuição de finas partículas de poeira em torno de um edifício.

Dada a enorme quantidade de dados envolvida, tanto o processamento como a geração das imagens são concretizados em servidores remotos de elevado desempenho. O cliente comunica por

wireless ou por rede móvel com o servidor, tendo como limitação a largura de banda disponível, e este

último devolve-lhe as imagens da simulação tendo em conta a sua posição e orientação precisas. Com o fim de minimizar a latência, o consumo da rede de transmissão de dados e os custos de processamento, para cada posição do utilizador é enviado um pacote de imagens pré-calculadas pelo servidor, referentes a diferentes perspectivas, que vão sendo apresentadas conforme a posição e orientação da câmara do dispositivo do cliente (Ritterbusch, Ronnas, Waltschläger, Gerstner, & Heuveline, 2013).

A Figura 2.15 mostra uma simulação de correntes de ar que recorre a este método e a Figura

2.16 diz respeito a uma simulação da velocidade e distribuição de finas partículas de poeira. Ambas as

imagens possuem streamlines geradas pelo software Paraview (ParaView, 2019). Figura 2.14 - Interface da HYDROSYS (HYDROSYS, 2010)

15

2.5 Ferramentas para RA – exemplos do ARKit e ARCore

Entre as várias ferramentas de RA disponíveis, esta subsecção destacará as desenvolvidas pelos fabricantes dos principais sistemas operativos de dispositivos móveis, focando-se na tecnologia usada para Android, dado que ser este o sistema operativo usado pela aplicação SolAR.

Em 2017, na WWDC (World Wide Developers Conference) a Apple apresentou a plataforma ARKit, vocacionada para o desenvolvimento de aplicações de RA para iPhone e iPad (Apple Inc, 2017). A plataforma correspondente para Android, ARCore, foi lançada no mesmo ano substituindo o Projecto Tango da Google, iniciado em 2016 (Leska, 2018).

A tecnologia Tango incorpora tracking de movimento e percepção de profundidade (Lee, 2017), o que a permite inferir a geometria do espaço envolvente sem necessidade de recorrer a GPS, Wi-Fi ou marcas naturais ou fiduciais, todas elas menos precisas que os sensores usados pela Tango (Scoble & Israel, 2016). Porém, pressupõe o uso de dispositivos específicos com câmara de detecção de profundidade como os smartphones Lenovo Phab 2 Pro e Asus ZenFone AR (Papagiannis, 2017).

O jogo Woorld, criado por Funomena LLC (Funomena LLC, 2016), é apenas compatível com os smartphones com tecnologia Tango, e usufrui do reconhecimento tridimensional do espaço, permitido por esta tecnologia, para tornar todos os objectos captados pela câmara partes integrantes de um jogo (Funomena, 2016). A Figura 2.17 é um screenshot desta aplicação, nela pode ver-se a perspectiva realista da água no chão que esta tecnologia permite, bem como a colocação da torneira sobre o plano correspondente ao ecrã da televisão.

Figura 2.15 - Simulação de correntes de ar em RA (Ritterbusch, Ronnas, Waltschläger, Gerstner, & Heuveline, 2013)

Figura 2.16 - Simulação da velocidade e distribuição de finas partículas de poeira em RA (Ritterbusch, Ronnas, Waltschläger, Gerstner, & Heuveline, 2013)

16

Figura 2.17 - Screenshot da app Woorld (Funomena LLC, 2016)

Uma vez que a tecnologia requerida pela Tango não se encontra na maior parte dos dispositivos contemporâneos, o lançamento da ARCore surge como uma estratégia da empresa para a sua disseminação massiva.

Google I/O é um festival anual de developers que reúne developers de todo o mundo, e onde vários peritos da Google partilham conhecimentos teóricos e práticos, bem como são apresentadas as novidades da empresa (Google, 2018). Na Google I/O de 2018 a realidade aumentada teve muita visibilidade, tendo sido apresentados vários avanços da ARCore, bem como sugeridas diversas práticas para a criação de aplicações de RA, tanto ao nível da visualização como da interacção.

Na conferência Google I/O de 2018 foram apresentadas as seguintes novidades da ARCore (Google Developers, 2018):

Detecção de superfícies planas horizontais, verticais e diagonais através do reconhecimento da estrutura física do ambiente que envolve o utilizador, recorrendo à análise da imagem captada pela câmara;

Estimação da luminosidade para acréscimo de realismo dos elementos virtuais, já que assim o processo de renderização toma em consideração informação sobre a luminosidade do ambiente em que ocorre a experiência de RA, retratando as mesmas condições nos objectos virtuais;

Possibilidade de criação de experiências partilhadas entre utilizadores recorrendo a

Cloud Anchors, isto é, a referências posicionais (anchors) que associam um

determinado conteúdo virtual (e seu estado) ao mundo físico, encontrando-se acessível a vários utilizadores em simultâneo. Esta partilha de conteúdo de RA está presente na app

Just a Line onde dois utilizadores podem, por exemplo, posicionar-se frente-a-frente,

ambos de smartphone apontado para o espaço entre os dois, e jogar o jogo três-em-linha “no ar”, desenhando primeiramente o “tabuleiro” no ecrã de um dos smartphones, e depois interagindo com o mesmo, acrescentando bolas e cruzes. A Figura 2.18 mostra o jogo três-em-linha a ser jogado via esta app (Google Creative Lab, 2018). Os Cloud

Anchors são cross-Platform, de modo que funcionam tanto para Android como para

iOS, permitindo a união de utilizadores com smartphones de sistemas operativos diferentes;

17

Figura 2.18 - Screenshot da app Just a Line (Google Creative Lab, 2018)

Construçãode“AugmentedImages”,istoé,deimagenspré-escolhidas que servem de “âncora” para uma experiência de RA; desta forma, quando o utilizador aponta o dispositivo para a imagem-âncora pré-escolhida para inicializar a experiência de RA, a câmara do dispositivo reconhece-a, imediatamente apresentado sobre a mesma os elementos virtuais que lhe foram associados.

Foi também apresentada uma ferramenta de renderização 3D, denominada Sceneform, que facilita o desenvolvimento de aplicações de RA ao dispensar, para já só em casos restritos, o uso directo do OpenGL. Esta ferramenta é para ser usada em conjunto com a ARCore: Sceneform funciona como rendering, ARCore como tracking.

2.6 Práticas recomendadas para RA

Na conferência Google I/O de 2018 foram sugeridas boas práticas para desenhar aplicações de RA, tendo sido destacados os seguintes cinco “pilares” para desenvolver aplicações de RA (Google Developers, 2018):

1) Compreensão do ambiente do utilizador para que a experiência gerada pela app esteja devidamente integrada no mesmo;

2) Planeamento do movimento do utilizador; 3) Inicialização natural da experiência de RA;

4) Elaboração de interacções naturais com os objectos; 5) Construção de interfaces volumétricas.

No âmbito do ponto 1 é referida a importância da identificação da escala dos elementos virtuais para a determinação do espaço necessário para que o utilizador “navegue” na experiência da app, discernindo entre Table Scale, Room Scale e World Scale.

A questão da escala também influencia o ponto 2, já que o modo como o utilizador se move no ambiente depende da proporção dos elementos virtuais existentes. Aplicações Room Scale ou World

Scale poderão conter elementos virtuais não visíveis, requerendo que o utilizador se mova no espaço

para que estes sejam revelados. Esta interacção tem paralelismo com a vida real, já que para encontrarmos objectos fora do nosso campo de visão precisamos de olhar noutras direcções, mas, dado que o utilizador-comum ainda não está habituado a lidar com interfaces que pressuponham este tipo de

18

movimento da sua parte – seja através da rotação do dispositivo, usando os braços, seja através da sua deslocação no espaço, mudando de localização - pode ser necessária a adição de marcas ao ecrã que assinalem a existência de objectos offscreen - deste modo, o utilizador saberá, não só onde encontrar os elementos virtuais, como também que precisa de mover o ecrã do dispositivo, ou deslocar-se no espaço, para os encontrar. Para o ponto 2 é também aconselhado o uso de animações que expliquem o movimento que deve ser efectuado no ecrã táctil.

No que diz respeito aos movimentos dos objectos virtuais, na mesma conferência de developers faz-se referência à importância de distinguir objectos virtuais móveis de objectos virtuais persistentes: os primeiros podem ver movidos após a sua colocação, enquanto os segundos ficam fixos a partir do momento em que são adicionados sendo, portanto, imutáveis. De modo a aprimorar a experiência do utilizador, este deverá conseguir prever as posições em que os objectos ficarão no espaço antes de a adição ser efectivada. Objectos móveis e persistentes devem ter diferentes representações, sendo aconselhadoosímbolo“+”paraosmóveiseaimagemdeumaâncoraparaospersistentes.

Relativamente ao ponto 4, é aconselhado o fornecimento de feedback quando ocorre uma colisão de objectos - como seria de esperar com objectos reais no mundo real – bem como o uso de contornos nos objectos que podem ser movidos.

A colocação de objectos por arrasto, a partir de uma galeria, é uma das sugestões fornecidas para a adição de objectos, mas salienta-se que esta galeria não deverá obstruir a vista do utilizador, já que quanto menos elementos 2D estiverem presentes na interface, maior o espaço de ecrã disponível para que o utilizador interaja com a app, dado que a imagem da câmara poderá ocupar mais espaço de ecrã, e, consequentemente, maior a experiência de RA. Só deve ser usado espaço de ecrã para controlos com elevada frequência de uso e para controlos que requerem rápido acesso.

No que diz respeito ao ponto 5, a interface deve permitir uma interacção directa com os elementos virtuais na própria cena, de um modo que reproduz as interacções reais com os objectos reais.

Várias práticas de RA aconselhadas pela Google foram seguidas neste projecto e serão referidas no capítulo da interface com o utilizador, fundamentando algumas das opções tomadas.

2.7 Biblioteca RUBI Glare e Visualização de Dados de Radiação

Solar

O desenvolvimento de uma aplicação de visualização de dados de radiação solar em RA iniciou-se com a criação da biblioteca RUBI Glare para a visualização de dados científicos em RA. A partir desta biblioteca foi desenvolvida uma aplicação para tablets que exibe os níveis de radiação solar, em tempo real, sobre as fachadas de vários edifícios pertencentes à Faculdade de Ciências.

De seguida destacar-se-á a importância de representar dados de radiação solar em RA e explicitar-se-á o já foi concretizado, pelas equipas do DI (Departamento de Informática) e do DEGGE, por forma a representar e analisar os mesmos.

2.7.1 Contextualização

A obtenção de energia a partir de fontes de energia renovável reduz os impactos ambientais e de saúde associados às energias fósseis e nuclear, diminuindo as emissões de gases com efeito de estufa.

19

Estima-se que 26.5% da produção de electricidade mundial em 2017 tenha tido origem em energias renováveis e que este valor continuará a aumentar.

No que respeita à energia solar fotovoltaica, os dados de 2017 revelam um crescimento superior aos anos anteriores, tendo a produção aumentado 98 GW, num total de 403 GW de capacidade solar fotovoltaica produzida durante o ano a nível global. O mercado de maior crescimento no uso desta energia foi a China, seguida pelos Estados Unidos (REN21, 2018). A Figura 2.19, proveniente do relatório Renewables 2018 da REN21 (Renewable Energy Policy Network for the 21th Century), ilustra a capacidade mundial global de energia solar fotovoltaica de 2007 a 2017.

Figura 2.19 - Capacidade mundial global de energia solar fotovoltaica de 2007 a 2017, por país ou região (REN21, 2018)

Globalmente, a expansão do mercado de energia solar em 2017 deveu-se essencialmente ao aumento da competitividade na área, ao aumento da procura por electricidade em países desenvolvidos e à consciência crescente do potencial da energia solar para atenuar a poluição, reduzir as emissões de dióxido de carbono e fornecer acesso energético (REN21, 2018).

A Figura 2.20 mostra o investimento mundial efectivado em 2017 nas várias tecnologias de energia renovável. A energia solar foi a única tecnologia a testemunhar um aumento em 2017 com um acréscimo de 18% de novos investimentos relativamente a 2016.

20

Em 2015 a Google lançou o Projecto Sunroof, focado na colocação de módulos fotovoltaicos sobre os telhados das casas, permitindo que as pessoas interessadas na aquisição desta tecnologia possam calcular os ganhos provenientes da sua instalação. Para já o serviço só contempla dados referentes a algumas porções de 50 estados dos EUA, mas prevê-se a sua extensão para mais estados e países (Project Sunroof, 2019). Já a nível nacional destaca-se o projecto SOLIS, iniciado em Agosto de2018,quetevecomoprincipalobjectivo“responder de forma inovadora ao desafio do aumento da produção de energia de origem solar na cidade de Lisboa” (lisboa e nova, 2018). Este projecto, enquadrado no desenvolvimento da Estratégia Solar de Lisboa (2018-2021), incluiu a actualização da carta do potencial solar de Lisboa e o desenvolvimento de um espaço virtual com capacidade para “reuniredivulgarsoluçõestecnológicasassociadasàproduçãodeenergiasolar” (lisboa e nova, 2018). Neste espaço é possível que um dado proprietário de edifícios, habitações e outros espaços obtenha o dimensionamento do sistema fotovoltaico óptimo a instalar.

2.7.2 Dados sobre radiação solar

Redweit et al. elaboraram um método para determinar o potencial solar de todas as superfícies (telhados e fachadas) dos edifícios de uma paisagem urbana, com uma resolução espacial de 1 m. Como resultado, o método mostra a radiação solar, de hora em hora, existente em todos os pontos das fachadas e telhados dos edifícios (Redweik, Catita, & Brito, 2013).

Como a radiação disponível à superfície terrestre (radiação global) é constituída por duas componentes: a radiação directa e a radiação difusa; é necessário ter em conta as contribuições destas duas componentes na estimativa da radiação solar que incide sobre as superfícies de um edifício. A radiação directa corresponde à fracção da radiação solar que atinge a Terra sem qualquer mudança de direcção. Já a radiação difusa provém da radiação reflectida pela superfície terrestre e pelos vários objectos existentes sobre a mesma (SOLUCIONA, 2010). Estas componentes são correctamente estimadas neste método e os resultados obtidos na sua aplicação a um caso de estudo confirmam-no.

Para caso de estudo foi usada uma área de cerca de 160 000 m2 pertencente ao Campus da Universidade de Lisboa que inclui nove edifícios principais. Para obter o modelo digital correspondente a esta área recorreu-se a um equipamento LiDAR (Light Detection and Ranging), transportado via aérea, cujo princípio de funcionamento consiste na emissão de um feixe laser, na gravação precisa do tempo de saída do feixe, na recepção da reflexão terrestre desse mesmo feixe e na gravação precisa do tempo de chegada; sendo as diferenças entre os tempos de emissão e reflexão convertidas em distâncias (GeoData, 2014).

Como resultado dos varrimentos do solo executados por este equipamento obtiveram-se as nuvens de pontos correspondentes à área referida, com uma densidade de 20 pontos por m2, reamostrados num raster com células de 1 x 1 m2, com uma precisão horizontal de 0.5 m, e vertical de 0.15 m (Pereira J. R., 2012).

Aos pontos obtidos foi então aplicado um modelo de radiação solar baseado nos típicos conjuntos anuais de dados meteorológicos associados à base de dados da SolTerm – um programa de análise de desempenho de sistemas solares térmicos e fotovoltaicos, especialmente ajustado às condições climáticas e técnicas de Portugal (SolTerm, 2012). Esta base de dados inclui valores médios, por hora, para as radiações solares (directa e difusa) horizontais calculadas ao longo de 30 anos de observações climáticas.

21

Combinando a nuvem de pontos obtida com os modelos tridimensionais previamente concebidos usando o software Trimble SketchUp foi possível visualizar o resultado do método elaborado por Redweit et al. sobre os modelos tridimensionais dos edifícios em estudo. Estes modelos 3D encontram-se definidos com um LoD igual a 3, conforme especificado no padrão CityGML

Do resultado da aplicação deste método foi possível extrair algumas conclusões sobre a radiação solar na área do Campus da Cidade Universitária que foi alvo de estudo:

1. Como seria de esperar, os níveis de radiação solar são muito mais elevados nos telhados e no chão do que nas fachadas verticais dos edifícios. Não obstante, no Inverno, as fachadas que se encontram orientadas para Sul recebem uma quantidade muito mais elevada de radiação solar, por metro quadrado, que os telhados;

2. Enquanto os telhados apresentam uma grande variação de potencial fotovoltaico ao longo das estações do ano, o potencial fotovoltaico nas fachadas direccionadas para Sul não varia muito;

3. O potencial total associado à área dos telhados é de cerca de 34 GW h/ano. Contudo, se adicionarmos a este valor o potencial correspondente à área das fachadas obtêm-se cerca de 53 GW h/ano (Redweik, Catita, & Brito, 2013).

As Figuras 2.21 e 2.22 mostram as imagens resultantes da aplicação deste método a uma área pertencente ao Campus da Universidade de Lisboa.

Figura 2.21 - Níveis de radiação global correspondentes à Primavera e ao Verão (Redweik, Catita, & Brito, 2013)

Figura 2.22 - Níveis de radiação solar anual de alguns edifícios da Faculdade de Ciências (Redweik, Catita, & Brito, 2013)