C

OMUNICACIÓN BIOMÉDICA

De los artículos publicados en revistas médicas, aproximadamente la mitad de los que incorporan métodos estadísticos los utilizan incorrectamente. Los errores

son

tan habituales que el sistema ac-tual

de revisión editorial no es capaz de evitarlos. Este artículo expone al- gunas reglas sencillas para ayudara los lectores a reconocer análisis esta- dísticos dudosos y a estimar lo que los autores habrían concluido si hubieran usado métodos estadísticos adecuados. Para evitar que estos errores se pu- bliquen, las revistas deben procurar que los manuscritos sean revisados an- tes de su aceptación por una persona con conocimientos estadísticos. Por otra parte, los comités de investigación en seres humanos deben exigir que el investigador concrete una estrategia adecuada para el análisis de los datos con anterioridad a la aprobación de un protocolo. Estas medidas incremen- tarían rápidamente la fiabilidad de la literatura biomédica.B

IOESTADÍSTICA: CÓMO DETECTAR, CORREGIR

Y PREVENIR ERRORES EN LA LITERAI’URA MÉDICA1

Stanton A. Glantz2

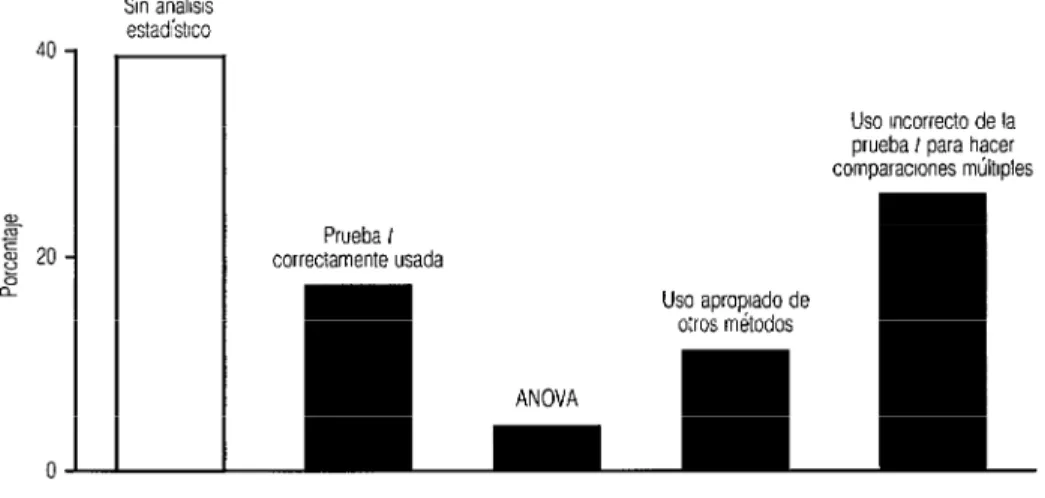

Pocos investigadores médicos han recibido capacitación formal en bioestadística. Como consecuencia, la mayorfa de los lectores suponen que cuando un articulo aparece en una revista los revisores científicos y los editores han sometido a un examen concienzudo cada frase del manuscrito, incluidos los métodos estadísticos. Por desgracia, esa no es la realidad. En las revisiones críticas de la literatura biomédica se ha visto una y otra vez que de los artículos que contienen métodos estadísticos, cerca de la mitad los usan incorrectamente (2 -6). Los artículos que aparecen en Circulation no son excepción a esa regla. La figura 1 expone los resultados de mi análisis del uso de procedimientos estadísticos en todos los artículos originales publicados en Circulation de julio a diciembre de 197% Hubo métodos estadísticos incorrectamente utilizados en 27% de los artículos y, del total de artículos con algún contenido estadístico, 44% tenían errores. Casi siempre se trataba de un uso incorrecto de la prueba t.

Es

un error fre- cuente que a menudo lleva a los autores a concluir que un tratamiento produjo un efecto,’ Publicado onginalmente con el título “Biostatistics: how to detect, correct and prevent errors in the medical hte- rature” en Cwculatfon 1980;61(1):1-7. Se traduce con permiso del autor y de la American Heart Assoclation, Inc 2 Instituto de Investigación Cardiovascular y Departamento de Medicina, Universidad de California, San Fran-

FIGURA 1. De 142 artlculos originales publicados en el volumen 56 de Circulafion (excluidas las secciones de radiologla, correlaciones clinicopatolbgicas y casos chicos), 39% no

contuvieron procedimientos

estadfsticos,

34% incluyeronuna

prueba tcorrectamenteusada

para comparar las medias de dos grupos, un análisis de la varianza (ANOVA) u otros métodos, y 27% utilizaron incorrectamente la prueba tpara comparar mgs de dos gruposSm análisis estadístlco

Uso mcorrecto de la prueba t para hacer comparaclones múltiples Prueba t

correctamente usada

cuando en realidad

los datos no apoyan tal conclusión. Cuando los lectores se enfrentan con esta realidad (o los resultados aparentemente contradictorios que surgen cuando artículos comparables llegan a conclusiones diferentes), a menudo concluyen que los análisis estadísticos pueden manipularse según convenga, o piensan que carecen por completo de interés o que son demasiado difkiles de entender.El problema

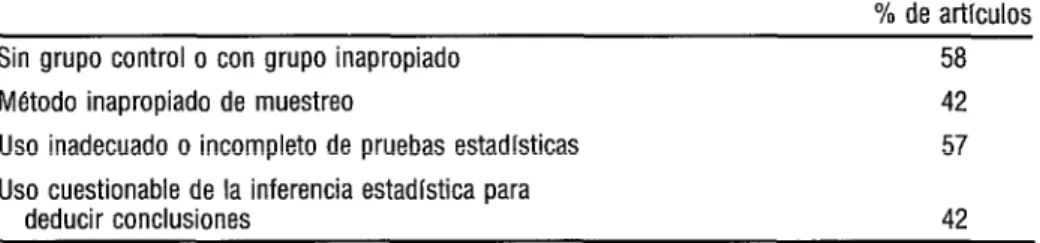

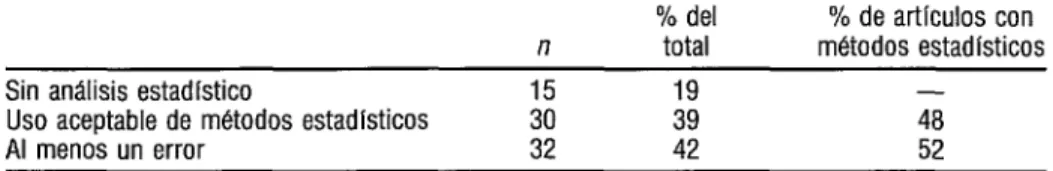

En 1951, Ross (1) publicó un análisis de 100 artículos escogidos al azar entre los publicados de enero a jumo de 1950 en cinco revistas médicas estadou- nidenses ~ournal of the Ameritan Medical Association, American ]ournal of Medicine, Annals of lnkrnal Medicine, Archives of Neurology and Psychiaty y Arnerkan Jawnal of Medical Science) y en los que se recomendaba o criticaba algún tratamiento o método. Un 63% de estos artículos correspondían a investigaciones con un grupo testigo inadecuado, o sin grupo control alguno. Badgley (2) estudió 103 artículos publicados en 1960 en dos revistas ca- nadienses y encontró que 58% de los experimentos no contaban con el grupo testigo adecuado (cuadro 1). La falta de grupo control sesga el estudio en favor del tratamiento (20). Badgley también comprobó que 57% de los artículos contenían pruebas estadísti- cas de evaluación de hipótesis utilizadas incorrectamente y que estos u otros errores cuestionaban las conclusiones de 42% de los artículos. Schor y Karten (3) publicaron un análisis detallado del uso de métodos estadísticos en 295 artículos que aparecieron en 1964 en 10 revistas médicas importantes: 53% de esos trabajos eran aceptables y 47% no lo eran (cuadro 2). Gore, Jones y Rytter (6) analizaron los trabajos publicados en la British Medical Journal durante un trimestre de 1976. Sus resultados son similares a los de Badgley y Schor y Karten: 42% de los artículos tenían al menos un error (cuadro 3). El cuadro 4 y la figura 1 exponen los resultados de mi análisis del uso de un método estadístico, la prueba t, en un volumen de Circulation Research y en otro de Circulatiorz. La prueba t es el procedimiento estadístico más popular en la inves- tigación biomédica (12). No revisé el diseño experimental ni tampoco consideré si ha- brfa sido conveniente usar métodos estadísticos en los artículos donde no los había. En

316

CUADRO 1. Canadian Medical Associaiion Joma/ y Canadian Joma/ of Public Health

(1960)

% de articulos Sin grupo control o con grupo inapropiado

Método inapropiado de muestreo

Uso inadecuado o incompleto de pruebas estadlsticas Uso cuestionable de la inferencia estadlstica para

58 42 57

deducir conclusiones 42

Basado en 103 trabajos de investigaclbn publicados entre el 2 de enero de 1960 y el 2 de lunlo del mismo afro Se excluyeron los casos cllmcos, las rewsiones, los trabajos descriptivos y los comentarlos blbliogrificos Las categorlas no son mutuamente excluyentes y en algunos artlculos se detectb mas de un tipo de error, de manera que tos porcentales no suman 100 Fuente Badgley (2).

CUADRO 2. Muestra de revistas cientfficas (1964)

Tipo de articulo n

Aceptable

n %

Analltico 149 41 28

Descripción de casos 146 114 78

Total 295 155 53

CUADRO 3. Britísh Medical Juurnal(1976)

Sin análisis estadístico

Uso aceptable de metodos estadísticos Al menos un error

n

Li: 32

% del % de artlculos con

total metodos estadísticos

39 iii

42 52

Basado en todos los artfculos y origmales (excluidos los artlculos descnptivos y notas breves) de los tres Mmeros de enero a marzo de 1976, 8% de los artlculos en los que se usaron métodos estadfsbcos haclan alguna aflrmaabn en el resumen que no estaba respaldada por fos datos presentados Fuente Gore et al (6)

CUADRO 4. Circulafiun Research (1977)

% del % de artículos con

n total metodos estadkticos

Sin análisis estadktico 20 25

Uso aceptable de la prueba f

36 20 27

Uso inadecuado de la prueba t 46 61

Análisis de la varianza 7 9 12

Basado en los 79 trabafos ongmales de invesbgacfbn publicados entre enero y fumo de 1977

46% de los artículos publicados en Circulafion Research y 27% de los publicados en Cir- culafion se usaba la prueba f en casos en los que lo apropiado habría sido un análisis de la varianza o una prueba de comparación múltiple (12). El menor porcentaje de pruebas f inapropiadas en Circulafion refleja el que la proporción de artículos que usaban algún método estadístico era menor en esta revista. Considerando solo los artículos que em- pleaban técnicas estadísticas, más o menos la mitad de los artículos de ambas revistas (61 y 44%, respectivamente) contenían errores.

¿Y qué importa?

¿Por qué persiste el problema?

318

Como son tantos los que cometen esos errores hay poca presión sobre los investigadores académicos para que usen las técnicas estadísticas más cuida- dosamente. Por el contrario, algunos investigadores temen que sus colegas -especial- mente los de los comités editoriales- puedan pensar que un análisis correcto es in- necesariamente teórico y complicado.

Las revistas constituyen el elemento principal para el control de calidad del trabajo científico. Algunas revistas han reconocido que los integrantes ha- bituales del comité editorial a menudo no son competentes para juzgar el aspecto es- tadístico de los trabajos remitidos para publicación y, consiguientemente, han modifi- cado el proceso de selección y revisión editorial. Por lo general, alguien familiarizado con métodos estadísticos evalúa el manuscrito antes de su aceptación (14-17). Sin em- bargo, muchos directores de revistas parecen suponer que los miembros del comité edi- tonal revisan los métodos estadísticos con igual atención que el protocolo clínico o la preparación del experimento. Si esta hipótesis fuera correcta cabría esperar que todos los artículos desu-ibieran el proceso de análisis de los datos con tanta meticulosidad como describen el protocolo o la preparación. En cambio, Feinstein (II) comprobó que no se especificaron la tercera parte (128 de 389) de los procedimientos utilizados para valorar la significación estadística en seis revistas médicas importantes, entre enero y junio de 1973. Schor y Karten (3) comprobaron más o menos lo mismo en una tanda de artículos publicados en 1964. Mi revisión de Circulafion Research y Circulafion reveló una situación parecida. Es difícil creer que los miembros de los comités editoriales revisan los méto- dos de análisis de los datos con la misma diligencia con la que examinan los experimen- tos utilizados para obtener los datos. De manera que, según Schor y Karten, los ma- nuscritos que se envían de ordinario a bioestadísticos para evaluación

suelen contener un montón de jerga estadística y con frecuencia un esta- dístico es coautor o colaborador en el trabajo. Así que los manuscritos que suelen enviarse a revisión estadística a menudo no la necesitan. Los traba- jos que solo mencionan algún valor de probabilidad o que no incluyen ter- minología estadística fueron en nuestro estudio los más necesitados de re- visión estadística. Sin embargo, bajo el sistema actual, estos son los trabajos que no revisan los bioestadísticos (3).

&Jué pueden hacer los lectores?

La solución de este problema implica una mejora de la calidad del análisis estadístico en la investigación biomédica. Mientras tanto, algunas reglas bási- cas pueden ayudar al lectora detectar posibles errores ya estimar lo que el autor habría concluido si hubiera aplicado correctamente los métodos estadísticos adecuados a los datos. Hay que tener en cuenta tres aspectos: a) la diferencia entre la desviación están- dar y el error estándar de la media; b) el significado del valor P; y c) los errores habituales cuando se usa la prueba f y la manera de subsanarlos.

La diferencia entre la desviación estándar y el error

estándar de la media

dia). La desviación estándar y el error estándar (de la media) son dos cosas distintas que no cuantifican lo mismo.3

Cuando la variable que se observa se comporta de tal manera que las observaciones se distribuyen igualmente por encima o por debajo de la media, y es más probable que estén cerca de la media que lejos, tiene sentido cuantificar la disper- sión de los datos mediante la desviación estándar. En esa circunstancia, la desviación estándar tiene la útil propiedad de que aproximadamente 68% de las observaciones es- tán alejadas menos de una desviación estándar de la media, y aproximadamente 98% de las observaciones estan a menos de dos desviaciones estándares. Esta propiedad hace que la desviación estándar sea un buen índice para resumir la variabilidad de los datos con una sola cantidad.

Por ejemplo, si un articulo dice que la tensión arterial (TA) dias- tólica en los adultos sanos es 78 -I 6 mm Hg (media + DE), eso implica que aproxi- madamente 95% de los adultos sanos tienen una TA diastólica a menos de 2 x 6 mm Hg = 12 mm Hg de la media, que es 78 mm Hg, lo cual quiere decir que ese 95% de los adultos tendrán una TA diastólica entre 66 y 90 mm Hg. La sencilla regla de las “dos desviaciones estándares“ podrfa formularse así: Cuando las observaciones se distribuyen si- milarmente por encima y por debajo de la media (o puede suponerse que es así) y es más probable que estén cerca que lejos de la media, 95% de las mismas estarán a menos de dos desviaciones es- tándares por encima o por debajo de la medin.

Sin embargo, muchos autores no resumen la variabilidad de sus datos mediante la desviación estándar sino que usan el error estándar de la media. Pero a diferencia de la desviación estándar, el error estándar de la media no es un buen índice de la variabilidad de las observaciones ni da al lector una idea de su dispersión. Enton- ces ipor qué muchos autores usan el error estándar de la media para resumir sus datos? En primer lugar, por tradición. En segundo lugar, porque el error estándar de la media es siempre menor que la desviación estándar. Si un autor indica el error estándar de la media (EEM) y el tamaño de la muestra (n), el lector puede calcular la desviación están- dar (DE) mediante la fórmula DE = EEM x fi.

Confundir el error estándar de la media con la desviación estándar puede ser peligroso. Por ejemplo, supongamos que en un articulo se indica que la TA diastólica de nueve adultos sanos fue 78 i 2 mm HG (media 2 EEM). iQué intervalo de TA diastólica incluirá aproximadamente 95% de las observaciones? El error estándar de la media es 2 y el tamaño muestra1 9, de manera que la desviación estándar es 2 mm Hg x fi = 2 mm Hg x 3 = 6 mm Hg. La respuesta es igual que antes, de 66 a 90

mm Hg. Por el contrario, si aplicáramos la regla de las dos desviaciones estándares po- niendo el error estándar de la media en vez de la desviación estándar, obtendríamos un intervalo de 74 a 82 mm Hg, que se queda corto en 16 mm Hg.

Entonces iqué es lo que mide el error estándar de la media? En un experimento casi nunca se estudian todos los elementos de una población, sino tan solo una pequeña muestra representativa. El valor medio o media de esa muestra es un es- timador de la verdadera media que se obtendría teniendo en cuenta todos los elementos

320

de la población. De la misma manera, la desviación estándar calculada con los datos de la muestra es un estimador de la verdadera desviación estándar de la población com- pleta. Si fuera posible tener datos de todos los elementos de la población no sería ne- cesaria la estadística; la inferencia estadística trata precisamente de hacer juicios sobre poblaciones grandes a partir de muestras de tamaño limitado.

Como la muestra utilizada para computar la media está formada por elementos extraídos al azar de la población sometida a estudio, no hay por qué pen- sar que esta muestra o su media tengan alguna caracteristica especial.

Si en la selección de la muestra hubieran resultado elegidos otros elementos, el investigador habría obtenido otros datos y una media muestra1 diferente. Una tercera muestra obtenida al azar habrfa rendido una tercera colección de datos y otra media. Cada una de esas tres muestras tiene una media muestra1 y cada una de esas medias muestrales es un estimador de la verdadera media poblacional (que no ob- servamos). En teorfa, podrían calcularse las medias de todas las posibles muestras que contuvieran el número de observaciones que el investigador quería obtener. En gene- ral, cada una de estas medias muestrales diferirá de las demás, pero todas ellas se amontonarán alrededor de la verdadera media que obtendrfamos si fuera posible tener en cuenta a todos los elementos de la población. La desviación estándar de todas las posibles medias muestrales es el error estándar de la media [o simplemente, error estándar].

El error estándar de la media no cuantifica la variabilidad de las ob- servaciones, como hace la desviación estándar, sino la precisión con la que una media muestra1 estima la verdadera media poblacional. Como el error estándar de la media es la desviación estándar de la colección de todas las posibles medias muestrales, pode- mos aplicar la regla de las dos desviaciones estándares para obtener lo siguiente: Hay aproximadamente una posibilidad de 95% de’que la uera’adera media de la población de la que se extrajo Ia muestra esté a menos de dos errores estándares de la media muesfral. De manera que el error estándar de la media cuantifica la certeza con que puede estimarse la verdadera media poblacional a partir de la muestra.

Volviendo al ejemplo de la TA diastólica podemos decir que la muestra de nueve adultos permite al lector tener una confianza de 95% en que la TA diastólica media de todos los adultos sanos está entre 74 y 82 mm Hg. Este hecho a me- nudo tiene interés, pero no nos dice nada sobre la variabilidad de los datos. Es la des- viación estándar la que aporta esa información. Por lo tanto, es la desviación estándar y no el error estándar de la media la que debe usarse al resumir los datos.

El significado del valor P

Las técnicas estadísticas no solo sirven para compendiar los datos sino también para que los investigadores evalúen si las observaciones son compatibles con sus hipótesis. El resultado de dicha evaluación es el llamado nivel de significación 0 valor P.

aleatorias extraídas de la misma población generan diferentes estimaciones de la media. De manera que se plantea la cuestión siguiente: La diferencia observada en las tempe- raturas medias de los dos grupos, jse deberá probablemente a la variación aleatoria aso- ciada con la asignación de los individuos a uno u otro grupo experimental o, por el con- trario, será efecto del fármaco?

Para responder a esta pregunta, lo primero que hacen los especia- listas en estadística es cuantificar la diferencia observada entre las dos muestras me- diante un número denominado “estadístico de la prueba”. El valor f es uno de estos estadísticos. Cuanto mayor sea la diferencia entre las muestras, mayor será el valor del estadístico de la prueba. Si el fármaco no tiene efecto, el estadístico de la prueba será pequeño. Pero iqué queremos decir con “pequeño”?

Para definir un límite entre “pequeño” y “grande” para los valores del estadístico más adecuado, los especialistas en estadística suponen que el fármaco no tiene efecto sobre la temperatura. Si esta suposición es correcta, los dos grupos de personas son realmente muestras aleatorias de una sola población que recibió un pla- cebo (ya que el fármaco no es más que un placebo). En teoría, el especialista en estadís- tica repite el experimento con todas las posibles muestras y calcula el estadístico de la prueba para cada experimento hipotético. Igual que la variación aleatoria produce va- lores diferentes de las medias de diferentes muestras, este procedimiento dará toda una gama de valores para el estadístico de la prueba. La mayor parte de esos valores serán relativamente pequeños, pero “la mala suerte” exige que unas pocas muestras no sean representativas de toda la población. Estas muestras darán valores relativamente gran- des del estadístico de la prueba incluso si el fármaco no tiene efecto. Este ejercicio pro- duce solo unos pocos posibles valores del estadístico de la prueba, digamos 5%, por encima de cierto límite. El estadístico de la prueba es “grande” si excede dicho límite. La mayor parte de los textos de estadística contienen tablas en las que se tabulan dichos valores limites.

N 0: N

322

Muchos piensan que el valor P es la probabilidad de cometer un error. Pero, obviamente, hay dos formas de cometer un error a partir de los datos. Puede afirmarse que el tratamiento tiene un efecto cuando en realidad no lo tiene y también puede negarse que tenga un efecto que en realidad sí tiene. El valor P solo cuantifica la probabilidad de cometer el primer error (el error de tipo 1): afirmar erróneamente que el tratamiento tiene un efecto cuando en realidad no lo tiene. El valor P no da informa- ción alguna sobre la probabilidad de cometer el segundo tipo de error (error de tipo II): concluir que el tratamiento no tiene efecto cuando en realidad lo tiene.

Errores comunes al usar la prueba t y maneras de subsanarlos

La prueba f se usa para calcular la probabilidad de estar equivo- cado (el valor P) al afirmar que los valores medios de los dos tratamientos son diferen- tes. Es apropiada para evaluar la hipótesis de que el fármaco que se comentó no tiene efecto sobre la temperatura corporal.

La prueba f también se usa mucho, erróneamente, para ver si hay diferencias entre más de dos grupos mediante la comparación de todos los posibles pa- res de medias. Por ejemplo, supongamos que un investigador midió el gasto cardíaco bajo condiciones de control, en presencia del fármaco A y en presencia del fármaco B. Es común que se hagan tres pruebas

f

con estos datos: una para comparar el control con el fármaco A, otra para comparar el control con el fármaco B y una tercera para com- parar el fármaco A con el fármaco B. Esta práctica es incorrecta porque la verdadera probabilidad de concluir erróneamente que el fármaco tuvo un efecto sobre el gasto car- díaco es realmente mayor que el nivel nominal, digamos 5%, fijado al buscar en la tabla el límite “grande” del estadístico de la prueba.Para comprender esta idea volvamos al experimento descrito en el último párrafo. Si el valor del estadístico f calculado en una de las tres comparaciones

descritas se halla en el 5% más extremo de los valores que habrían ocurrido si el fármaco realmente no tuviera efecto, rechazaríamos esta hipótesis y afirmarfamos que el fár- maco cambia el gasto cardíaco. Estaremos satisfechos si P < 0,05 y en tal caso acepta- mos que una vez cada 20 nos equivocaremos. Así que al probar el control frente al fár- maco A esperamos afirmar erróneamente una diferencia 5% de las veces, y cuando comparamos el fármaco A con el B también esperamos equivocarnos de la misma ma- nera 5% de las veces. Por lo tanto, al considerar las tres comparaciones en conjunto, esperaremos concluir que al menos uno de los grupos es diferente en 5% + 5% + 5% = 15% de las ocasiones, incluso si los fármacos no alteran el gasto cardíaco. (El valor P es realmente 13% (12).) En general, una simple suma de los valores P obtenidos en comparaciones múltiples genera una estimación realista y conservadora del verdadero valor P para el conjunto de las comparaciones.

básicas: Acabaremos la discusión de la prueba f enunciando tres reglas

a) La prueba f debe usarse para evaluar la hipótesis de que las medias de dos grupos no son diferentes.

b) Cuando el diseño experimental implica varios grupos hay que usar pruebas tales como el análisis de la varianza ola generalización para múltiples gru- pos de la prueba f .

c) Cuando se utilizan pruebas f para evaluar diferencias entre

En el ejemplo anterior había tres pruebas t, de manera que el valor P efectivo sena 3 x 0,05 = 0,15, o 15%. Al comparar cuatro grupos hay seis posibles

pruebas f (1 y 2,l y 3,l y 4,2 y 3,2 y 4, y 3 y 4); de manera que si el autor concluye que hay una diferencia y hace constar que P < 0,05, el valor P efectivo será aproximada- mente 6 x 0,05 = 0,30; hay cerca de 30% de posibilidades de que al menos una de las

afirmaciones sea errónea si se concluye que los tratamientos tienen algún efecto. Estas reglas básicas pueden ayudar a los lectores a detectar y co- rregir los métodos estadísticos incorrectamente utilizados. Obviamente, sena mejor que esos errores no se publicaran o, mejor aún, que fueran corregidos en la fase inicial de la investigación.

iCómo pueden evitarse estos errores?

En primer lugar, los editores de revistas deben insistir en que los métodos estadísticos se usen correctamente. En segundo lugar, los comités de investi- gación no deben aprobar experimentos en seres humanos si el estudio propuesto está malamente diseñado o no se define un análisis correcto de los datos que se obtengan. Estas dos medidas forzarán a los investigadores médicos a aprender suficiente estadís- tica para diseñar sus experimentos y analizar los datos correctamente, reconociendo los casos en los que se requiera ayuda de un especialista en estadística. No se trata de que los especialistas clínicos se conviertan en estadísticos profesionales. Casi todos los erro- res en cuestión se deben a un uso incorrecto de métodos que se explican en casi todos los textos de estadística elemental. Tanto el rechazo de los informes como el de proto- colos haría que los investigadores se interesaran en aprender los rudimentos de la estadística.

La respuesta de los editores de Circulatim Reseurck a este problema fue ejemplar. Tras examinar el análisis de cada articulo individual cuyos resultados muestra el cuadro 4, enviaron dicho análisis a los miembros del comité editorial. Una vez considerados los comentarios recibidos, los editores anunciaron que se iba a revisar el mecanismo de revisión de los manuscritos

Esta política está justificada por tres razones. En primer lugar, el punto clave del proceso de selección sigue siendo el mismo: los miembros del comité editorial que son competentes para evaluar los aspectos científicos de los que trata el trabajo. Una vez que la importancia científica de la cuestión ha sido establecida, puede que el trabajo siga siendo publicable incluso si el revisor estadístico señala un error que cambia sustancialmente las conclusiones. En segundo lugar, si los editores hacen cir- cular la revisión estadística del trabajo entre los miembros del consejo editorial, eso puede ser útil para la formación estadística de estos. En la medida que los revisores del comité editorial sepan estadística básica, será posible volver al método de selección anterior en el que el mismo revisor debía evaluar los métodos experimentales y el análisis de los datos. En tercer lugar, si esto es más importante, hay datos concretos que prueban que esta política mejora la calidad de la revista de manera rápida y eficaz. Según Schor (IB), en una revista se puso en marcha esa política (se trataba delfournal of

fke

Ameritan Medi- cal Associafion) en 1964 y 21 meses después se comprobó que tres cuartas partes de los artículos se juzgaban aceptables desde el punto de vista estadístico, cuando la propor- ción correspondiente antes de 1964 había sido tan solo de un tercio.Los comités de investigación en seres humanos tienen otra finali- dad, pero igual que las revistas científicas, tienen responsabilidad y poder para conse- guir mejoras, al menos en lo que respecta a estudios clínicos. No es ético exponer a pa- cientes a un riesgo para obtener datos en una investigación que no tenga validez científica. Además, el número de personas incluidas en el experimento debe minimizarse, ya que los experimentos bien diseñados y cuidadosamente analizados suelen requerir una muestra más pequeña que los estudios con un diseño defectuoso. Los comités de in- vestigación en seres humanos tienen la responsabilidad de evaluar la calidad científica de las propuestas de investigación (19) y, por tanto, es exigible que integren algún miembro capaz de dar una opinión calificada sobre el diseño experimental y el plan de análisis de los datos. Algunas instituciones ya siguen la norma de incluir un estadístico en el comité de investigaciones pero otros centros no tienen departamento de bioestadística, de manera que cuentan con pocas personas a quienes pedir una opinión fundada. Ade- más de las consideraciones éticas, la buena práctica científica exige que el plan de aná- lisis de los datos se especifique antes de la recogida de datos cuando lo que se pretende es verificar una hipótesis específica.

Estas sugerencias difieren de las de otros autores que han seña- lado correctamente la necesidad de mejorar la formación de los futuros médicos o hacer que los investigadores médicos consulten con estadísticos (6,15,16). Los estudiantes y los investigadores deben recibir cursos formales de estadística aplicada, aunque solo sea para que adquieran una actitud más escéptica hacia la literatura, pero a corto plazo eso no producirá ninguna mejora en las publicaciones. Hasta que la indiferencia hacia la estadística y otros tipos de razonamiento deductivo desaparezcan en buena parte de las facultades de medicina, esos cursos tendrán probablemente poco efecto.

Los consultores especialistas en estadística pueden ayudar, pero, como ya se dijo, la mayor parte de los errores se deben al mal uso de técnicas elemen- tales que los investigadores deberían aprender a utilizar por sí mismos. La mayoría de los estadísticos profesionales (e incluso los aficionados) no tienen especial interés en desmenuzar procedimientos estadísticos comunes y corrientes para otras personas. Más importante es, además, que salvo raras excepciones, nadie puede hacer un mejor aná- lisis de los datos que el investigador que los obtuvo a partir de un ensayo clínico o un procedimiento experimental.

Agradecimiento

Agradezco sus sugerencias para mejorar este manuscrito a los si- guientes colegas: D. Allison, S. Alten, S. Ashley, W. Benge, B. Brundage,

B.

Brown, K. Chatterjee, M. Cheitlin, J. Comroe, D. Freedman, H. Gelberg, D. Heilbron, J. Hoff- man, A. Jonsen, N. McCkll, G. Meir, J. Moore, W. Parmley, C. Peck, N. Phillips, T. Ports, I? Renz, M. Rosen, S. Rubin, S. Schroeder, D. Stanski, C. Zippin. Quiero dar también las gracias a M. Gruen y M. Hurtado por la mecanografía del texto y a M. Briscoe por la preparación de la ilustración.Referencias

1. Ross 08 Jr. Use of controls in medical research. JAMA 1951;145:72.

2. Badgley RE An assessment of research methods reported in 103 scientific artides from two Cana- dian medical joumals. Can Med AssocJ. 1961;85:2&.

3. Schor S, Karten 1. StatisticaI evaluation of medical joumal manuscripts. ]AMA. 1966;195:1123. 4. Schoobnan HM, Becktel JM, Best WR, Johnson AE Statistics in medical research: principies versus

practices. 1 Lnb Ch Med. 1968;71:357.

5. Lionel NDW, Herxheimer A. Assessing reports of therapeutic trials. Br Med 1. 1970;3:632 6. Gore S, Jones IG, Rytter EC. Misuses of statistical methods: critica] assessment of articles in B.M.J.

from January to March, 1976. Br MedJ. 1977;1:85.

7. Weech AA. Statistics: use and misuse. Aust Pediaf 1. 1974;10:328.

8. Hoffman, JIE. The incorrect use of chi-square analysis for paired data. Ch Exp Immunol. 1976;24:222 9. Glantz SA, ParmIey WW Factors which affect the diastolic pressure-vokune curve. Cirr Res. 1978;42:171. 10. Freedman D, Pisani R, Purves R. Statistics. New York: Norton; 1978:7-9.

ll. Feinstein AR. CIinical biostatistics: N, survey of the statistical procedures in general medical jour- naIs. Clrn I%rmurcoI Ther. 1974;15:97.

12. Zar JH. Biosfutzsticul nnn/ysis. Englewood CIiffs, New Jersey: Prentice HaII, Inc; 1974130-131. 13. Thomas L. Biostatistxs in medicine. Science. 1977;198:675.

14. Shuster JJ, Biion J, MoxIey J, Wairath N, Grassmuck D, Mahnks D, Schmidt J. Statistical review process; recommended procedures for biomedical research articles [letter] JAMA. 1976;235:534. 15. A pillar of medicine [editor&]: IAMA. 19661951145.

16. StatisticaI errors [editorial]: Br MedJ. 1977;1:66.

17 Rosen MR, Hoffman BE Stausucs, biomedical scientists, and Ciculation Research [editorial]. Circ Res. 1978:42:739.

18. Schor S. Statistical reviewing program for medical manuscripts. Am Statisfician. 1967;21:28. 19. U.S. National Commission for Protection of Human Subjects of Biomedical and Behavioral Re-