Il s'agissait par exemple de l'analyse du trafic routier autour d'un rond-point, avec un capteur placé en son centre. C'est une méthode volumétrique qui modélise une scène sous la forme d'un tableau 3D dans lequel chaque cellule est un voxel.

Introduction

Les technologies de capteurs de capture 3D détaillées dans les paragraphes suivants concernent donc les capteurs de numérisation 3D sans contact actifs ou passifs. Le chapitre 1 est structuré comme suit : la première partie aborde les capteurs actifs de capture 3D tels que les télémètres ou les capteurs actifs à lumière structurée.

Perception 3D par capteurs actifs : télémétrie et triangulationtriangulation

Télémétrie

L'onde réfléchie par l'objet est également une onde modulée en amplitude, mais déphasée par rapport à l'onde émise. Le déphasage entre l'onde émise et l'onde réfléchie est proportionnel à la distance entre le capteur et la cible, à la vitesse de propagation de l'onde v et à la fréquence de modulation Fm.

Triangulation active en lumière structurée

La différence de fréquence entre l'onde émiseFe(t) et l'onde reçue Fr(t) est proportionnelle à la distance D entre le capteur et la cible : Fe(t)−Fr(t) = ∆F2DvT, où 4F est l'amplitude des fréquences entre le signal émis et celui reçu et T est la période des signaux. a) Télémétrie en mesurant le temps de vol. Ce plan, d'équation connue, fait apparaître sur l'objet un segment marqué détecté par le capteur d'image.

![Fig. 1.1 – Technologie de capteurs par télémétrie [82].](https://thumb-eu.123doks.com/thumbv2/1bibliocom/467102.71676/26.892.246.649.142.1120/fig-1-1-technologie-capteurs-par-télémétrie-82.webp)

Synthèse

En effet, la correspondance entre la matrice de points projetée et les données observées par le capteur n'est pas anodine puisque rien ne permet de distinguer un nœud d'un autre nœud dans l'image [48]. Enfin, un inconvénient commun aux deux technologies est le caractère actif de la mesure, ce qui fait que l'estimation de la distance entre le capteur et la cible utilise l'émission d'un signal.

![Fig. 1.2 – Technologie de capteurs par triangulation active en lumière structurée [48].](https://thumb-eu.123doks.com/thumbv2/1bibliocom/467102.71676/28.892.255.677.133.1091/fig-technologie-capteurs-par-triangulation-active-lumière-structurée.webp)

Perception 3D par capteurs passifs : la vision

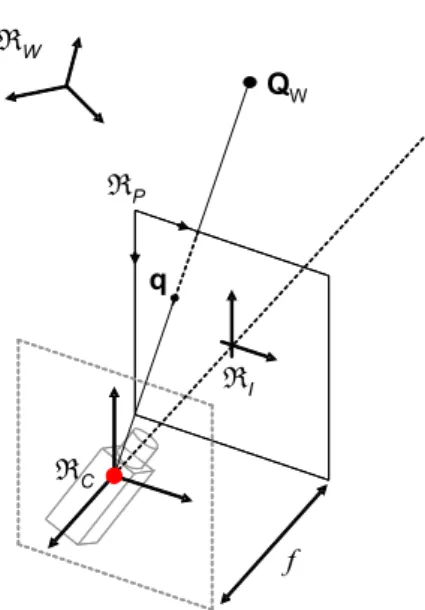

Capteurs de vision directionnelle

Le modèle de projection orthographique est un cas limite de projection perspective pour lequel la distance focale f tend vers l'infini (voir figure 1.5). Le modèle de projection orthographique qui établit la relation entre un point 3D QC = (XC, YC, ZC,1)>défini dans un référentiel cameraRC et sa projectionq= (u, v,1)>.

![Fig. 1.5 – Le modèle de projection orthographique [61]](https://thumb-eu.123doks.com/thumbv2/1bibliocom/467102.71676/33.892.357.554.147.449/fig-1-le-modèle-de-projection-orthographique-61.webp)

Capteurs de vision omnidirectionnelle

Un capteur catadioptrique est la combinaison d'une caméra et d'un miroir de courbure convexe ou concave, la caméra observe le miroir (voir figure 1.9). La contrainte de point de vue unique est alors définie comme la condition que tous les rayons issus du point focal (« sténopé effectif »), qui coupent le miroir, semblent converger en un point : le point de vue unique (« point de vue effectif »). ) le foyer du miroir [6] (voir figure 1.10b).

![Fig. 1.6 – Exemples de capteurs cylindrique et sphérique développés conjointement par le Laboratoire des Instruments et Systèmes d’Ile de France (LISIF, nouvellement ISIR) et l’Institut Supérieur d’Electronique de Paris (ISEP) [133], [42].](https://thumb-eu.123doks.com/thumbv2/1bibliocom/467102.71676/37.892.167.752.148.580/cylindrique-développés-conjointement-laboratoire-instruments-nouvellement-supérieur-electronique.webp)

Synthèse

1.12 – Autres exemples de configurations matérielles pour capteurs catadioptriques centraux. a) capteur hypercatadioptrique : une caméra perspective observant un miroir hyperboloïdal à deux couches de rotation. La détermination de la caustique est donc très intéressante, car cette surface décrit complètement le miroir.

![Fig. 1.13 – Deux illustrations de courbes caustiques pour des capteurs non-centraux [136].](https://thumb-eu.123doks.com/thumbv2/1bibliocom/467102.71676/44.892.190.752.138.458/fig-13-illustrations-courbes-caustiques-capteurs-centraux-136.webp)

Capteurs de stéréovision omnidirectionnelle

Quelques exemples de capteurs

Lhuillier [88] utilise une séquence d'images acquises par un capteur monoculaire catadioptrique mobile pour des applications en reconstruction 3D d'environnements. Ghandi & Trivedi [50] fixent un système de vision stéréo omnidirectionnelle au toit d'un véhicule pour la détection des piétons.

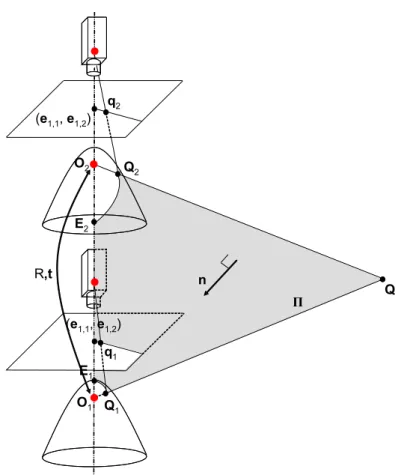

Géométrie épipolaire

Les points sont projetés sur l'image à l'aide des correspondances établies lors de la calibration du capteur. Le nombre de points en élévation détermine le nombre de lignes de l'image dépliée et le nombre de points en azimut définit le nombre de colonnes.

![Fig. 1.15 – Géométrie épipolaire pour des capteurs perspectifs [21].](https://thumb-eu.123doks.com/thumbv2/1bibliocom/467102.71676/49.892.301.644.435.770/fig-1-15-géométrie-épipolaire-capteurs-perspectifs-21.webp)

Conclusions

Ensuite deux cas sont présentés : le premier représente une configuration générale des deux capteurs catadioptriques, c'est-à-dire que leur positionnement dans l'espace 3D n'est pas limité. Dans le cas spécifique d'un canapé stéréoscopique coaxial, la rectification consiste à projeter l'image omnidirectionnelle sur un cylindre et à l'étendre : les lignes épipolaires sont alors des colonnes dans l'image panoramique, ce qui simplifie grandement le processus de couplage.

Introduction

Une cinquième partie présente les résultats obtenus pour l'étalonnage paramétrique du capteur, suivie d'une discussion dans laquelle une analyse critique est formulée.

Proposition d’une solution matérielle

Caractéristiques matérielles et techniques

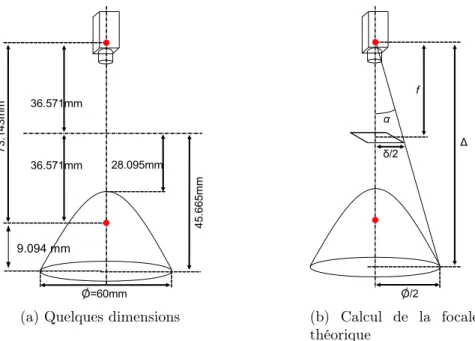

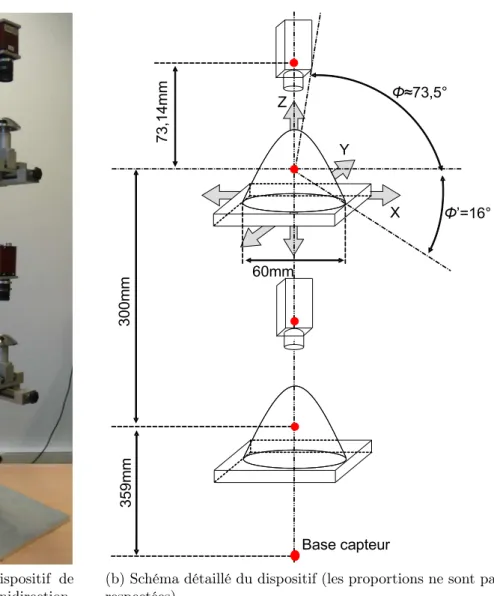

Où δ = 4,8 mm indique la hauteur du capteur CCD, φ = 60 mm indique la largeur de l'objet observé (diamètre du miroir) et représente la distance à laquelle se trouve l'objet du point principal de la caméra. Le point principal de la première caméra est placé verticalement à une distance de 359 mm de la base du capteur.

Réglage du point de vue unique

Le cercle en pointillé rouge correspond à la projection théorique du bord extérieur du miroir lorsque l'ensemble caméra-miroir respecte la contrainte de point de vue unique. Le but est alors d'ajuster mécaniquement le miroir pour que le bord extérieur du miroir réellement observé coïncide avec le bord pré-estimé.

Etalonnage de capteurs catadioptriques

Modèles de capteurs centraux et non-centraux

Figure 2.5 - Détails de projection de points 3D pour des modèles de transformation ad hoc entre l'espace 3D et le plan image. Dans le cas de capteurs non centraux, l'évaluation de la transformation entre l'espace 3D et le plan image est complexe et coûteuse en temps de calcul.

Méthodes d’étalonnage

Geyer & Daniilidis [55] décrivent les propriétés de la matrice fondamentale d'un système parkadioptrique binoculaire et dans [57] ils définissent la géométrie épipolaire d'un capteur parkadioptrique mobile. Kang [76] propose une méthode d'auto-calibrage pour un capteur paracatadioptrique qui utilise une série d'images acquises par le capteur mobile.

Mesures de la précision d’un étalonnage

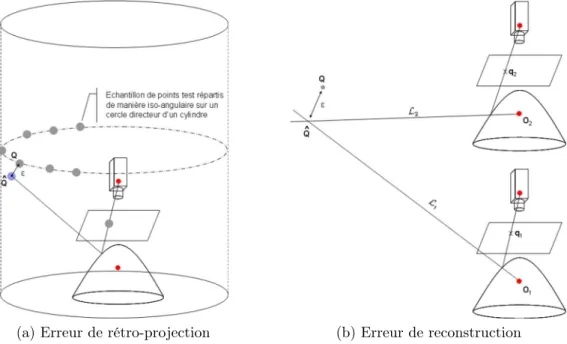

Si Qn est le nième point 3D de coordonnées connues et Qbn est le point 3D estimé, l'erreur de rétroprojection ∈¯ est donnée par . Pour un système multi-caméras, tel qu'une table de stéréovision, l'erreur de rétroprojection est très généralement définie comme l'erreur de reconstruction de primitives 2D appariées.

Etalonnage paramétrique par un modèle ad hoc

Modèles de projection et rétro-projection

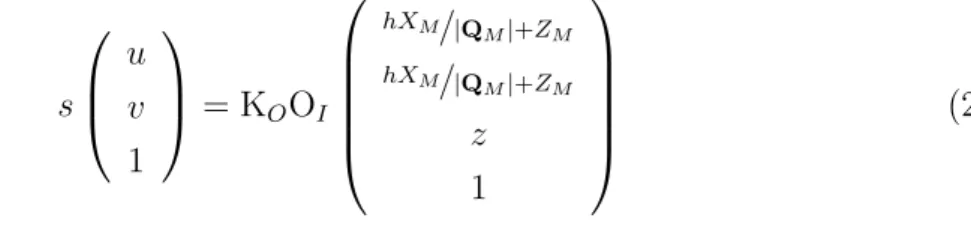

Soit Qla une quadrique et QM = (XM, YM, ZM)> un point 3D défini dans le repère miroir RM centré au foyer de l'hyperboloïde Q. Soit q = (u, v,1)> un point 2D défini en RP et LW la une ligne de visée dans l'espace 3D associée à q et définie dans le référentiel mondial RW.

Estimation des paramètres

Enfin, la ligne de visée 3D LW associée à q dans RW est obtenue à l'aide de la matrice de changement de base (RM |tM) et est donnée par . Soit (RM0,tM0) les valeurs initiales de la matrice de rotationRM et du vecteur de translationM.

La mire d’étalonnage

Caractéristiques techniques

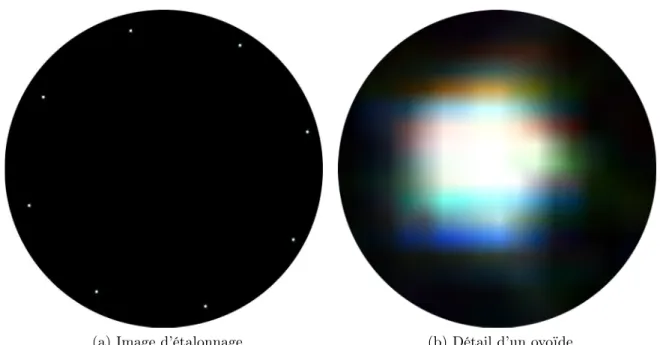

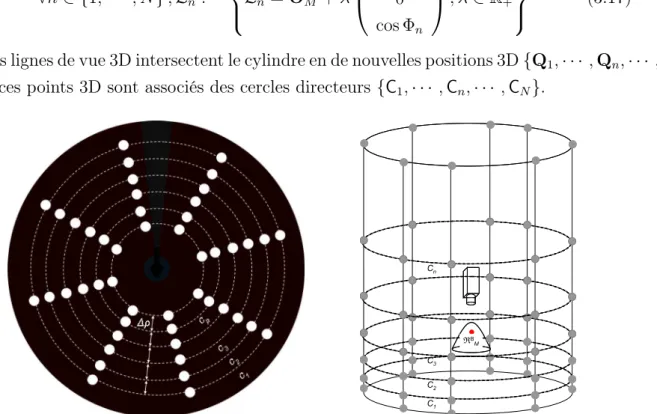

La cible est un cylindre rotatif dont les points d’intérêt 3D sont des LED blanches. Les LED sont positionnées au ras de la paroi interne du cylindre afin que la caméra observe le disque lumineux en 3D.

Extraction des points d’intérêt

Les ovaires sont ensuite extraits de l'image à l'aide d'un algorithme de segmentation par régions homogènes. L'influence des valeurs prises par le seuil s se fait principalement sur la surface de calcul de la forme de l'œuf, c'est à dire sur le nombre de pixels qui composent la tâche.

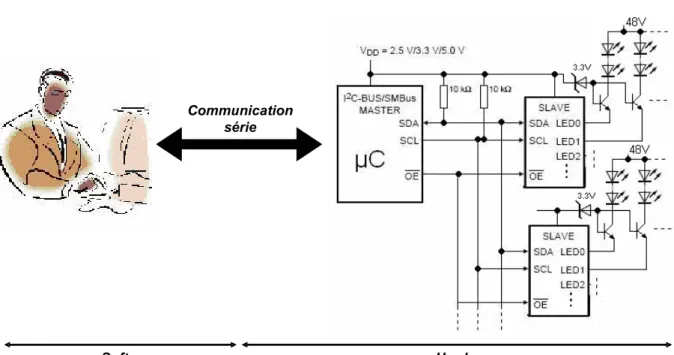

Dispositif d’aide à l’étalonnage

Le dispositif électronique (voir Figure 2.14) est constitué d'une carte principale qui comprend un microcontrôleur de type PIC et de cartes auxiliaires constituées d'un composant principal : MAX6956. Le MAX6956 est un driver de LED qui vous permet de modifier directement le courant de chacune des LED et permet seize niveaux de variation d'intensité.

Résultats

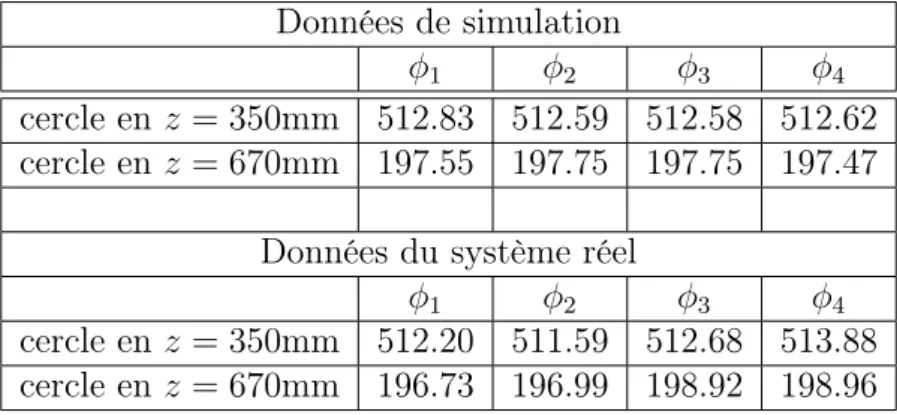

Environnement de simulation et protocole d’étalonnage

Fig.2.16 – Environnement d'étalonnage du capteur réalisé avec le logiciel de synthèse d'image POV-Ray.

Estimation des paramètres

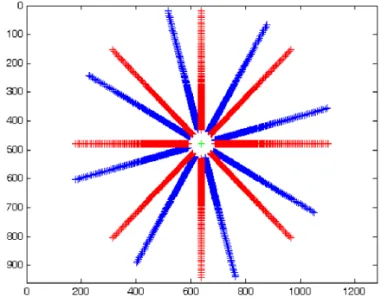

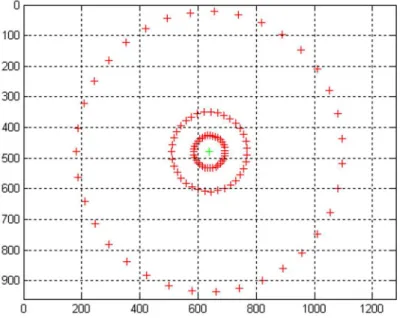

La figure 2.18 illustre les points 2D extraits et les points 2D estimés pour les valeurs du paramètre vectoriel χ?. Tracé des points 2D extraits des images de calibrage (en bleu) et des points 2D estimés (en rouge).

Discussion

Ce problème pourrait être envisagé différemment par des méthodes ne nécessitant pas d’orthonormalisation a posteriori. Cette notation présente néanmoins deux problèmes principaux : l'estimation de la matrice jacobienne est plus délicate et pour certaines configurations la perte d'un certain degré de liberté peut survenir (voir "gimbal lock.

Conclusions

Introduction

Etalonnage non-paramétrique par un modèle dis- cretcret

Principe

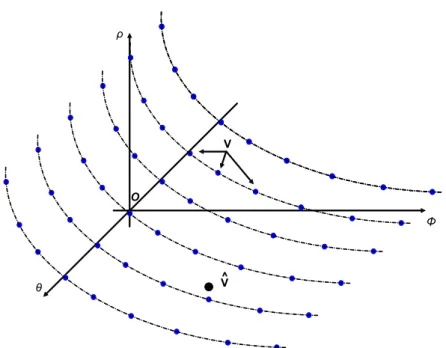

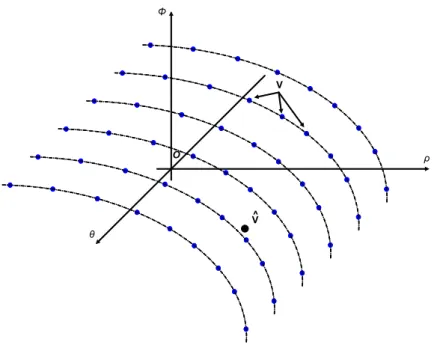

La ième paire point 3D-point 2D (Qi,qi) de la calibration correspond au point Vi dans ce nouvel espace, de sorte que Par conséquent, il est nécessaire de disposer d’algorithmes d’interpolation numérique pour estimer les approximations g et g* pour toutes les paires de points 3D-points 2D [2].

Projection

Un triangle de Delaunay permet de choisir le triplet de points {V1,V2,V3} dont les projections forment le triangle de Delaunay qui est la projection de V.b. Fig.3.4 – Dans l'espace des variables (θ,Φ, ρ), le triplet de points {V1,V2,V3} définit un plan Π.Vb appartient à Π et vérifie son équation, ce qui permet à la valeur du rayonρau-dessus du point 2D q.b.

Rétro-projection

Un triangle de Delaunay permet de choisir le triplet de points {V10,V02,V03} dont les projections forment le triangle de Delaunay contenant la projection de V.b. Vb appartient à Π0 et vérifie son équation, ce qui permet à la variable Φb du vecteur direction bd de la ligne de visée 3D L.b.

Conception d’une mire adaptée

Nombre de points d’intérêt par cercle directeur

L'estimation de l'équation de l'ellipse peut être considérée comme l'estimation de l'équation d'une conique dont la nature (parabole, hyperbole, ellipse, etc.) sera déterminée ultérieurement. Connaître le modèle analytique de l'ellipse permet de suréchantillonner cette dernière iso-angle pour recréer des paires de points 3D-points 2D supplémentaires.

Distribution verticale des cercles directeurs sur le cylindre

La répartition des cercles en 2D est inégale (image de synthèse dont les formes ovoïdes sont volontairement représentées par de grands panneaux blancs pour faciliter la compréhension des schémas). En d'autres termes, les cercles {C1,· · · ,Cn,· · ·CN} se projettent dans les cercles concentriques {c1,· · · ,cn,· · · ,cN} dans l'image omnidirectionnelle (l'axe de rotation du cible et l'axe optique du capteur colinéaire ) et la distance 4ρ entre deux cercles voisins etcn+1 est constante (voir figure 3.9).

Evaluation en simulation et sur le système réel

Protocoles expérimentaux et méthodes de validation

Erreur de rétroprojection : Pour estimer une erreur de rétroprojection du capteur, les cercles guides d'un cylindre sont projetés sur l'image omnidirectionnelle (voir Figure 3.10a). Le modèle de points 3D projeté est le suivant. rétroprojeté sur le cylindre, qui définit de nouveaux points 3D. L'erreur de rétroprojection est alors définie comme la distance euclidienne entre l'échantillon de points 3D initial et les points 3D estimés.

Résultats

Figure 3.13 - Erreur de rétroprojection pour une répartition uniforme des points d'intérêt 3D (données de mesure obtenues en simulation). Figure 3.20 - Erreur de rétroprojection pour la distribution ajustée des points d'intérêt 3D (données de calibrage obtenues en simulation).

Discussion

L'axe de rotation de la cible et l'axe optique du capteur ne coïncident pas idéalement, ce qui conduit au fait que la projection d'un cercle n'est pas un cercle, mais une ellipse dans l'image omnidirectionnelle. Soient Qm,i et Qm,j des points 3D appartenant à un cercle directeur du motif de calibration tel que Qm,i et Qm,j.

Conclusions

Introduction

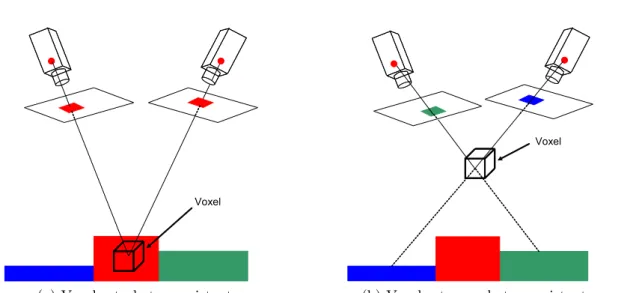

Le travail présenté dans ce chapitre se concentre délibérément sur la mise en œuvre et l’évaluation d’une méthode de reconstruction volumétrique spécifiquement pour le capteur de stéréovision binoculaire omnidirectionnel.

Reconstruction 3D volumétrique pour le capteur de stéréovision omnidirectionnellede stéréovision omnidirectionnelle

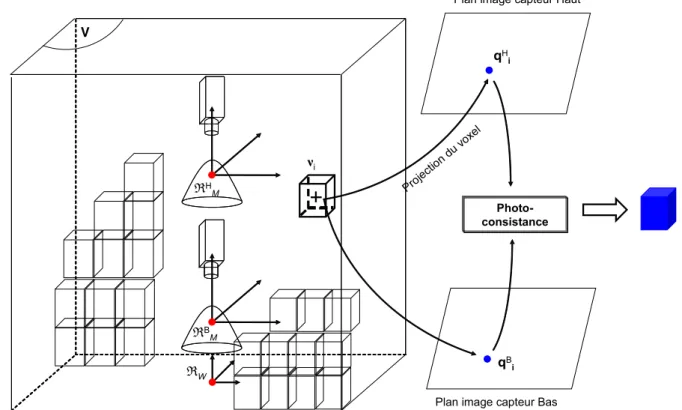

Principe général

Fig.4.1 – Principe de photocohérence d'un voxel. a) le voxel appartient à une surface et est donc photocohérent, b) le voxel n'est pas photocohérent car il n'appartient pas à une surface [143]. En fonction du résultat de photocohérence trouvé, une décision binaire (transparent-opaque) ou ternaire (transparent-opaque-invisible) décide de la nature du voxel projeté [41].

Applications au capteur de stéréovision omnidirectionnelle

4.1) s voici un seuil fixé par l'utilisateur pour confirmer ou infirmer le voxel νi appartenant à la surface de l'objet. La mesure de photocohérence utilisée pour cette définition de voxel est issue des travaux effectués par Seitz & Dyer [140].

Résultats

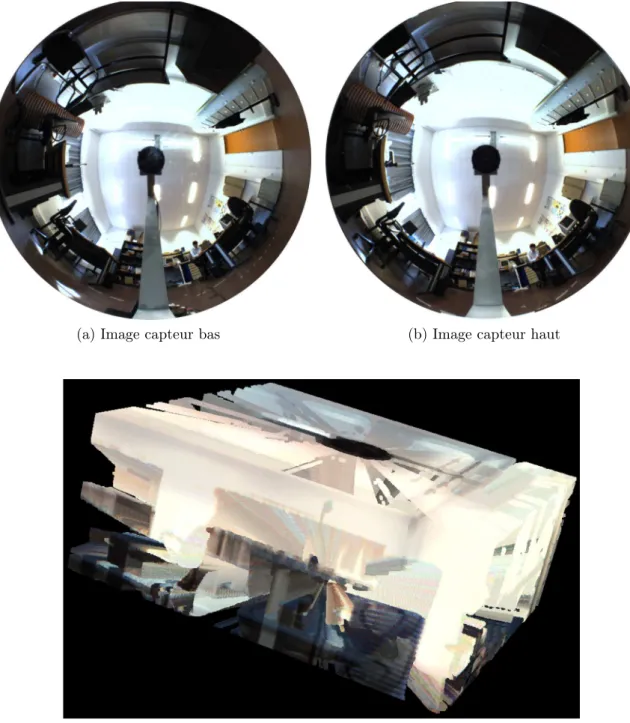

Reconstructions 3D statiques pour une scène réelle

4.6 – Vue d'une coupe du volume de reconstruction découpée dans le plan (YWOWZW), l'observateur est placé à l'intérieur du volume 3D. Fig.4.7 – Vue en coupe dans le plan (YWOWZW) du volume de reconstruction, l'observateur est placé à l'intérieur du volume 3D. La reconstruction 3D statique est obtenue pour une scène intérieure.

Reconstruction 3D dynamique par déplacements successifs du capteur pour une scène de synthèse

Discussion

Ils soulignent également le fait qu'à certains endroits (notamment près du pied de table), le volume de la reconstruction a été vidé. Les objets 3D sont reconstruits dans le volume de reconstruction et affichés sous forme de cônes 3D.

Conclusions

In IEEE Workshop on Theory and Practice of Vision Algorithms (in conjunction with the IEEE International Conference on Computer Vision), pp. In IEEE Conference on Computer Vision and Pattern Recognition, Volume 1, Pages 201-207, Hilton Head Island, USA, June 2000.

![Fig. 1.10 – Deux illustrations de la contrainte de point de vue unique [136].](https://thumb-eu.123doks.com/thumbv2/1bibliocom/467102.71676/40.892.193.743.710.1003/fig-1-10-illustrations-contrainte-vue-unique-136.webp)

![Tab. 2.1 – Paramètres caractéristiques pour le modèle de la sphère d’équivalence [9], [97]](https://thumb-eu.123doks.com/thumbv2/1bibliocom/467102.71676/71.892.304.636.629.929/tab-2-paramètres-caractéristiques-modèle-sphère-équivalence-97.webp)

![Fig. 2.6 – Détails de la projection d’un point 3D par le modèle unifié de la sphère d’équivalence [97].](https://thumb-eu.123doks.com/thumbv2/1bibliocom/467102.71676/72.892.210.730.144.679/fig-détails-projection-3d-modèle-unifié-sphère-équivalence.webp)