Rogério Largman Borovik

INTERFACE EXPANDIDA

O vídeo na comunicação on line

Mestrado em

Comunicação e Semiótica

PUC/SP

São Paulo

Rogério Largman Borovik

INTERFACE EXPANDIDA

O vídeo na comunicação on line

Dissertação apresentada à Banca Examinadora da Pontifícia Universidade Católica de São Paulo, como exigência parcial para obtenção do título de MESTRE em Comunicação e Semiótica – Signo e Significação nas Mídias, sob a orientação da Profa. Dra. Giselle Beiguelman.

Mestrado em

Comunicação e Semiótica

PUC/SP

São Paulo

ORIENTAÇÃO

Profª. Drª. Giselle Beiguelman

BANCA EXAMINADORA

____________________________________________

____________________________________________

Autorizo, exclusivamente para fins acadêmicos e científicos, a reprodução

total ou parcial desta dissertação por processos de fotocopiadoras ou

eletrônicos.

Assinatura:______________________

Agradecimentos

Aos meus pais, sem os quais nada disso seria possível.

À minha esposa Samira pelo apoio, amor e incentivo.

Aos meus irmãos Roberto, pela light glove e Sandra, pela ajuda com a Brigitte.

À Nicole S. L. Grosso, pela ajuda com as traduções.

Aos meus colegas Adriano Sousa, Aleph Eichemberg e, especialmente, a Almir Almas pela troca de informações.

Aos amigos Lucas Bambozzi e Marcus Bastos, pela iluminação de seus textos (trabalhos).

Ao Paulo Costa pelos links, livros e conversas nem sempre tranqüilas, mas sempre enriquecedoras.

À Rachel Rosalen, pelo apoio e pelos testes de streaming.

À Mariana Meloni e Tamara Brandão Guaraldo, pelas leituras generosas e observações precisas sobre o texto.

Ao Lúcio Agra, por ter me apresentado a Ursonate de Kurt Schwitters.

Ao Cris Scabello e Leo Videgal, pelos esclarecimentos a respeito do Dub.

Aos professores Arlindo Machado e Daniela Kutschat, pelas colocações precisas no Exame de Qualificação.

Aos coletivos Neo Tao, Formigueiro, Mídia Ka, Cobaia, Muda e Xiado, por criarem as condições de experimentação em software e linguagem.

Ao David Bowie, por Memory of Free Festival e à Juliana Pikel, pela trilha sonora.

Ao Paulo Roberto dos Santos, que tirou várias dúvidas do universo da informática.

Aos meus amigos das antigas, pelo apoio e em especial ao Marco Scabello, Mauricio Hermann & Fernão Salles.

Aos criadores Lodewijk Loos e Sher Doruff, pela entrevista e troca de conhecimentos.

Resumo

As novas condições dadas pelos avanços tecnológicos na contemporaneidade propiciaram diferentes maneiras de produção videográfica. Ao mesmo tempo em que garante a concentração de diversas atividades humanas em um único indivíduo, os processos inerentes ao universo digital contribuíram como ferramentas inéditas para a comunicação e produções colaborativas. O conceito de autoria é questionado tanto no fazer conjunto como no uso de material “reciclável”, de maneira que um substrato cultural considerado banal, cotidiano e descartável, pode ser transformado em matéria prima para a criação artística.

Esse estudo tem como objetivo principal apresentar um panorama histórico sobre o vídeo digital, estudando suas funções na comunicação on line; assim como analisar as possibilidades inscritas no software de autoração audiovisual Keyworx, que possui uma originalidade tanto em sua proposta conceitual, quanto em sua forma, interface e ação. O

Keyworx não é um produto confeccionado por uma empresa, mas sim um projeto

educacional da Waag Society, instituição de pesquisa holandesa. O software faz uma fusão de aspectos de ambientes de multi-usuário de tele-conferência, com os de software

processuais de mídia digital (popularmente conhecidos como “software de VJ”).

Uma discussão mais profunda sobre a interface do vídeo digital e seu funcionamento, mostrou ser de suma importância para a reflexão sobre as particularidades de um modelo de criação colaborativa em vídeo na rede. Nesse sentido, as teorias de Edmond Couchot, Lev Manovich, Arlindo Machado, Jay David Bolter, Richard Grusin e Giselle Beiguelman encontraram lugar de destaque em nosso estudo, pois elucidaram aspectos da natureza binária da mídia digital e suas implicações nos processos de autoria; assim como a realização de entrevistas com os criadores do Keyworx. Pudemos verificar que, a partir do vídeo digital na Internet, os papéis comunicativos entre o emissor e o receptor têm sua definição alargada, convertidos em interatores de uma comunicação dialógica, o que implica em mudanças em sua forma de criação e distribuição midiática.

Palavras-chave:

Abstract

The new conditions provided nowadays by technological advancements have made it possible to develop different ways of videographic production. While granting the concentration of different human activities within a single individual, the processes which are inherent to the digital universe have contributed as completely new tools to communication and collaborative productions. The concept of authorship is being questioned, both in the collective making and in the use of “recyclable” material, in such a way that a cultural substrate considered banal, every-day stuff and disposable can be transformed into raw material for artistic creation.

The main objectives of this study were to present a historical overview of digital video, studying its communication process, enhanced by the arising of the Internet, and to analyze the possibilities inscribed in the audiovisual authoringsoftware Keyworx, that is original both in its conceptual proposal and in its shape, interface and action. Keyworx is not a product manufactured by a company, but rather an educational project of the Waag Society, a Dutch research institution. This software makes a fusion of multi-user teleconference environment aspects with those of digital media process softwares (popularly known as “VJ software”).

A more profound discussion about the digital video interface and its functioning showed that it is of the utmost importance to a reflection on the particularities of a collaborative video creation model on the net. In this sense, the theories of Edmond Couchot, Lev Manovich, Arlindo Machado, Jay David Bolter, Richard Grusin and Giselle Beiguelman have occupied a key position in this study, because they elucidate aspects of the binary nature of digital media and their implications in the authoring processes, along with interviews with the creators of Keyworx. We could observe that, ever since the beginnings of digital video on the Internet, the communication roles between the sender and the receptor had their definition broadened, converted into interactors of a dialogical communication, which implies changes in the way they are created and distributed in the media.

Key words:

Sumário

Agradecimentos... 5

Resumo... 6

Abstract... 7

Lista de Figuras... 9

Introdução... 10

1. VÍDEO DIGITAL... 1.1. Tecnocultura... 1.2. Antecedentes... 1.3. O computador como gerador e conversor de mídias... 1.4. Edição linear, não-linear e a Moviola... 17 17 21 27 33 2. VÍDEO NA INTERNET... 2.1.Conceituações... 2.2. Streaming e Download...…………... Live video streamings - Streamings ao vivo...………..….. 2.3. Codecs... 2.4. Meios de difusão na rede... · P2P...…... · Videomixers... · Cultura Remix ... ·Videoblog... 40 40 47 50 54 59 66 69 77 80 3. INTERFACE EXPANDIDA – Edição Emergente ... 3.1. Proposta de Software: Final Cut Pro e KeyWorx... 3.2. Conceitos estéticos: reflexões sobre Interfaces... 3.3. Outputs no FC e no KW: as saídas Viewer, Render e Realizer... 84 87 92 104 Conclusão... 110

Referências Bibliográficas... 115

Lista de Figuras

Fig.1 - Representação do número 87.654.321... 22

Fig.2 - telégrafo-copiadora de Alexander Bain... 23

Fig.3 - sinal analógico e digital fonte: ... 24

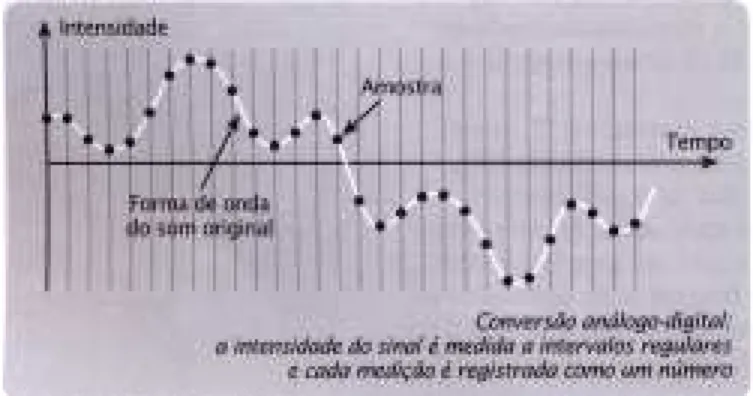

Fig.4 - conversão análogo digital... 26

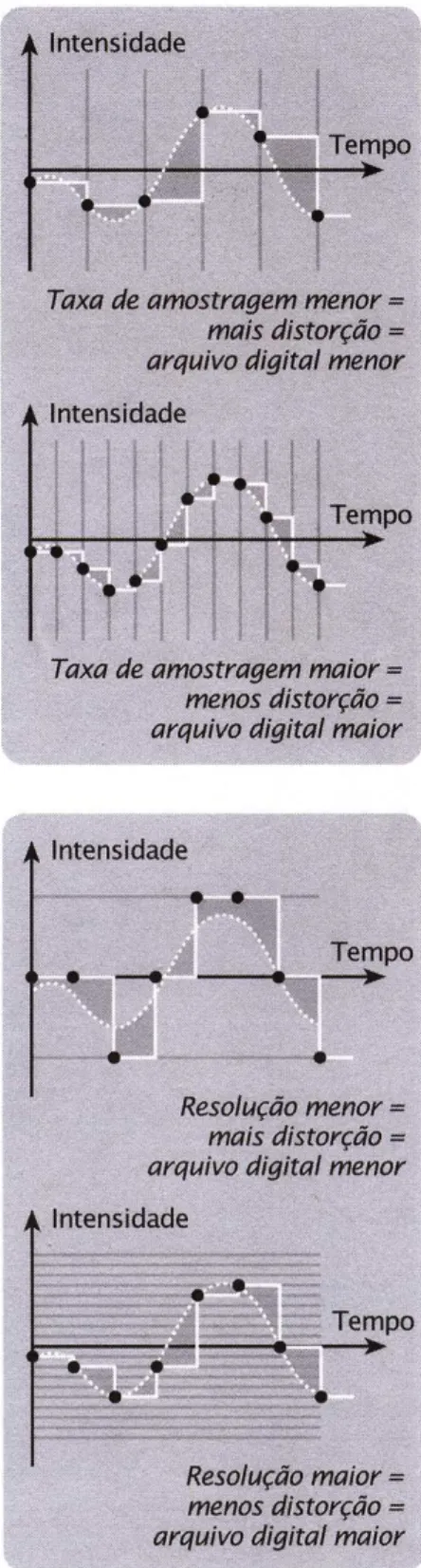

Fig.5 - sample rate e bit rate: amostragem e quantificação ... 28

Fig.6 - Moviola. ... 36

Fig.7 - mesa de edição Steenbeck ... 39

Fig.8 - King Tubby em seu “laboratório de som” ... 62

Fig.9 - screenshot de edição com videomixer... 70

Fig.10 - Screenshot de KungFu mixer... 71

Fig.11 - screenshot do videomixer Circ_lular... 72

Fig.12 - screenshots de Pianografique... 74

Fig.13 - screenshots do piano gráfico compulsion... 76

Fig.14 - screenshot do módulo de montagem Continuum... 76

Fig.15 - Ícone do FC... 87

Fig.16 - Ícone do KW... 88

Fig.17 - Splash screen do FC... 90

Fig.18 - Splash screen do KW... 91

Fig.19 - print screen interface FC... 94

Fig.20 - print screen da interface do Patcher... 97

Fig.21 - os módulos... 99

Fig.22 - estados e tipos de módulos... 99

Fig.23 - campos do patcher... 100 Fig.24 - módulos de entrada... 101

Fig.25 - módulos modificadores... 102

Fig.26- módulos de saída... 102

Fig.27 elementos da interface do Realizer... 103

Fig.28 frame de vídeo gerado pelo Realizer na Performance Transmigração na Galeria. Vermelho... 105

Introdução

O trabalho que aqui se encontra versa sobre a edição de vídeo, de como os modos de

fazer vídeo estão sendo ampliados pelas novas tecnologias, permitindo novas formas de

produção significante. É curioso notar que, ao mesmo tempo em que o vídeo está mais do

que nunca acessível à produção individual, graças à tecnologia, surgem cada vez mais

movimentos e propostas de trabalhos colaborativos, nos quais o conceito de autoria é

questionado tanto no fazer conjunto quanto no uso de material “reciclável”. Nesse

sentido, um substrato cultural, aquilo que é considerado banal, cotidiano e descartável, é

transformado em matéria-prima para a criação artística.

Para a realização desses trabalhos coletivos em rede, apresentamos um software

concebido com esse objetivo, o KeyWorx (anteriormente chamado Keystroke).

Diferentemente dos programas tradicionais de edição de vídeo no computador,

categorizados como desktop video, que pressupõem o uso individual, o KeyWorx propõe

uma forma de criação coletiva. Programas do tipo desktop video, como o Final Cut Pro,

tiveram sua concepção original (dada pelo fabricante/indústria do software) subvertida em

apresentações ao vivo e coletivas, nas quais desponta a figura do VJ (vídeo-jóquei).

Neste contexto, analisamos como a figura do editor de vídeo solitário na frente do

computador foi se alterando frente às inovações surgidas na Internet e do desenvolvimento

de software e hardware, potencializando a transfiguração do editor de vídeo em VJ. Para

tal, investigamos a natureza da mídia, o vídeo digital e seus meios de difusão e criação:

software, interfaces e a Web, a origem de base numérica binária, o telefax, a edição no

cinema em vídeo analógico e digital.

Primeiramente, fazemos uma contextualização do objeto de pesquisa: o KeyWorx,

software que possibilita a manipulação de mídias digitais em tempo real com vários

usuários (interatores) conectados, seja em redes locais (intranets), seja na rede mundial de

computadores, a Internet. A contextualização se inicia buscando as origens e as

“novas mídias”. E em que medida as evoluções tecnológicas engendram mudanças no

universo da arte. Para tanto, são trabalhados conceitos de Edmond Couchot, Arlindo

Machado, Jay David Bolter, Richard Grusin e Giselle Beiguelman, além do já citado Lev

Manovich.

Em seguida, buscamos os antecedentes tecnológicos do vídeo digital na Internet,

caracterizado pelo fato de ele ser escrito em linguagem binária, compreendendo quais

foram suas primeiras utilizações na formação de imagens. Depois, enunciamos as

primeiras formas de transmissão eletroeletrônicas de imagens, e em que medida ela

determina a constituição dessa imagem, suas características: uma imagem feita de

pequenos pedaços, de pontos, reticular, tal qual um mosaico. Assinalamos as diferenças

entre a imagem eletrônica (vídeo e TV) e a imagem digital, que reside no fato de a imagem

digital constituir-se de um código numérico e, portanto, ser manipulável matematicamente,

isto é, a mídia torna-se programável.

Ao adentrar o terreno da programabilidade, explicamos como o computador cria

mídias, as chamadas imagens sintéticas. Elas são assim chamadas, pois não são obtidas a

partir da captura de objetos ou criaturas, ou seja, não são necessariamente uma

representação da realidade, podendo dispensar a característica referencial encontrada na

fotografia, no cinema, na TV e, em menor grau, no vídeo. A imagem sintética pode ser uma

distorção dessa imagem referente, ou pode ser uma imagem completamente inédita, não

mimética, abstrata, assim como as pinturas das vanguardas do começo do século XX (em

especial o Suprematismo), criando uma apresentação significante em vez de uma

representação da natureza.

Depois de explicado como se geram imagens através do computador, analisamos

como se convertem imagens de outras mídias para a linguagem binária, o processo

conhecido por digitalização. Embora a digitalização ocorra hoje de maneira corriqueira nas

mais diversas atividades humanas (escaneamento de imagens, captura de áudio e vídeo,

reconhecimento de caracteres OCR para textos), ela não é necessariamente compreendida.

(quantify), e o significado desses termos. Diferenciamos também os tipos de imagem

digitais: bitmaps e gráficos vetoriais. Por fim, elucidamos as implicações de se trabalhar

com uma mídia programável.

À medida que se numerizam, as técnicas interpõem, efetivamente, entre a ferramenta e a matéria bruta, alguma coisa que não existe na relação tradicional: a tela de linguagem. A ferramenta numérica é lingüística e por isso coloca em jogo, por este fato, sistematicamente na sua programação, os modelos provindos da ciência.1

Couchot refere-se aqui à interface gráfica do usuário (GUI – Graphical User

Interface). Paradigma da produção artística atual via computadores, a interface será

matéria de reflexão nos capítulos 2 e 3.

Na última parte do capítulo 1, tratamos da edição de vídeo propriamente dita. No

princípio ela era feita de modo linear, implicando grandes gastos de tempo e dinheiro,

devido à forma trabalhosa e dispendiosa que caracterizava esse processo. A edição

não-linear em vídeo só foi possível com o uso do computador. No entanto, o processo de

edição não-linear foi concebido no cinema, por isso as interfaces gráficas dos programas de

edição no computador (que ficaram conhecidos pelo termo desktop video) usaram como

metáfora o instrumental do cinema: a película (metaforizada na timeline), a moviola, a

lâmina de barbear (que servia para cortar a película) e assim por diante. Por fim, tomamos

algumas considerações de um editor consagrado, Walter Murch, que trabalhou com os três

sistemas de edição.

No capítulo 2, demarcamos a diferença entre o vídeo digital e o vídeo digital na rede.

A Internet, mais que apenas um dos suportes para vídeo digital (os outros seriam

CD-ROMs, DVDs, fitas em formato mini-DV, etc), pode vir a determinar suas características

intrínsecas. No entanto, há que se diferenciar os vídeos que foram disponibilizados na

Internet – embora tenham sido concebidos para outros formatos – daqueles pensados

exclusivamente para a Internet. Estes consideram as limitações da rede (velocidade de

conexão, processamento dos computadores, além de variáveis em torno de sistemas

operacionais, tipos de monitor, etc) como determinantes para a formação de uma

linguagem própria para o vídeo na internet. Outros buscam utilizar os novos recursos

oferecidos pela Internet em seu protocolo mais popular, o HTTP da Word Wide Web.

Alguns desses trabalhos procuram fazer o uso do hyperlink para criar narrativas

“navegáveis” e não-lineares, enquanto outros usam a Internet como um espaço virtual de

encontros e criações coletivas.

Para tal, fazemos uma breve conceituação da Internet, dos vetores econômicos,

sociais e tecnológicos que estão em jogo e que se inter-relacionam, assim como dos

formatos de vídeo digital disponíveis para criação e fruição de vídeos na rede. Buscamos

traçar um pequeno histórico dos anos iniciais do vídeo na Internet, através de um artigo de

Nora Barry que paradoxalmente se intitula “Telling stories on screens: a history of web

cinema” (Contando histórias na tela: uma história do cinema na web), do livro Future

cinema. Questionamos os critérios (ou a falta de) de denominações de objetos e

procedimentos culturais na Web. Isto não surpreende quando encaramos a realidade da

Web, onde as categorias são fluidas e as inovações tecnológicas estão sempre alterando o

estatuto (incipiente) das coisas.

Parece que na Web se sofre uma certa síndrome de Humpty Dumpty:

Quando eu uso uma palavra, disse Humpty Dumpty em tom meio debochado, ela significa apenas aquilo que eu quis que significasse, nem mais nem menos. A questão, disse Alice, é saber se você consegue fazer as palavras significarem tantas coisas diferentes. A questão, disse Humpty Dumpty, é o que significa ser aquele que manda, e isso é tudo.2

Seguimos fazendo a diferenciação entre os vídeos disponibilizados na Internet dos

vídeos feitos para a Internet, tecendo considerações a respeito da especificidade do vídeo

digital, como, por exemplo, a questão de seu peso. O vídeo digitalizado tende a criar

arquivos com grande carga informacional, ou seja, com muitos bytes, geralmente da ordem

2 CARROL, Lewis. “Através do espelho e o que Alice encontrou lá”. 1977, p. 196. No conto

de milhões (megabytes), mas podendo facilmente chegar a bilhões (gigabytes). Isso exige

grande capacidade de armazenamento, velocidade de fluxo e processamento de dados, daí a

metáfora do peso ser tão adequada.

Apresentamos então as duas formas primordiais de recepção de vídeo na Internet: o

download e o streaming. O download foi a forma inicial de veiculação de vídeo na Internet

e persiste até hoje de diversas maneiras. Consiste em descarregar o conteúdo completo

do arquivo de vídeo digital no disco rígido (HD) do computador do usuário para que este,

então, possa assisti-lo. O streaming foi uma tecnologia desenvolvida justamente para

driblar o problema do peso dos arquivos de vídeo em sua veiculação na Internet. Aqui o

arquivo é dividido em pequenos pacotes que são transmitidos para, mas não armazenados

no HD do computador receptor. À medida que o pacote chega, ele é visualizado e em

seguida descartado, não ocupando espaço no HD nem na memória da unidade de

processamento (CPU). Fazemos uma análise minuciosa dos aspectos de diversos modelos

de streaming, tecnologias envolvidas, protocolos utilizados, as diversas formas de

multi-recepção (webcasting), como também as implicações sociais e culturais dessas opções

tecnológicas. Por exemplo, a impossibilidade de manipular seu conteúdo, sendo uma

garantia de proteção de propriedade intelectual (copyright).

Chegamos então ao núcleo duro da problematização do vídeo digital na rede quando

se trata da questão dos CODECs. O termo CODEC é a contração de

compression/decompression. Sua função é comprimir as informações do vídeo digital para

armazenamento e transporte e descomprimi-las para sua visualização. Mesmo no sinal de

vídeo analógico existe um tipo de compressão. No vídeo digital, onde há maior quantidade

de informação, quer nas gravações ou transmissões, o processo de compressão torna-se

quase inevitável. Na transmissão é obrigatório. Foi graças aos CODECs que a Internet

pôde se tornar multimídia, pois praticamente todos os arquivos de áudio e vídeo utilizam

algum tipo de CODEC. Na Web, a baixa resolução é a regra e não a exceção.

Partimos então para ver como isso ocorre na prática, analisando casos específicos

webvideomixers desenvolvidos na tecnologia Flash, os sites que manifestam a cultura

remix e os viral videos. Selecionamos casos que evidenciam procedimentos que já existiam

antes da popularização da Internet e da cultura digital, mas foram por elas elevados à

enésima potência. Falamos aqui do cenário contemporâneo, onde é comum a prática do

remix, do sampleamento, da reciclagem, configurando uma cultura open-source em que as

antigas noções de autor estão sendo revistas.

É significativo notar que, ao mesmo tempo em que a tecnologia possibilita, cada

vez mais, concentrar diversas atividades humanas nas mãos (e, sobretudo, na cabeça) de

uma só pessoa, diversos coletivos de artistas se unam para criar trabalhos, performances,

eventos ou “projetos”. É o que Manovich qualifica como autoria colaborativa.3

E, como

previu Timothy Leary, com a Internet o computador pessoal (PC) tornou-se

interpessoal.4

Hoje em dia, podemos ter no bolso câmeras, gravadores e até computadores

pessoais (palmtops), que há pouco mais de 50 anos ocupavam salas inteiras.

Concomitantemente à miniaturização desses dispositivos, desenvolveram-se as

possibilidades de interconexões entre máquinas e pessoas, entre máquinas e outras

máquinas e, portanto, entre pessoas e pessoas através de máquinas. Mas é importante

notar que as novas formas de associação e de criação colaborativa não se dão por causa

dos avanços tecnológicos. A evolução dos dispositivos tecnológicos midiáticos permite o

surgimento dessas novas formas de criação e recepção, mas não garante sua efetivação.

Para tal, é necessária a emergência de uma nova mentalidade, uma nova visão de mundo – o

que já vem ocorrendo há algum tempo. Trata-se aqui de uma complexidade emergente

adaptativa.

Nesse ponto, a pesquisa entra na análise do software multimídia e multiusuário

KeyWorx, que permite um sistema de criação emergente, sem um centro único

3 MANOVICH, Lev. “Quem é o autor: sampleamento, remixagem e código aberto”. 2004,

p.250.

4 LEARY, Timothy. “The interpersonal, interactive, interdimensional interface”. 2001,

controlador, mas em uma malha de ações e relações, na qual não interessa o produto final,

1. Vídeo Digital

O artista é antes de tudo um matemático, um técnico, um investigador da natureza.

Leon Battista Alberti

1.1. Tecnocultura

As técnicas não são alheias à cultura. Etimologicamente, a palavra técnica vem do

grego tékhné,que quer dizer “arte, artesanato, indústria, ciência”. No entanto, hoje em dia,

quando a tecnologia digital se difundiu por todos os campos de atuação humana, é comum

a crítica de que a arte feita em computador eliminou o caráter subjetivo da criação, caráter

este indispensável à criação artística.

Esta crítica aparece no verso provocativo da música Computadores fazem arte:

“Computadores fazem arte, artistas fazem dinheiro/ Artistas fazem dinheiro/

Computadores avançam/ Artistas pegam carona/ Cientistas criam o novo/ Artistas levam a

fama”. Composta por Fred Zero Quatro, da banda Mundo Livre S.A., registrada no disco

de estréia Da lama ao caos (1994), de Chico Science e Nação Zumbi, a letra da música já

anunciava o que estava por vir. O número de artistas fazendo música e arte com

computador, toca-disco, sintetizador, sampler e afins é crescente, marcando o cenário

cultural brasileiro neste início de século.

Significativamente, Chico Science e sua banda Nação Zumbi usaram e abusaram da

tecnologia digital, criando uma fusão muito frutífera desta com instrumentos de origem

mais arcaica (tambores, agogôs e cavaquinhos). Esse uso criativo da tecnologia ficou

evidente em suas músicas, que deram origem a um movimento musical justamente

chamado Mangue Bit (“bit”, a unidade mínima de informação usada pelos computadores,

correspondendo a 0 ou 1 na linguagem binária). O nome foi depois alterado pela imprensa

No decorrer da história, os artistas sempre fizeram uso da tecnologia. Atualmente,

na criação artística, o uso da tecnologia não significa a eliminação da subjetividade, inerente

à arte, mas sim aponta para novas modalidades de subjetividade. Edmond Couchot

lembra-nos que desde a pré-história até a atual cultura digital, os processos figurativos

desenvolvidos pelo homem são dependentes de automatismos maquínicos. A relação que

se dá nas artes visuais entre automatismo técnico e subjetividade se consolida na idéia de

que o sujeito teria dois elementos básicos: o sujeito-NÓS, modelado pela experiência

tecnestésica, em que o “sujeito controla e manipula técnicas através das quais vive uma

experiência íntima que transforma a percepção que tem do mundo”; e o sujeito-EU, que

seria a manifestação de uma subjetividade irredutível a todos os mecanismos técnicos, uma

singularidade, com uma história e um imaginário individuais. Para Couchot, o “uso das

técnicas conforma cada um segundo um modelo perceptivo partilhado por todos – um

habitus comum sobre o qual se elabora uma cultura e da qual a arte se alimenta”.5

A crítica à invasão dos dispositivos técnicos a um universo antes dominado pela arte

tem sua origem no romantismo, quando é exacerbada a idéia de subjetividade: a noção de

autor. É famosa a crítica que o poeta Charles Baudelaire fez da fotografia, considerando-a

uma imagem trivial que mostra a natureza “exatamente” como ela é. O que incomodava o

poeta é que a atividade de figuração do real, antes ocupada pelos pintores, seria

automatizada por uma máquina “sem inteligência nem arte”.6

A fotografia é um

desenvolvimento de toda uma série de saberes e aparelhos engendrados por esses saberes,

que tem sua origem no Renascimento, onde, não por acaso, também se originou a noção de

autor com Da Vinci, Michelangelo e Rafael.

De acordo com Couchot:

Não há ruptura essencial na relação do sujeito, da imagem e do objeto (esta fração do mundo ou do real a representar) entre o sistema figurativo teorizado por Alberti e a fotografia. Há um prolongamento e reforço, um reforço que aproveita toda a potência dos procedimentos de automatização da imagem – de sua produção e de sua reprodução

5 COUCHOT, Edmond. A tecnologia na arte: da fotografia à realidade virtual. 2003,

pp.15-17.

– desenvolvidas entre o fim do século XVIII e a primeira metade do século XIX e já em semente desde as invenções do Quattrocento.7

A tecnologia é fruto do pensamento científico e também faz parte do campo da

cultura. Percebemos aí uma série de vetores se inter-relacionando, e não categorias

estanques de pensamento como “tecnologia”, “arte” e “cultura”. Essa prática de dividir o

pensamento humano em diversas categorias surge a partir do Renascimento, e se acerba no

Iluminismo com o pensamento enciclopedista. Paradoxalmente, no Renascimento, período

da história caracterizado pelo pensamento humanista, pretendia-se abarcar e integrar todo

o conhecimento humano, não fazendo separação entre arte e ciência. O melhor exemplo

disso está na figura emblemática de Leonardo da Vinci, mistura de pintor, engenheiro,

anatomista, etc. No entanto, na Renascença, surge a idéia de autor (assinatura), as

corporações de artífices tornam-se cada vez mais específicas e começa a se desenvolver o

método científico. Inicia-se a divisão social do trabalho, que terá seu ápice séculos mais

tarde, na produção da linha de montagem criada por Ford no século XIX, em que o

trabalhador fazia uma tarefa única e específica, não tendo uma noção do conjunto.

Tecnologia = ciência + técnica. Portanto, não podemos colocar a tecnologia fora do

âmbito da cultura. Ainda mais se estivermos nos referindo à tecnologia das comunicações,

que alguns autores como Manuel Castells acreditam “moldar a cultura”. O autor sugere

que os avanços tecnológicos determinam profundamente as formas de comunicação,

alterando sobremaneira a cultura, como nunca antes, pelas atuais tecnologias digitais.8

Tais

constatações podem parecer óbvias, mas, não muito tempo atrás, tinha-se a idéia de que a

cultura e a tecnologia pertencessem a universos diferentes e até mesmo conflitantes.

A idéia clássica de arte, que muito se perpetua até a atualidade, foi concebida no

Renascimento, quando esta se categorizou em cinco grupos: desenho, pintura, gravura,

escultura e arquitetura.9

Nesse período, a arte tornou-se portátil e perdeu sua dependência

religiosa, migrando dos murais das igrejas para as telas. As mudanças das técnicas do

7 COUCHOT, Edmond. Op. cit., p.26.

8 CASTELLS, Manuel. A sociedade em rede. 2005, p.414.

afresco para a têmpera, e depois para a pintura a óleo, afetaram seu modo de produção,

desde o pré-planejamento até o tempo de execução e as pessoas envolvidas no processo.

A partir daí, o que antes era feito por uma equipe pôde ser executado somente por uma

pessoa. Além disso, a possibilidade de retoque dada pela tinta a óleo criou uma liberdade

sem precedentes no universo da pintura.

Esse exemplo demonstra que a arte sempre foi produzida através de técnicas, de

modo que cada período histórico tem seus próprios meios de produção artística. Até a

Revolução Industrial no século XIX, essas técnicas, apesar de já contarem com o uso de

diversos aparelhos auxiliares, foram em sua totalidade artesanais, ou seja, dependeram da

habilidade manual do artista para sua concretização em formas bi ou tridimensionais. Com

a Era Industrial, os trabalhos manuais antes feitos pelo homem foram ampliados e, por

vezes, substituídos pelas máquinas. Essas transformações também ocorrerão, mesmo que

de forma paulatina, polêmica e resistente, no universo da arte, ao ser introduzida a

primeira máquina capaz de fixar imagens sem a intervenção da mão humana: a câmera

fotográfica.

O contexto social de industrialização, a partir da invenção de uma nova técnica

figurativa, de algum modo proporcionou as condições necessárias para a transformação da

idéia de arte e o surgimento de novas modalidades e proposições artísticas. Com a

invenção da fotografia, a pintura foi aos poucos deixando de ocupar o papel de reprodução

mimética do mundo externo, buscando então algo que lhe seria próprio, sua “essência”,

mudando assim seus referenciais conceituais e estéticos. A arte, de alguma maneira,

responde à fabricação técnica pela criação estética, à trivialidade pela singularidade, na

eterna busca pelo novo, pelo original. Uma busca sem fim, visto que o novo hoje será o

antigo no futuro, assim como o original se tornará trivial.

cultural – a imagem fixa. Em contraste, a revolução da computação midiática afeta todos os estágios da comunicação: aquisição, manipulação, armazenamento e distribuição; e também afeta todos os tipos de mídia – textos, imagens fixas, imagens em movimento, som e construções espaciais.10

Na contemporaneidade, muitos artistas vêm-se apropriando dos novos meios

digitais para a criação artística, trabalhando especialmente com imagens numéricas.

Analisaremos aqui uma mídia atual, o vídeo digital, mais precisamente o vídeo na Internet,

observando características inerentes à sua “matéria” – arquivo digital composto de

números binários, os quais são passíveis de processamento pelo computador – e suas

“ferramentas” – programas de computador, software necessário à criação, distribuição,

exposição e conservação (armazenamento) desta mídia. Nosso intuito não é repudiar ou

aceitar a atual condição tecnológica humana, até porque ela já está implantada, mas

entender de que maneira nos relacionamos com ela no âmbito da criação artística, e em que

medida essa tecnologia possibilita novas propostas na arte da imagem.

Para tal, vale perpassar, de maneira breve, as origens históricas da imagem

videográfica – reticular, mosaicada e fragmentada – e entender como ela se articula mais

especificamente com a mídia digital.

1.2 Antecedentes

O vídeo digital pertence ao grupo das novas mídias ou mídias digitais, que têm em

comum o fato de sua base, sua “matéria-prima”, ser constituída de números de “base 2”,

ou seja, números binários (0 e 1). Isto corresponde ao estado ligado e desligado dos

microcircuitos do computador. Este fato faz toda a diferença, se comparado com as mídias

analógicas. A partir das tecnologias de mídia eletroeletrônicas, do telégrafo até o vídeo, o

meio deixa de ser material (papel, madeira, pedra, ferro, etc) para tornar-se uma corrente

elétrica. Com o digital essa imaterialidade adquire outras especificidades, de maneira que as

novas mídias retêm as características das mídias anteriores (imagens, sons e textos), mas

são constituídas de dados numéricos (binários) passíveis de manipulação e mediação

através do computador.

Instrumentos que trabalham com o

binário foram inventados pelo homem

muito antes de ele dominar a eletricidade

e a eletrônica. O mais antigo é sem dúvida

o ábaco, a primeira calculadora binária de

que se tem notícia, existente desde o

século VIII a.C., na China.11

Já o primeiro dispositivo gráfico

binário foi o famoso tear de J. M .

Jacquard. Por volta de 1800, Jacquard criou um tear que era programado por cartões

perfurados. Lev Manovich considerou esse invento o primeiro computador gráfico,

gerando “imagens complexas, incluindo um retrato de seu inventor”.12

De fato, a idéia de

transmitir dados e instruções para uma máquina através de cartões perfurados foi adotada

por Charles Babbage em 1833, quando ele elaborava um dispositivo denominado máquina

analítica. Esse novo invento teria duas características básicas dos computadores atuais: a

capacidade de armazenar informação e a execução de programas, tecendo padrões

algébricos, assim como o tear de Jacquard tecia flores e folhas. No entanto, a máquina

analítica de Babbage não passou de um projeto, pois seu inventor morreu sem conseguir

tirá-la do papel. Mas seus cartões perfurados, que registravam a informação de forma

binária – 0 e 1, sim ou não, buraco vazado ou fechado –, foram largamente usados nos

computadores, pelo menos até meados da década de 1960.

11 Cf. http://piano.dsi.uminho.pt/museuv/ac_abaco.html. 12 MANOVICH. Op. Cit., p. 22.

A ação de traduzir uma imagem para o formato digital se realiza por um processo de

divisão conhecido por digitalização ou discretização. A origem desse processo é antiga,

decorrente da necessidade de se enviar imagens (fixas) por transmissão elétrica. Os

primeiros inventos surgiram a partir da tecnologia do telégrafo. No século XIX, a primeira

transmissão de uma imagem por meio de impulsos elétricos adveio de um equipamento

criado por Alexander Bain. Patenteado em 1843, esse aparelho foi o precursor da máquina

de fax ou fac-símile. Alexander Bain era um apaixonado fabricante de relógios e adaptou os

mecanismos do relógio elétrico à tecnologia do telégrafo. Sua invenção consistia em dois

pêndulos sincronizados. Enquanto o primeiro oscilava e percorria uma superfície de metal

com relevo, semelhante às chapas de impressão da época, o segundo fazia o mesmo

movimento sobre um papel embebido em iodeto de potássio, que sofre alteração da cor

pela passagem de corrente elétrica. Sua

primeira apresentação pública ocorreu em

1851, transmitindo manuscritos e

desenhos. Esse foi o começo não só da

comunicação por escrito através de

códigos binários, via correntes elétricas,

mas também da possibilidade maquínica

de receber imagens a longa distância.13

Esse foi talvez o prenúncio da revolução

ocasionada pela união da telecomunicação

com a computação.

F. C. Bakewell, em 1847, aperfeiçoou o invento de Bain utilizando cilindros,

semelhantes aos dos aparelhos de fac-símile atuais, em vez de pêndulos. Com isso obteve

13 Cf. http://www.mediatecaonline.net/videonline e

http://chem.ch.huji.ac.il/~eugeniik/history/bain.html.

uma melhora na qualidade de imagem. O abade Giovanni Caselli (1815-1891), em 1862,

aprimorou as idéias dos telégrafos eletroquímicos de Bain e Bakewell, criando o

pantelégrafo. Este possuía um sincronizador, conseguindo enviar textos e desenhos via

cabo, de Amiens a Paris. Essas invenções consistem em um marco para o entendimento da

transmissão de imagem, pois naquele momento a questão se colocava da seguinte forma:

Se uma imagem for transmitida por cabo via uma série de impulsos elétricos, ela deverá, em primeiro lugar, ser dividida em pequenas partes. Cada impulso transmite uma parte. No ponto de recepção, as partes deverão ser reproduzidas individualmente, e depois reagrupadas para duplicarem a imagem original. O processo é chamado de scanning. Mas como isso poderia ser feito?14

Em 1885, na França, Maurice Leblanc propôs que cada parte da imagem fosse

separada e exposta em uma sucessão rápida e numa seqüência exata, dando a ilusão de uma

imagem inteira, que pode ser criada no ponto receptor. Esse processo, denominado

scanning, é justamente o processo de discretização da imagem (a quebra de uma

informação contínua em pequenas partes). É o que ocorre na digitalização da imagem por

computador, usando um aparelho que se chama justamente scanner, ou escaneador. A

discretização ocorre em diversas mídias. No fax, em amostras de espaço 2D. No cinema,

na combinação de código contínuo e

discreto, cada quadro (frame) é uma

fotografia – uma informação

contínua, mas o tempo é partido em

certo número de amostras. Na TV e

no vídeo, além da discretização

ocorrer no tempo, como no cinema,

o próprio quadro é discretizado

verticalmente em linhas de varredura

(scan lines) no espaço.

14 SETTEL, apud ROSA, Almir Antônio. Videohaiku. 2000, p.110

Uma imagem digital fixa é uma matriz de pixels, uma amostra bidimensional do

espaço. No vídeo digital há uma série dessas matrizes (frames) que se sucedem durante o

tempo. A imagem digital é composta por uma série de pontos dispostos horizontal e

verticalmente – os pixels (o termo é uma abreviação de picture elements). Ora, até aí não

há novidade: a imagem de vídeo também é formada por uma série de pontos, assim como a

imagem impressa em off-set, usando o sistema halftone, produz uma imagem reticular

formada por pontos. No entanto, esses pontos variam de tamanho, de forma contínua. De

maneira análoga, o sinal eletromagnético da transmissão televisual é uma onda (hertziana)

contínua que gera uma imagem reticular, mosaicada. O termo imagem mosaicada foi

cunhado por Marshall McLuhan em relação à especificidade da imagem do monitor de TV.

Arlindo Machado comenta:

Se formos buscar na pintura um paralelo com a técnica constitutiva da imagem eletrônica, certamente não será na pintura figurativa renascentista que iremos encontrar. Marshall McLuhan fala de imagem mosaicada a propósito do vídeo, referindo-se, como bem observa Décio Pignatari, aos mosaicos das igrejas bizantinas, em que as pedrinhas de cristal colorido com que se forja a imagem nunca estão n o mesmo plano, o que faz variar a incidência da luz. Esta textura particular parece conferir tatilidade à imagem, como se o olho fosse capaz de “apalpar” a sua granulosidade e sentir a sua constituição (Pignatari, 1984:16). Mas é na obra de um dos inauguradores da paisagem plástica contemporânea que vamos observar o nascimento, por assim dizer, do processo televisual: estamos nos referindo a Georges Seurat. Substituindo as pinceladas tradicionais por pequenos retângulos ou pontos coloridos, Seurat deu o golpe de misericórdia na imagem figurativa, dissolvendo-a numa rede de retículas granulosas, como na trama multipontuada de uma tapeçaria.15

A percepção de formas e figuras nessas imagens pontilhadas (reticulares) se dá por

um esforço do espectador. Cabe a ele a “operação final de combinação e

reconhecimento”.16

O “escândalo” causado pelas primeiras exposições dos impressionistas

foi justamente causado pela incompreensão desse esforço. Para ver as figuras de um

quadro impressionista e não somente as pinceladas que o constituem, o espectador deveria

se distanciar do quadro a ponto de essas pinceladas se mesclarem e as figuras se tornarem

reconhecíveis em sua mente.

O grande diferencial das

mídias digitais para suas

antecessoras, segundo Manovich,

é que enquanto estas contêm

níveis de representação discreta

(discretização) a amostragem

nunca é quantificada. Ou seja, o

valor da amostra não é medido; isso só ocorrerá na mídia digital. Vamos entender a seguir

como ocorre a discretização e quantificação da mídia analógica pelo computador, ou seja,

como se sucede a digitalização.

A digitalização converte qualquer tipo de mídia em dados computacionais. É o que

Manovich chama de princípio de transcodificação.17

Este princípio das mídias digitais

deriva de outros quatro: representação numérica (todos os objetos das novas mídias são

compostos de um código digital binário), organização modular, automação e variabilidade.

A conseqüência do princípio de transcodificação é que as mídias digitais adotam um

aspecto essencial da programação informática: a separação entre um algoritmo e uma

estrutura de dados. Assim, temos de um lado os programas de computador, os softwares,

que são constituídos de uma série de algoritmos; e do outro as mídias digitais: arquivos

formados por um conjunto de dados numéricos. A mídia digital é sujeita a manipulação

algorítmica. Através das ferramentas (algoritmos) de um programa de edição de vídeo

podemos, por exemplo, aumentar o contraste da imagem de um trecho de vídeo, mudar sua

proporção, “desfocá-la” (blur). Resumindo, a mídia torna-se programável.18

17 MANOVICH, Lev. Op. Cit., p. 45. 18 Id., Ib., p. 27.

1.3. O computador como gerador e conversor de mídias

Uma imagem sintética é aquela que se constitui sem o uso da câmera, sem um

referente ou sem um índice do real. Uma das primeiras imagens sintéticas não-figurativas

foi concebida por Nam June Paik no trabalho Distorted TV Sets (apresentado na Galeria

Parnass de Wuppertal, Alemanha, em 1963). Arlindo Machado aponta que elas eram

imagens “sintetizadas através do puro tratamento eletrônico do fluxo de partículas no

iconoscópio” de um aparelho televisor, compostas através do uso de ímãs que alteravam a

trajetória do feixe de elétrons no tubo de varredura, modificando assim a imagem. Esse foi

um dos primeiros sintetizadores, capaz de distorcer tanto uma figura renascentista,

construída pelo olho de uma câmera, como também gerar imagens inéditas, sem

necessidade de recorrer ao trabalho de enunciação da velha câmera obscura. Machado

analisa que uma das contribuições de Paik à videoarte foi a recusa a cumprir com a

finalidade figurativa da imagem técnica, conseqüentemente atacando a ideologia do

mimetismo à qual ela está associada. O sintetizador dispensa o referente, essa entidade

fundadora da figuração, e nesse sentido ele se desvia de uma vez por todas da linha de

evolução dos sistemas figurativos.19

Como assinalamos anteriormente o vídeo digital pertence ao grupo das novas mídias,

que tem em comum com outras mídias digitais o fato de sua “matéria prima” ser

constituída de números de “base 2”, ou seja, números binários (0 e 1). Diferenciando-o das

mídias analógicas, pois são passíveis de manipulação algorítmica.

A mídia videográfica encontra-se hoje na fronteira entre o seu sentido expandido na cultura digital e a sua natureza de meio em que convergem diferentes modos de representação. Ela pode ser traduzida como um contexto criativo em que tendem manifestações de ordem contemplativa, participativa e interativa; uma linguagem interdisciplinar capaz de coexistir nos mais diversos ambientes sensórios, que inscreve pela primeira vez o tempo no espaço, opera em tempo real e associa imagens e sons por se tratar de uma escritura audiovisual, em movimento; um meio dinâmico, vivo, que promove diálogos multifacetados no campo geral das práticas significantes.20

19 MACHADO, Arlindo. Op. Cit., p. 119-122.

A mídia digital pode ser gerada por meio de um

computador – gráficos vetoriais 2D e 3D (imagens), sons

compostos por programas sintetizadores (áudio) –, ou

pode advir de uma mídia analógica e ser convertida para

digital, através de dispositivos e programas de captura

computacionais. Assim, toda mídia analógica (filmes,

vídeos, sons, textos, etc) pode ser traduzida para digital. O

computador, além de criar mídias através de processos

digitais, pode também “ler” as antigas mídias analógicas e

“transformá-las” em digitais. Isto é feito através da

conversão ou digitalização das mídias analógicas.

As mídias analógicas possuem um sinal contínuo, ou

seja, o “eixo ou dimensão medido não tem uma unidade

indivisível aparente da qual ele é composto”.21

Converter

dados contínuos em representação numérica é chamado de

digitalização ou discretização do sinal, como veremos a

seguir. O processo de digitalização envolve dois

procedimentos: amostragem (sampling) e quantificação

(quantify).

A amostragem consiste na decomposição dos sinais

analógicos em amostras colhidas em intervalos regulares; e a

quantização é o processo de atribuir valores a essas

amostras. Discretizar ou numerizar um sinal analógico é um

verdadeiro fatiamento desse sinal. Foi o que fez Alexander

Bain em 1843, a partir da tecnologia do telégrafo, como

mencionamos no início do capítulo. Aí já estava o princípio

do processo de scanning. O que se constatou é que para

21 MANOVICH, Lev. Op. cit., p. 28.

poder transmitir um conteúdo, no caso uma imagem, por meio de sinais elétricos, era

preciso antes dividir esse conteúdo em pequenas partes que corresponderiam a níveis de

intensidade do sinal elétrico (voltagem) análogos à tonalidade da imagem (luz e sombra).

Essa imagem reticular em termos informáticos é conhecida como imagem bitmap

(mapa de bits) e pertence ao grupo dos raster graphics. O bitmap é um arquivo de dados

ou estrutura representada geralmente por uma grade retangular de pixels (matriz), ou

pontos de cor em um monitor de computador, papel ou outro meio de exibição visual. Se

no caso da onda sonora a amostragem (sample) ocorre no tempo, na imagem bitmap a

amostragem se dá no espaço bidimensional. Sendo o sample rate a taxa de amostragem de

uma imagem espacial, quanto menor o intervalo entre as amostras maior será o número de

pixels de que ela é formada e, portanto, terá uma distorção menor em relação à fonte

analógica. Por conseguinte, gerará um arquivo digital maior.

É importante considerar que em termos de informação (fluxo de dados) – e não em

termos de percepção humana –, a conversão para o digital sempre implica em alguma

perda de informação. Se a discretização tiver uma resolução muito alta, ou seja, se a

freqüência de amostragem (sample rate) for de intervalos muito pequenos

(microssegundos no caso de uma onda de áudio ou vídeo, nanômetros no caso de uma

imagem fixa), e se a taxa de quantificação (bit rate)22

tiver uma escala alta, a onda

reconstituída (digital) será mais similar à onda original (analógica), portanto sem diferença

perceptível ao olho humano. Ela terá maior fidelidade a sua fonte analógica, e assim

haverá menor introdução de ruídos e distorções digitais, os chamados “artefatos”, pois são

gerados artificialmente.

Quando uma imagem é criada a partir do computador, é originada de uma forma

numérica, de um algoritmo – uma ou uma série de instruções matemáticas. Isso pode

ocorrer em gráficos vetoriais 3D ou 2D, em que fórmulas matemáticas instruem como o

computador deve “desenhar” esses objetos virtuais, suas linhas, curvas, superfícies, etc.

22 No caso da imagem, os valores do pixel correspondem a sua tonalidade, grau de saturação

Esta inserção de dados (input) descreve ou modela os parâmetros que constituirão a

imagem digital. Esse modelo poder ser alterado e manipulado a qualquer momento da

configuração ou criação da imagem, assim como o ângulo e a proximidade do ponto de

vista são determinados pelos parâmetros dados a uma câmera virtual, permitindo inclusive

movimentos muito difíceis ou impossíveis na realidade física.

Nos gráficos 3D, esses modelos são formados por uma malha (wireframe) de linhas

que determinam planos no espaço tridimensional (eixos x, y, z, correspondentes a largura,

altura, profundidade e localização do objeto no espaço). Essa malha pode ter vários níveis

de detalhamento e complexidade, dependendo do número de linhas, vértices (nós) e planos

do objeto. Assim, se criarmos uma esfera com pouca informação, ou seja, com um

pequeno número de planos e vértices, ela terá um aspecto mais hexagonal do que circular.

Esses objetos 3D adquirem um aspecto mais foto-realístico quando o wireframe é

completado ou renderizado, adicionando tipos de superfícies categorizadas como

“metálicas”, “orgânicas”, “transparentes”, “reflexivas”, etc.

Por meio do software, o computador calcula como será o comportamento dessa

superfície em relação ao seu ambiente virtual, quais serão as partes iluminadas e

sombreadas da superfície, o relevo, se podemos ver alguns objetos atrás de outros

(transparência), se vemos objetos espelhados em outros (reflexo), ou se não vemos

determinadas partes de objetos mais afastados do campo de visão virtual (projeção de

sombras).

Outro exemplo de imagem gerada por computador é o desenho vetorial

bidimensional, que se baseia em vetores matemáticos. Diferentes dos bitmaps, os gráficos

de vetores não são baseados em padrões de pixel, e sim em fórmulas matemáticas que

consistem em linhas e curvas, criando formas. Os gráficos baseados em vetores são mais

leves e não perdem qualidade ao serem ampliados, já que as funções matemáticas são

facilmente adequadas à escala, o que não ocorre com gráficos raster, que utilizam métodos

de interpolação na tentativa de preservar a qualidade. Uma outra vantagem do desenho

Exemplos de programas que trabalham com gráficos vetoriais são: Adobe Illustrator,

CorelDraw, FreeHand e Flash. Esses programas podem também vetorizar as imagens, ou

seja, converter a grade (matriz) de pixels em formas reconhecíveis pelo computador.23

Essa

conversão passa, inevitavelmente, por uma simplificação da imagem, que pode ser alta ou

baixa, dependendo dos parâmetros da conversão. Entende-se aqui que essa “simplificação”

é quantitativa em termos de informação, mas não necessariamente qualitativa.

Na história da pintura moderna isso fica evidente no impressionismo e mais

enfaticamente no pós-impressionismo. Ao reduzirem os elementos da imagem, esta

ganhou maior impacto e capacidade comunicativa da mensagem. Os trabalhos de

Toulouse-Lautrec, inventor do cartaz gráfico, são exemplares nesse sentido. Figuras

formadas por cores chapadas destacavam-se do fundo da imagem, criando condições mais

propícias para uma recepção rápida e em movimento em vias públicas.

Na França, foi um talentoso seguidor de Degas, Henri de Toulouse-Lautrec (1864-1901), que aplicou uma idêntica economia de meios à nova arte do cartaz. Também ele aprendera com as gravuras japonesas que uma ilustração podia tornar-se muito mais impressionante se a modelação e outros detalhes fossem sacrificados a uma audaciosa simplificação.24

Toulouse veio a conhecer as gravuras japonesas através de Van Gogh, mas as

estudou com um objetivo completamente diferente deste. Para Lautrec interessava que a

imagem não se apresentasse como algo fixo, “mas como um tema rítmico que se transmite

ao espectador, atua no nível psicológico como solicitação motora”.25

A idéia de recepção

em trânsito foi pela primeira vez considerada seriamente por um artista.

Foi o primeiro a intuir a importância daquele novo “gênero” artístico, tipicamente urbano, que é a publicidade – desenhar um cartaz ou a capa de um programa constituía, para ele, um compromisso tão sério quanto fazer um quadro. Entende-se: na publicidade,

23 Um programa específico para isso é o Adobe Streamline, com a vantagem de que se pode

automatizar o processo. Isso é particulamente útil quando se precisa vetorizar uma série de imagens como quadros (frames) de um filme ou vídeo. Outro mais atual é o Flix Pro Vector Vídeo. Cf. http://www.wildform.com/flix, http://flix.on2.com/?sid=4BDP-PJ3B-42dd594833889&ref=, http://flix.on2.com/flix/flix_vv.php?sid=A9MN-B4CD-42dd63963be1b&ref=.

para suscitar uma reação, a comunicação é mais importante que a representação. Se a representação é algo que se fixa e mostra, a comunicação se insinua e atinge.26

De forma equivalente aos gráficos, encontramos os vídeos vetoriais (vector-videos),

uma produção extremamente rica a despeito de suas formas simples e escala tonal limitada

(ou justamente por isso). Nos vector-videos, os limites do vídeo e do desenho animado se

tornam esmaecidos. Um ótimo exemplo disso é o filme Waking life, realizado em 2001

(http://www.wakinglifemovie.com). O filme trabalha com a técnica de rotoscopia (na

verdade são dois filmes em um), dando-lhe um tratamento gráfico não exatamente como

vetorização, uma vez que a intervenção humana se dá em todo o processo e não apenas na

configuração de parâmetros da vetorização, mas o resultado plástico é muito semelhante.

No domínio da arte, o numérico renova totalmente as ferramentas e os materiais, que não são mais os do mundo real, mas aqueles da simulação: o artista não trabalha mais com a matéria nem com a energia, mas com programas, direta ou indiretamente. Ora, cada um desses programas só é concebível recorrendo-se a modelos de simulação, que são todos produtos da ciência. A ciência então penetra sem rodeios no coração das ferramentas e materiais. Deste fato decorre uma experiência tecnestésica de uma complexidade sem precedentes.27

Estamos diante da mídia programável como dissemos anteriormente. As

ferramentas de um programa de edição de vídeo, seus chamados filtros, são algoritmos –

uma ou uma série de instruções matemáticas – que fazem alterações nos padrões de pixels

que constituem a imagem do vídeo digital. Esses algoritmos foram elaborados pelas

ciências físicas e matemáticas.

26 “Com Toulouse, pela primeira vez a atividade do artista não mais tende a se concluir num

objeto acabado, o quadro, mas desdobra-se na série ininterrupta das pinturas, das gravuras, dos desenhos, no álbum de esboços que folheamos como se lêssemos uma coletânea de poesias. É a exigência que Mallarmé, nos mesmos anos, coloca para a poesia: a arte não é mais a visão do artista, mas a quintessência de sua existência e experiência.” Cf. ARGAN, Giulio Carlo. Op. cit., p. 127.

1.4. Edição linear, não-linear e a Moviola

Quando surgiu o videocassete, a edição era realizada de modo linear, ou seja, os

trechos do vídeo e do áudio tinham de ser colados um após o outro, linearmente, na ordem

definitiva do vídeo a ser apresentado. O processo se inicia com a decupagem, que consiste

em assistir o material bruto captado e anotar manualmente o timecode dos trechos que

interessam. Após os dados de entrada e saída, inicia-se então a edição propriamente dita:

os trechos selecionados dos videoteipes originais são gravados na fita master. Por meio

dos comandos do controlador de edição, os trechos são copiados linearmente da máquina

de reprodução para a de gravação.

Basicamente, há dois sistemas de edição que no Brasil são chamados de “ilhas de

edição”: a ilha cut (cuts-only systems) e a ilha de finalização (A/B roll systems):

• Ilha cut: duas máquinas de videoteipe, uma de reprodução e outra de gravação,

permitindo apenas edição com corte seco;

• Ilha de finalização: no mínimo três videoteipes, dois de reprodução e um de

gravação. Neste sistema é possível fazer transições que misturem duas imagens, como

fusão e wipe.

Nas duas configurações, as máquinas são comandadas por um equipamento

controlador, que usa a informação do timecode das fitas para fazer as operações de edição.

Nota-se que tanto o acesso ao material como a gravação da fita master ocorrem de modo

seqüencial. Este modo de trabalho era lento e extremamente dispendioso, além de ser uma

atividade cara, em termos de mão-de-obra e equipamento. Na edição linear, uma alternativa

no caso de se querer corrigir algo era copiar todo o trecho já editado e em seguida colá-lo

na seqüência do que fosse modificado. É uma solução mais rápida e menos trabalhosa, mas

tem um grave inconveniente: a imagem copiada sofre perda de qualidade. A cada nova

geração (cópia) de um vídeo analógico a relação sinal/ruído se deteriora.

Sobre relação linear x não-linear, cabe aqui uma analogia explicativa: “A datilografia

videoteipe assim como o processador de texto está para a edição não-linear de vídeo”.28

Na

edição linear, como na máquina datilográfica, se quisermos mudar algum trecho no meio do

vídeo que altere o tempo da edição é preciso reeditar tudo novamente desse ponto em

diante. Já na edição não-linear (randômica, aleatória) tem-se acesso direto a qualquer

trecho de vídeo e pode-se trabalhar em várias versões sem serem excludentes.

Na década de 1970 começaram a aparecer sistemas com computadores que

automatizavam algumas fases da edição, inserindo algumas características da

não-linearidade. Eram equipamentos com a tecnologia mais avançada da época e, obviamente,

caríssimos. Na verdade, eles gerenciavam dispositivos e mídias analógicas (videocassetes

eletromagnéticos). São os chamados sistemas off-line,que trabalhavam com uma alta taxa

de compressão, portanto com uma baixa qualidade de imagem. Uma das formas mais

recorrentes de se fazer isso era através das EDL (edit decision list). Esses sistemas

geravam uma lista, a EDL, que continha todas as decisões da edição, num código padrão

que podia ser lido por outros sistemas que trabalhavam com imagem de alta qualidade

(broadcast), chamados de sistemas on-line. Na época, esses sistemas tinham um forte

componente analógico: todos eram baseados em fita. Eles importavam a EDL,

interpretavam seus dados e solicitavam as fitas na ordem de entrada dos vídeos

escolhidos, refazendo automaticamente toda a edição criada nos sistemas não-lineares

off-line.

O que ocorre na edição não-linear de vídeo é a geração de uma lista de reprodução

comum (play list), determinando um número de itens a serem reproduzidos numa

determinada ordem. A play list representa o princípio por trás da idéia de edição ou

gravação “virtual”: facilidade de modificações e a criação de várias versões do mesmo

projeto. Tudo o que os sistemas não-lineares fazem é tocar a lista de reprodução, exibindo

a seqüência editada em um monitor. As mídias originais permanecem intactas em seus

suportes. A partir da play list, os sistemas geram a EDL, o que possibilita reconstruir a

edição em qualquer sistema capaz de interpretá-lo, seja linear ou não-linear.

Quando a Apple lançou o primeiro computador Macintosh em 1984,29

usou o termo

desktop (mesa de trabalho) como metáfora para designar sua interface gráfica, a qual

representava na tela do monitor elementos comuns aos escritórios (pastas, arquivos e

lixeira). No ano seguinte, a empresa Aldus lançou o programa PageMaker para o

Macintosh. O programa comportava todo o processo de editoração de livros ou

publicações, da entrada de texto à criação do layout de página. A Aldus denominou esse

novo modo de produção de desktop publishing system, fazendo referência ao sistema

operacional da Apple, e também para destacar que o trabalho que antes envolvia muitas

pessoas e espaços amplos podia, a partir de então, ser realizado por uma única pessoa

sobre uma mesa.

Com o tempo, a expressão desktop publishing tornou-se uma designação geral para

ferramentas de editoração para computador pessoal (PC - Personal Computer),

envolvendo outros programas e outras plataformas (Windows, Linux, etc), tornando-se

uma marca desse tipo de trabalho. O prefixo desktop se generalizou para outros

processos de trabalho que foram desenvolvidos para PCs. Todos tinham em comum o fato

de serem sistemas mais baratos, mais fáceis de usar e que exigiam menos espaço que os

sistemas “não-desktop”.

O desktop vídeo surgiu com o lançamento do QuickTime da Apple em 1991, mas a

prática e a popularização desta forma de trabalhar com vídeo em computadores pessoais

aconteceu de fato com o fenômeno Avid. Em 1992, a empresa Avid Technologies lançou

os primeiros sistemas digitais de edição não-linear de vídeo por computador que realmente

funcionavam. Substituem-se as salas de edição com diversos equipamentos grandes e caros

por uma mesa, um computador com placas de captura, um videocassete e dois monitores.

29

fig 6 –moviola

O que a Avid conseguiu foi desenvolver um software que fazia uma boa integração desses

equipamentos.

Estava ocorrendo não uma mera substituição de equipamentos, mas a implantação de novos processos de trabalho e criação fundamentados em novos conceitos e paradigmas para a pós-produção de vídeo. Era, de fato, o início da grande revolução do desktop vídeo nas indústrias de vídeo, televisão e cinema.30

No entanto, acreditamos que a edição não-linear não surgiu originalmente da fusão do

computador com o vídeo. Seu background está no cinema, com a moviola, mesa de

montagem composta de sistema óptico com visor, cabeças leitoras de som, pratos

giratórios que acomodam e rodam carretéis de filme e rolos de fitas magnéticas perfuradas

que correspondem ao registro do som. A moviola foi uma tecnologia bastante utilizada

para a edição de cinema. É importante assinalar essa informação, pois a moviola é a

metáfora básica da interface gráfica de softwares não-lineares de vídeo, assim como o

desktop (mesa de trabalho) é a metáfora dos sistemas operacionais.

A edição na moviola ocorria

depois das filmagens, quando trechos

escolhidos pelo diretor eram copiados

em laboratório em rolos de “copião”.

Na mesa de montagem da moviola, o

copião é “desbastado”, restando

somente os trechos que serão

utilizados na cena. O desbaste é feito

com a cortadeira, e o material restante

é armazenado numa caixa (trim bin).

Segmentos de som e imagem

selecionados são separados,