Universidade Federal do Rio Grande do Norte

Centro de Ciˆencias Exata e da Terra

Programa de P´os-Gradua¸c˜ao em Matem´atica Aplicada e Estat´ıstica

Ivanildo Freire Pereira

Parˆ

ametro de Regulariza¸

c˜

ao em Problemas Inversos:

Estudo num´erico com a transformada de RadonIvanildo Freire Pereira

Parˆ

ametro de Regulariza¸

c˜

ao em Problemas Inversos:

Estudo num´erico com a transformada de RadonTrabalho apresentado ao Programa de P´os-Gradua¸c˜ao em Matem´atica Aplicada e Estat´ıstica da Universidade Federal do Rio Grande do Norte, em cumprimento com as exigˆencias legais para obten¸c˜ao do t´ıtulo de Mestre.

´

Area de Concentra¸c˜ao: Modelagem Mate-m´atica

Orientador:

Prof. Dr. Roberto Hugo Bielschowsky

Cataloga¸c˜ao da Publica¸c˜ao na Fonte. UFRN / SISBI / Biblioteca Setorial

Centro de Ciˆencias Exatas e da Terra – CCET.

Pereira, Ivanildo Freire.

Parˆametro de regulariza¸c˜ao em problemas inversos: estudo num´erico com a transformada de Radon / Ivanildo Freire Pereira. - Natal, 2013

171 f. il.

Orientador: Prof. Dr. Roberto Hugo Bielschowsky.

Disserta¸c˜ao (Mestrado) – Universidade Federal do Rio Grande do Norte. Centro de Ciˆen-cias Exatas e da Terra. Programa de P´os-Gradua¸c˜ao em Matem´atica Aplicada e Estat´ıstica.

1. Matem´atica - Disserta¸c˜ao. 2. Modelagem matem´atica - Disserta¸c˜ao. 3. Problemas inver-sos - Disserta¸c˜ao. 4. Regulariza¸c˜ao - Disserta¸c˜ao. 5. Discrepˆancia - Disserta¸c˜ao. 6. Parˆametro ´

otico - Disserta¸c˜ao. I. Bielschowsky, Roberto Hugo. II. T´ıtulo.

RN/UF/BSE-CCET CDU: 51

Dedicat´

oria

Agradecimentos

Grato a Deus por ter me guiado e me ajudado nos momentos dif´ıceis. Aos meus pais, Arnor Pereira e Maria de Lourdes, que me auxiliaram a superar os obst´aculos, desde os meus primeiros passos e mais fortemente na vida acadˆemica.

A todos os meus familiares, em especial Raimundo e Maria Dulce, pois sem os seus pr´estimos e cuidados a caminhada teria sido mais ´ardua. A seus filhos e respectivos cˆonjuges, Jo˜ao Maria e Maria das Vit´orias, Gilvaneide e S´ergio Mur´ılo, bem como Gilvan e Neide, pela companhia, risadas e momentos de descontra¸c˜ao, mesmo que em muitas vezes n˜ao conseguir comparecer, pois estava estudando. Aos meus irm˜aos, principalmente Ivo Pereira e Anderson Freire, pelas colabora¸c˜oes no decorrer desta caminhada. Ao meu orientador, o Professor Roberto Hugo Bielschowsky, que, com muita paciˆencia e aten¸c˜ao, dedicou o seu valioso tempo para me orientar em cada passo deste trabalho.

A minha namorada e amiga, Tatiana Maria, pela paciˆencia e por ceder seu tempo para ser meu porto seguro nos momentos de afli¸c˜oes, ang´ustias e d´uvidas.

A todos os professores do Programa de P´os-Gradua¸c˜ao de Matem´atica e Estat´ıstica, por toda dedica¸c˜ao destinada ao ensino e aprendizagem nas disciplinas ministradas; em especial, o professor Bernardo pela paciˆencia e aux´ılios nos m´etodos computacionais.

Aos professores do C&T, Leo Gouvˆeia, Leo Mafra e Andr´e, pela aten¸c˜ao e compre-ens˜ao enquanto estava no programa de bolsa REUNI.

Aos meus amigos de turma M´arico (Marcinho), Aldemir (o Will), Jucimeire (a Ju), Alex (Arhex), F´abio (Fab˜ao), Josemir (Jorheu) e Elisˆangela.

Aos meus amigos que encontrei no percurso, H´erica, Elvis, Antˆonio, Rafaella. Em especial a C´atia, pelas dicas e aux´ılio nas implementa¸c˜oes.

Aos Professores Dr. Nir Cohen, Dr. Walter Eugˆenio de Medeiros, Dr. Edgar Silva Pereira e Dr. Reginaldo de Jesus Santos por aceitarem o convite para participar da minha banca de defesa.

A CAPES pelo apoio financeiro.

Resumo

Em linhas bem gerais, um problema inverso corresponde a encontrar um valor para um elementoxem algum espa¸co vetorial adequado, dado um vetor de medidas y. Quando discretizamos o problema, usualmente se recai num sistema de equa¸c˜oes f(x) = y, onde f : U ⊂ Rm →Rn representa a fun¸c˜ao de medidas em algum dom´ınioU do Rm

adequado. Via de regra, chega-se a um problema mal-posto. A resolu¸c˜ao de problemas inversos tem sido amplamente pesquisada ao longo das ´ultimas d´ecadas, pois muitos problemas nas ciˆencias puras e ind´ustria consistem na determina¸c˜ao de grandezas que buscamos conhecer atrav´es de efeitos observados.

Nosso tema geral desta disserta¸c˜ao ´e a escolha do parˆametro de regulariza¸c˜ao de Tykhonov de um problema linear mal condicionado, conforme discutiremos no cap´ıtulo 1 da disserta¸c˜ao, com foco nos trˆes m´etodos mais “populares” hoje na literatura da ´area. Nosso foco mais espec´ıfico nesta disserta¸c˜ao consiste nas simula¸c˜oes realizadas no cap´ıtulo 2, visando comparar a performance dos trˆes m´etodos na recupera¸c˜ao de imagens medidas com a transformada de Rad´on e acrescidas de ru´ıdos gaussianos iid. Como regularizador usamos um operador de diferen¸cas.

A contribui¸c˜ao que tentamos dar, nesta disserta¸c˜ao, consiste na discuss˜ao das simu-la¸c˜oes num´ericas que realizamos, conforme exporemos no cap´ıtulo 2. Entendemos que o sentido desta disserta¸c˜ao est´a muito mais nas quest˜oes que levanta do que no fato de poder dizer algo definitivo sobre o tema em tela. Em parte, por se tratar de experimen-tos num´ericos sem resultados matem´aticos novos que os acompanhem. Em parte, por se tratar de experimentos num´ericos realizados com um ´unico operador. Em compen-sa¸c˜ao, chegamos a algumas observa¸c˜oes que nos parecem interessantes, nas simula¸c˜oes realizadas, considerada a literatura da ´area. Em especial destacamos observa¸c˜oes que fizemos sobre as diferentes voca¸c˜oes dos m´etodos GCV e L-curve e, em particular, so-bre a tendˆencia dos parˆametros obtidos com o m´etodo L-curve de se agruparem num pequeno intervalo fortemente correlacionado com o comportamento da curva de va-lores singulares generalizados dos operadores envolvidos, sob condi¸c˜oes razoavelmente abrangentes de regularidade nas imagens a serem recuperadas.

Palavras-chave: Problemas Inversos, Regulariza¸c˜ao, Tykhonov, GCV, L-curve, Discrepˆancia, Rad´on, GSVD, Parˆametro ´Otimo

Abstract

In general, an inverse problem corresponds to find a value of an elementxin a suitable vector space, given a vector y measuring it, in some sense. When we discretize the problem, it usually boils down to solve an equation system f(x) = y, where f : U ⊂ Rm → Rn represents the step function in any domain U of the appropriate Rm. As a

general rule, we arrive to an ill-posed problem. The resolution of inverse problems has been widely researched along the last decades, because many problems in science and industry consist in determining unknowns that we try to know, by observing its effects under certain indirect measures.

Our general subject of this dissertation is the choice of Tykhonov’s regulaziration parameter of a poorly conditioned linear problem, as we are going to discuss on chapter 1 of this dissertation, focusing on the three most popular methods in nowadays litera-ture of the area. Our more specific focus in this dissertation consists in the simulations reported on chapter 2, aiming to compare the performance of the three methods in the recuperation of images measured with the Radon transform, perturbed by the addition of gaussian i.i.d. noise. We choosed a difference operator as regularizer of the problem. The contribution we try to make, in this dissertation, mainly consists on the discus-sion of numerical simulations we execute, as is exposed in Chapter 2. We understand that the meaning of this dissertation lays much more on the questions which it rai-ses than on saying something definitive about the subject. Partly, for beeing based on numerical experiments with no new mathematical results associated to it, partly for being about numerical experiments made with a single operator. On the other hand, we got some observations which seemed to us interesting on the simulations performed, considered the literature of the area. In special, we highlight observations we resume, at the conclusion of this work, about the different vocations of methods like GCV and L-curve and, also, about the optimal parameters tendency observed in the L-curve method of grouping themselves in a small gap, strongly correlated with the behavior of the generalized singular value decomposition curve of the involved operators, under reasonably broad regularity conditions in the images to be recovered.

Keywords: Inverse Problems, Regularization, Tykhonov, GCV, L-curve, Discrepancy, Rad´on, GSVD, Optimal Parameter

Sum´

ario

1 Escolha do parˆametro na regulariza¸c˜ao de Tykhonov 1

1.1 Problemas Inversos e Regulariza¸c˜ao . . . 3

1.2 SVD e GSVD . . . 6

1.3 L-Curve . . . 13

1.3.1 L-curve contra Mudan¸cas de escala no regularizadorL . . . 18

1.4 GCV . . . 22

1.5 Discrepˆancia ou Crit´erio de Morozov . . . 25

1.6 Compara¸c˜oes na Literatura: L-Curve versus GCV . . . 26

2 Simula¸c˜oes para obten¸c˜ao de parˆametros ´otimos de regulariza¸c˜ao 28 2.1 Imagens para teste . . . 28

2.2 Simula¸c˜ao com GSVD . . . 30

2.2.1 Experimentos num´ericos realizados . . . 30

2.2.2 Ambiguidades no m´etodo L-curve . . . 34

2.2.3 Resultados colhidos . . . 39

2.3 Discuss˜ao dos resultados obtidos . . . 42

2.3.1 Com rela¸c˜ao aos ¯λ ´otimos . . . 42

2.3.2 Erros relativos nas recupera¸c˜oes . . . 47

2.3.3 P´os-processamento . . . 49

3 Considera¸c˜oes Finais 52 3.1 Conclus˜oes . . . 53

3.2 Trabalhos futuros . . . 55

C.2 Ordena¸c˜ao das imagens relativamente `a fatora¸c˜ao GSVD do par (A, L) . 68

D Pontos de m´aximo da curvatura da L-curve 73

D.1 Gr´aficos das curvaturas da L-Curve na escala loglog . . . 76 D.2 Imagens correspondentes aos m´aximos locais na curvatura . . . 82

E Tabelas dos desvios padr˜oes 91

F Tabelas dos λ ´otimos 94

G Figuras das Recupera¸c˜oes 97

Lista de Figuras

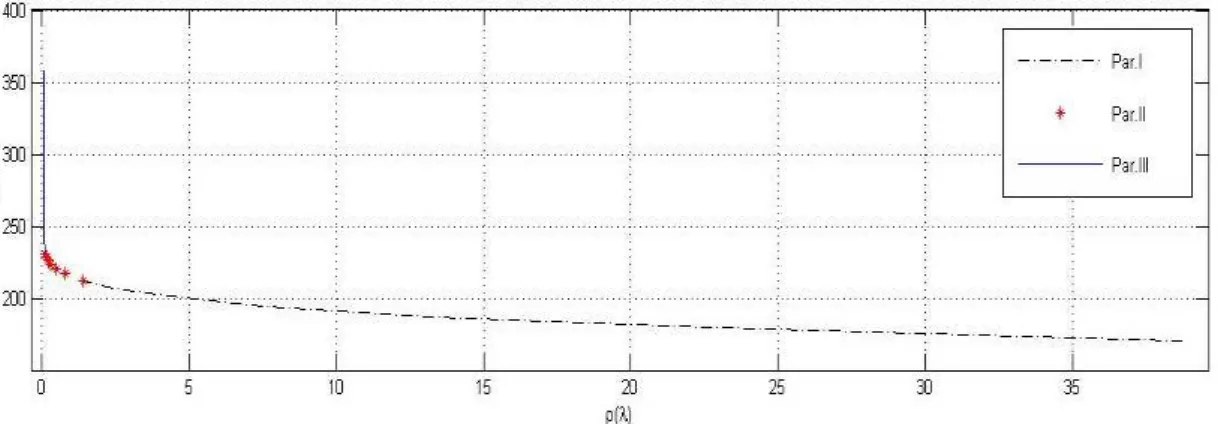

1.1 Gr´afico t´ıpico do m´etodo L-curve . . . 15

1.2 Gr´afico t´ıpico do m´etodo L-curve dividida em 3 partes . . . 15 1.3 As seis figuras acima correspondem a recupera¸c˜oes feitas com parˆametro

de regulariza¸c˜ao calculado pelo m´etodo L-curve linlin e dado por 1.44-1.45, para os problemas 1.37, com 6 valores diferentes para C =Cd. λC

representa o parˆametro ´otimo, correspondente a cada C e λβ = λCC

´e o parˆametro da solu¸c˜ao ´otima ¯xλC = xλβ correspondente. No

qua-dro abaixo, mais `a esquerda, est˜ao as L-curves correspondentes a cada uma das 6 escalas para a regulariza¸c˜ao. Nos dois quadros derradeiros est˜ao gr´aficos da curvatura nas vari´aveis tratadas. O da direita, usa uma vari´avelλcomum a todas as curvas e `as solu¸c˜oes ´otimas como reparame-triza¸c˜oes da curva originalxλ. Ao meio, cada curvatura est´a representada

em sua escala espec´ıfica ¯λ=λ/Cd. . . 21

2.1 12 imagens para testes em ordem aproximadamente decrescente de con-centra¸c˜ao, tanto na base dos vetores singulares `a direita da decomposi¸c˜ao GSVD, como na transformada discreta de cossenos em torno da origem. 29 2.2 Em cada quadro, situamos os pontos de m´aximo da curvatura da L-curve

na escala loglog em cima do gr´afico dos valores singulares generalizados do par (A, L), para um dos valores de ǫ indicados e para cada uma das imagens S1,S2, · · ·, S12. A regra para situar cada ponto no gr´afico

´e de forma que a cada ponto de m´aximo local ¯λLC da curvatura, lhe

corresponda um valor de i entre 1 e N, tal que λLC =Cdλ¯LC =γi, para

algum i entre 1 eN. . . 37

2.4 Cada quadro representa um n´ıvel de ruido e cada curva os valores es-timados de cada parˆametro ´otimo, ou seja, cada curva representa os parˆametros ¯λ ´otimos obtidos por um dos 3 m´etodos (L-curve, GCV e Discrepˆancia) ou para o parˆametro ¯λEmin, para cada uma das 12

ima-gens. Note que, os dois primeiros gr´aficos est˜ao com escalas diferentes dos trˆes derradeiros e que os parˆametros ´otimos est˜ao todos na escala de ¯

λ=λ/Cd. . . 40

2.5 Cada quadro representa um dos parˆametros ¯λ ´otimos considerados e cada curva seus valores para cada uma das imagens, em um dos n´ıveis de ruido. Note que para a L-curve a escala ´e diferente da que empregamos nos demais e que os parˆametros ´otimos est˜ao todos na escala de ¯λ=λ/Cd. 41

2.6 As curvas mostram os erros relativos correspondentes `as solu¸c˜oes obtidas a partir de cada ¯λ ´otimo, para os 5 n´ıveis de ruidos e 12 imagens. Vale verificar que as escalas dos dois primeiros quadros s˜ao diferentes dos demais. . . 48

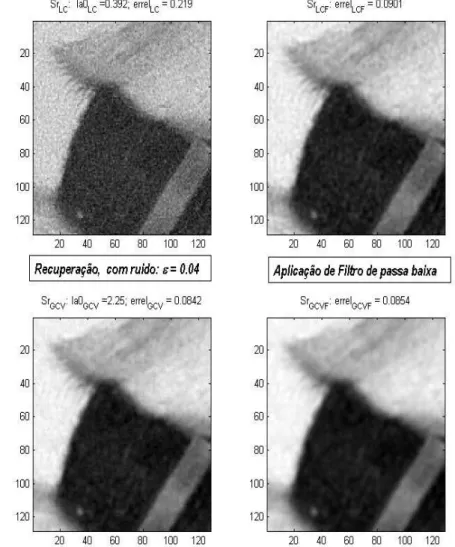

2.7 Nas duas imagens do meio da figura, est˜ao as recupera¸c˜oes da imagem S5, obtidas com os parˆametros ¯λ ´otimos dos m´etodos L−curveeGCV.

Nas duas da direita, estas mesmas imagens filtradas via convolu¸c˜ao com um filtro 3x3 . . . 50

A.1 Transformada Radon. Reproduzido de [21]. . . 57

A.2 Discretiza¸c˜ao da Transformada Radon . . . 58

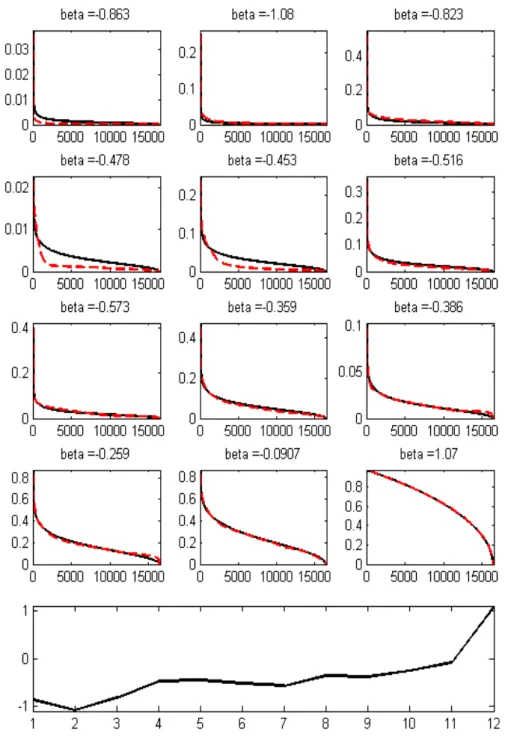

C.1 Distribui¸c˜ao de Picard vT

i sj, em valor absoluto, para cada uma das 12

imagensSj, vetorizadas e normalizadas, ou seja, com norma de Frobenius

unit´aria. As curvas em preto representam os ajustes a Ckα, dos dados

dos coeficientes de Picard de Vt∗s

j entre k0 = 10 e k =N, para cada

uma das 12 imagens. No gr´afico abaixo e `a esquerda, resgistramos os expoentes α obtidos para cada uma das 12 imagens. . . 65

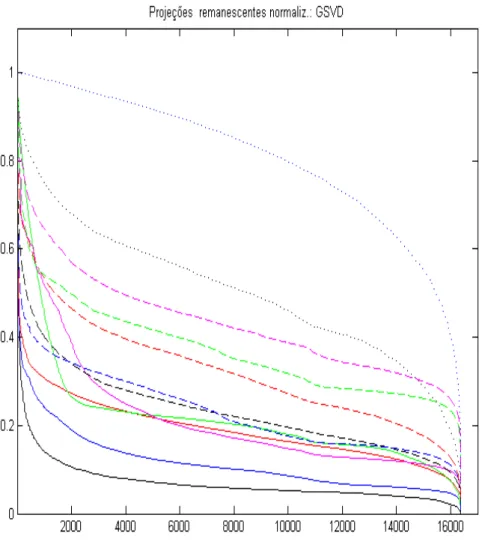

C.2 Compara¸c˜ao do ajuste `a kP rojKk via GSVD das duas maneiras

indi-cadas logo acima. Cada um dos 12 quadros iniciais corresponde a uma das Sj da figura 2.1. Nas linhas cheias azuis est˜ao os gr´aficos de cada

kP rojKk, correspondentes a cada Sj. Nas linhas curva tracejada preta

temos os correspondentes ajustes a kP rojKk, obtidos a partir do ajuste

de pick via C.1 e usando a f´ormula C.3. Na linha pontilhada vermelha

temos o ajuste feito diretamente aF(K,Γ, α) via C.4. Na curva de baixo temos um gr´afico com os coeficientesα que medem a “ regularidade `a la

Picard” via SVD, obtidas com os dois ajustes. . . 67

C.3 Cada curva representa kP rojKk, via GSVD e de forma correspondente a cada uma das doze imagens, ordenadas da forma que indicamos na figura 2.1 da se¸c˜ao 2.1. . . 69

C.4 Nos doze quadros iniciais est˜ao os ajustes dekP rojKk=k P k=1 N−K (ϕkx∗)wkk a F(K,Γ, α) = Γ q 1−(K/N)β, via quadrados m´ınimos, onde x∗ = ΣNk=1−Kϕkwk. No ´ultimo quadro tra¸camos um gr´afico do expoente β, em fun¸c˜ao das 12 imagens encontradas. . . 70

C.5 Gr´aficos de kP rojKk, para cada uma das imagens, relativamente a pro-je¸c˜oes segundo tres bases diferentes, conforme discutidas no ´ultimo pa-r´agrafo deste apˆendice. Na de cima, a norma da proje¸c˜ao ortogonal no SEV dos vetores singulares `a esquerda associado aos K menores valores singulares de SVD. Na do meio, a norma da proje¸c˜ao definida por C.5 e na de baixo, a norma da proje¸c˜ao no subespa¸co associado `as frequˆencias fora do quadradoK×K. Devidamente normalizadas a partir da segunda componente. . . 72

D.1 Gr´aficos de ¯λLC2, que estamos definindo como pontos de ´otimo no m´e-todo L-curve, das 12 imagens consideradas, para 5 n´ıveis de ru´ıdo, com ǫ=.001, .004, .01, .04, .1 . . . 74

D.2 Gr´aficos com a curvaturaKlog(¯λ) delog(L(¯λ) = [log( ¯rho(¯λ)), log(¯η(¯λ))]contra ¯ λ, para um ru´ıdo gaussiano i.i.d. com norma ǫkb − mean(b)k, onde ǫ = .001 e de forma a explicitar seus pontos de m´aximo. Observe nos t´ıtulos de cada quadro os valores correspondentes destes m´aximos para ¯ λ no vetor ¯λ0(KM) = [LC1, LC2, LC3], sendo que LCi = − − −,caso n˜ao haja o correspondente valor de m´aximo. . . 77

D.3 O mesmo que na figura anterior, s´o que para ǫ= 0.004 . . . 78

D.4 O mesmo que na figura anterior, s´o que para ǫ= 0.01 . . . 79

D.5 O mesmo que na figura anterior, s´o que para ǫ= 0.04 . . . 80

D.6 O mesmo que na figura anterior, s´o que para ǫ= 0.1 . . . 81 D.7 Recupera¸c˜oes das imagens nos pontosxλ¯LCi, onde ¯λLCi ´e um dos pontos

de m´aximo da curvatura da L-Curve na escala loglog, correspondentes a S1 e a um n´ıvel de ru´ıdo = 0.004 . . . 82

D.8 Recupera¸c˜oes das imagens nos pontosxλ¯LCi, onde ¯λLCi ´e um dos pontos

de m´aximo da curvatura da L-Curve na escala loglog, correspondentes a S2 e a um n´ıvel de ru´ıdo = 0.004 . . . 83

D.9 Recupera¸c˜oes das imagens nos pontosxλ¯LCi, onde ¯λLCi ´e um dos pontos

de m´aximo da curvatura da L-Curve na escala loglog, correspondentes a S4 e a um n´ıvel de ru´ıdo = 0.004 . . . 83

D.10 Recupera¸c˜oes das imagens nos pontosxλ¯LCi, onde ¯λLCi ´e um dos pontos

de m´aximo da curvatura da L-Curve na escala loglog, correspondentes a S2 e a um n´ıvel de ru´ıdo = 0.01 . . . 84

D.11 Recupera¸c˜oes das imagens nos pontosxλ¯LCi, onde ¯λLCi ´e um dos pontos

de m´aximo da curvatura da L-Curve na escala loglog, correspondentes a S3 e a um n´ıvel de ru´ıdo = 0.01 . . . 84

D.12 Recupera¸c˜oes das imagens nos pontosxλ¯LCi, onde ¯λLCi ´e um dos pontos

de m´aximo da curvatura da L-Curve na escala loglog, correspondentes a S4 e a um n´ıvel de ru´ıdo = 0.01 . . . 85

D.13 Recupera¸c˜oes das imagens nos pontosxλ¯LCi, onde ¯λLCi ´e um dos pontos

de m´aximo da curvatura da L-Curve na escala loglog, correspondentes a S7 e a um n´ıvel de ru´ıdo = 0.01 . . . 85

D.14 Recupera¸c˜oes das imagens nos pontosxλ¯LCi, onde ¯λLCi ´e um dos pontos

de m´aximo da curvatura da L-Curve na escala loglog, correspondentes a S9 e a um n´ıvel de ru´ıdo = 0.01 . . . 86

D.15 Recupera¸c˜oes das imagens nos pontosxλ¯LCi, onde ¯λLCi ´e um dos pontos

de m´aximo da curvatura da L-Curve na escala loglog, correspondentes a S3 e a um n´ıvel de ru´ıdo = 0.04 . . . 86

D.16 Recupera¸c˜oes das imagens nos pontosxλ¯LCi, onde ¯λLCi ´e um dos pontos

de m´aximo da curvatura da L-Curve na escala loglog, correspondentes a S5 e a um n´ıvel de ru´ıdo = 0.04 . . . 87

D.17 Recupera¸c˜oes das imagens nos pontosxλ¯LCi, onde ¯λLCi ´e um dos pontos

de m´aximo da curvatura da L-Curve na escala loglog, correspondentes a S6 e a um n´ıvel de ru´ıdo = 0.04 . . . 87

D.18 Recupera¸c˜oes das imagens nos pontosxλ¯LCi, onde ¯λLCi ´e um dos pontos

de m´aximo da curvatura da L-Curve na escala loglog, correspondentes a

S7 e a um n´ıvel de ru´ıdo = 0.04 . . . 88

D.19 Recupera¸c˜oes das imagens nos pontosxλ¯LCi, onde ¯λLCi ´e um dos pontos de m´aximo da curvatura da L-Curve na escala loglog, correspondentes a S8 e a um n´ıvel de ru´ıdo = 0.04 . . . 88

D.20 Recupera¸c˜oes das imagens nos pontosxλ¯LCi, onde ¯λLCi ´e um dos pontos de m´aximo da curvatura da L-Curve na escala loglog, correspondentes a S9 e a um n´ıvel de ru´ıdo = 0.04 . . . 89

D.21 Recupera¸c˜oes das imagens nos pontosxλ¯LCi, onde ¯λLCi ´e um dos pontos de m´aximo da curvatura da L-Curve na escala loglog, correspondentes a S5 e a um n´ıvel de ru´ıdo = 0.1 . . . 89

D.22 Recupera¸c˜oes das imagens nos pontosxλ¯LCi, onde ¯λLCi ´e um dos pontos de m´aximo da curvatura da L-Curve na escala loglog, correspondentes a S10 e a um n´ıvel de ru´ıdo = 0.1 . . . 90

G.1 Imagem originalS1. . . 98

G.2 N´ıvel de ru´ıdo ǫ = 0.001 . . . 99

G.3 N´ıvel de ru´ıdo ǫ = 0.01 . . . 100

G.4 N´ıvel de ru´ıdo ǫ = 0.1 . . . 101

G.5 Imagem originalS2. . . 102

G.6 N´ıvel de ru´ıdo ǫ = 0.001 . . . 103

G.7 N´ıvel de ru´ıdo ǫ = 0.01 . . . 104

G.8 N´ıvel de ru´ıdo ǫ = 0.1 . . . 105

G.9 Imagem originalS3. . . 106

G.10 N´ıvel de ru´ıdo ǫ = 0.001 . . . 107

G.11 N´ıvel de ru´ıdo ǫ = 0.01 . . . 108

G.12 N´ıvel de ru´ıdo ǫ = 0.1 . . . 109

G.13 Imagem originalS4. . . 110

G.14 N´ıvel de ru´ıdo ǫ = 0.001 . . . 111

G.15 N´ıvel de ru´ıdo ǫ = 0.01 . . . 112

G.16 N´ıvel de ru´ıdo ǫ = 0.1 . . . 113

G.17 Imagem originalS5. . . 114

G.18 N´ıvel de ru´ıdo ǫ = 0.001 . . . 115

G.19 N´ıvel de ru´ıdo ǫ = 0.01 . . . 116

G.20 N´ıvel de ru´ıdo ǫ = 0.1 . . . 117

G.21 Imagem originalS6. . . 118

G.22 N´ıvel de ru´ıdo ǫ = 0.001 . . . 119

G.23 N´ıvel de ru´ıdo ǫ = 0.01 . . . 120

G.24 N´ıvel de ru´ıdo ǫ = 0.1 . . . 121

G.25 Imagem originalS7. . . 122

G.26 N´ıvel de ru´ıdo ǫ = 0.001 . . . 123

G.27 N´ıvel de ru´ıdo ǫ = 0.01 . . . 124

G.28 N´ıvel de ru´ıdo ǫ = 0.1 . . . 125

G.29 Imagem originalS8. . . 126

G.30 N´ıvel de ru´ıdo ǫ = 0.001 . . . 127

G.31 N´ıvel de ru´ıdo ǫ = 0.01 . . . 128

G.32 N´ıvel de ru´ıdo ǫ = 0.1 . . . 129

G.33 Imagem originalS9. . . 130

G.34 N´ıvel de ru´ıdo ǫ = 0.001 . . . 131

G.35 N´ıvel de ru´ıdo ǫ = 0.01 . . . 132

G.36 N´ıvel de ru´ıdo ǫ = 0.1 . . . 133

G.37 Imagem originalS10. . . 134

G.38 N´ıvel de ru´ıdo ǫ = 0.001 . . . 135

G.39 N´ıvel de ru´ıdo ǫ = 0.01 . . . 136

G.40 N´ıvel de ru´ıdo ǫ = 0.1 . . . 137

G.41 Imagem originalS11. . . 138

G.42 N´ıvel de ru´ıdo ǫ = 0.001 . . . 139

G.43 N´ıvel de ru´ıdo ǫ = 0.01 . . . 140

G.44 N´ıvel de ru´ıdo ǫ = 0.1 . . . 141

G.45 Imagem originalS12. . . 142

G.46 N´ıvel de ru´ıdo ǫ = 0.001 . . . 143

G.47 N´ıvel de ru´ıdo ǫ = 0.01 . . . 144

G.48 N´ıvel de ru´ıdo ǫ = 0.1 . . . 145

Lista de Tabelas

2.1 A coluna 1 representa cada imagem rodada e as outras colunas a raz˜ao E(kAx¯λGCV¯ −bk)/E(Ax¯λ¯

Emin −b

) para cada n´ıvel de ruido . . . 44 2.2 A coluna 1 representa cada imagem rodada e as outras colunas a raz˜ao

2.6 para cada n´ıvel de ruido . . . 45 2.3 A coluna 1 representa cada imagem rodada e as outras colunas a raz˜ao

kx¯¯

λGCV−x¯¯

λEmink

kx∗−x∗mk para cada n´ıvel de ruido . . . 45

D.1 Cada coluna representa o valor de ¯λLC2, que estamos definindo como o

ponto de ´otimo no m´etodo L-curve. Cada coluna corresponde a um n´ıvel de erro associado a um dado valor de ǫ . . . 74

E.1 A primeira coluna representa as imagens testadas. As outrasdesvio padr˜aom´edia dos parˆametros ´otimos testados e indicados na primeira linda da tabela, para ǫ= 0.0001 . . . 91 E.2 A primeira coluna representa as imagens testadas. As outrasdesvio padr˜aom´edia

dos parˆametros ´otimos testados e indicados na primeira linda da tabela, para ǫ= 0.001 . . . 92 E.3 A primeira coluna representa as imagens testadas. As outrasdesvio padr˜aom´edia

dos parˆametros ´otimos testados e indicados na primeira linda da tabela, para ǫ= 0.01 . . . 92 E.4 A primeira coluna representa as imagens testadas. As outrasdesvio padr˜aom´edia

dos parˆametros ´otimos testados e indicados na primeira linda da tabela, para ǫ= 0.04 . . . 93 E.5 A primeira coluna representa as imagens testadas. As outrasdesvio padr˜aom´edia

dos parˆametros ´otimos testados e indicados na primeira linda da tabela, para ǫ= 0.1 . . . 93

F.1 Os parˆametros ´otimos para os m´etodo L-curve, GCV e o Discrepˆancia, junto com o m´ınimo de kx∗0−x¯

¯

F.2 Os parˆametros ´otimos para os m´etodo L-curve, GCV e o Discrepˆancia, junto com o m´ınimo de kx∗0−x¯

¯

λk, respectivamente, para o ǫ= 0.001 . 95

F.3 Os parˆametros ´otimos para os m´etodo L-curve, GCV e o Discrepˆancia, junto com o m´ınimo de kx∗0−x¯

¯

λk, respectivamente, para o ǫ= 0.01 . . 95

F.4 Os parˆametros ´otimos para os m´etodo L-curve, GCV e o Discrepˆancia, junto com o m´ınimo de kx∗0−x¯

¯

λk, respectivamente, para o ǫ= 0.04 . . 96

F.5 Os parˆametros ´otimos para os m´etodo L-curve, GCV e o Discrepˆancia, junto com o m´ınimo de kx∗0−x¯

¯

λk, respectivamente, para o ǫ= 0.1 . . 96

Lista de Siglas

GCV Generalized Cross Validation

i.i.d. Independente identicamente distribu´ıda.

SVD Singular Value Decomposition.

GSVD Generalized Singular Value Decomposition.

RAM Random Access Memory.

GHz Gigahertz (unidada de frequˆencia).

OCV Ordinary Cross Validation.

DCT2 Transformada Discreta de Cossenos Bidimensional.

fminbnd Fun¸c˜ao do software matlab que calcula o m´ınino local de uma fun¸c˜ao de uma vari´avel num intervalo.

fzero Fun¸c˜ao do software matlab que encontra as ra´ızes de fun¸c˜oes de uma vari´avel.

Lista de S´ımbolos

x Imagem vetorizada a ser recuperada.

A Transformada de R´adon.

N N´umero de vari´aveis da matriz de medidas.

M N´umero de linhas de A.

L Matriz de regulariza¸c˜ao.

p N´umero de linhas de L.

q ´Indice da norma (ou semi-norma) do termo de regulariza¸c˜ao.

λ Parˆametro de regulariza¸c˜ao.

x0 Aproxima¸c˜ao inicial para a solu¸c˜ao desejada.

xλ Solu¸c˜ao da regulariza¸c˜ao de Tykhonov.

I Matriz identidade.

b∗ Medidas sem ru´ıdos.

x∗ Imagem original.

b Medidas com a presen¸ca de ru´ıdo b=b∗+ ru´ıdo.

bm M´edia dosbi.

r Ru´ıdo gaussiano de m´edia zero, i.i.d. nas M medidas realizadas.

U, V e WT U Matriz dos vetores singulares a esquerda de A, associada a SVD,

bem como a matriz dos vetores singulares a esquerda deAno GSVD. J´a V ´e a matriz dos vetores singulares a direita de A na decompo-si¸c˜ao SVD e a matriz dos vetores singulares a esquerda de L para a decomposi¸c˜ao GSVD. WT ´e uma matriz n˜ao-singular associada ao

lado direito das matrizes A e L na decomposi¸c˜ao GSVD para o par matricial (A, L). Vale dizer que as matrizes U, V e Σ da GSVD s˜ao diferentes, para L 6= I, das geradas pela decomposi¸c˜ao SVD de A. Mantemos a mesma nomenclatura para n˜ao carregar as nota¸c˜oes.

ΣN Matriz diagonal N ×N, com os valores singulares da matriz A na

diagonal, de 1 aN.

Σ Matriz com dois blocos, onde acima fica ΣN e abaixo um bloco de

zeros.

ui,vi ewTi ui i-´esimo vetor singular a esquerda deA, , ou i-´esimo vetor singular

a esquerda de A, na i-´esima coluna da matriz U da decomposi¸c˜ao GSVD. A i-´esima coluna de V ´e denotada por vi nas duas

decom-posi¸c˜oes, SVD e GSVD, sendo V dado como prescrito acima. E wT i

´e a i-´esima coluna da matriz n˜ao-singular WT, na decomposi¸c˜ao do

par matricial (A, L). Lembramos queui evi na decomposi¸c˜ao GSVD,

para L6=I, s˜ao diferentes dos ui evi da decomposi¸c˜ao SVD.

σi i-´esimo valor singular da matriz A = UΣVT, na diagonal de Σ, na

decomposi¸c˜ao SVD e, correspondentemente, tamb´em na fatora¸c˜ao A=UΣWT que se obtem via GSVD.

C Matriz diagonal associada os valores singulares deLna decomposi¸c˜ao GSVD.

µi i-´esimo valor singular da matriz L, conforme aparece na diagonal de

M, na fatora¸c˜ao A=VCW−1, obtida via decomposi¸c˜ao GSVD.

γi i-´esimo valor singular generalizado do par matricial (A, L),γi = σµii.

L2 Espa¸co dos operadores na norma 2.

xLS Solu¸c˜ao usando quadrados m´ınimos.

Sj Imagens artificias utilizadas nos experimentos, onde j = 1, ...,12.

s Imagem vetorizada.

n n×n a dimens˜ao de Sj, ou seja, o n´umero de pixels da imagem.

F(λ)i O i-´esimo filtro do m´etodo de regulariza¸c˜ao de Tykhonov. F(λ)i = σ2

i

σ2

i+λ

2, associado a SVD. F(λ)i = γi

γ2

i+λ

2, na base GSVD.

AT Matriz transposta da matriz A.

LT Matriz transposta da matriz L.

k.k2 Norma euclidiana, bem como k .k.

LC(λ) Curva do m´etodo L-curve, parametrizada por λ, LC(λ) = (ρλ, ηλ).

ρλ Norma do ajuste aos dados.

ηλ Norma (semi-norma) da solu¸c˜ao.

ρ0 Medida de inconsistˆencia.

k Fun¸c˜ao da curvatura do m´etodo L-curve.

λLC Parˆametro ´otimo gerado pelo m´etodo L-curve.

k.kF Norma de Frobenius.

Cd Constante associada `a mudan¸ca de escalano regularizador de L ←

CdL. Vari´avel no cap´ıtulo 1 e assumido como Cd = kkALkkF

F

∼

= 5.495, para n= 128, no cap´ıtulo 2.

¯

xλ Solu¸c˜ao na regulariza¸c˜ao Tykhonov quando mudamos a escala do

regularizador L←CdL. Vale dizer,

xλ = ¯xλCd = min

λ

kAx−bk2+λ2kCdLxk2 .

¯

λ O parˆametro λ em uma nova escala, ¯λ= Cλ

d.

¯

ρλ O ajuste aos dados, dado por ¯ρλ =kAx¯λCd −bk. (d´uvida)

¯

ηλ A semi-norma da solu¸c˜ao, dada por ¯ηλ =kCdLxk.

¯

LC(λ) A curva do m´etodo L-curve com (¯ρλ,η¯λ).

βCd(λ) A curva do m´etodo L-curve parametrizada com o λ em uma nova

escala. (duvida) ¯

λLC O parˆametro ´otimo, do m´etodo L-curve, para a curva βCd(λ).

¯

xLC Solu¸c˜ao da regulariza¸c˜ao de Tykhonov, gerada a partir do parˆametro

´otimo do m´etodo L-curve, com a curva βCd(λ).

KCd Curvatura da L-curve βCd(λ).

λad Parˆametro com escala alterada, λad = Cλd, onde Cd = kkALkkF

F.

δ Desvio padr˜ao.

E Operador esperan¸ca.

T r Operados tra¸co.

G(λ) Fun¸c˜ao do m´etodo GCV.

λGCV Parˆametro ´otimo fornecido pelo m´etodo GCV.

ˆ

λmin Parˆametro que minimiza a distˆancia kAx−bk.

λEmin Parˆametro que minimiza kxλ−x∗k.

¯

G(λ) Fun¸c˜ao GCV obtida com a mudan¸ca de escala do regularizador,L← CdL.

pick A proje¸c˜ao dex∗ na k-´esima dire¸c˜ao do vetor singularvk na fatora¸c˜ao

SVD deA, em valor absoluto.

D Matriz diferen¸ca que calcula as diferen¸cas entre os pixels. Utilizada como matriz regularizadora.

λDisc Parˆametro ´otimo fornecido pelo m´etodo Discrepˆancia.

x∗

m M´edia da imagem original.

λLC1 Parˆametro referente ao m´aximo local menor que o m´aximo fornecido peloλLC, caso n˜ao exista, λLC1 = 0.001.

λLC1∗ Parˆametro limite, caso o λLC1 n˜ao exista, ou seja,λLC1∗ = 0.001.

LC3 Parˆametro correspondente ao ponto de m´aximo local da curvatura, que seja maior que o m´aximo fornecido por LC, da curva do m´etodo L-curve.

λsuav Limite superior para os parˆametros. J´a que com λ = 15 temos

pa-rˆametros da ordem dos 200 maiores valores singulares genelarizados. Assim, λsuav = 15.

SrLC Imagens correspondentes `as recupera¸c˜oes com os valores ´otimos do

m´etodo L-curve.

SrGCV Imagens correspondetes `as recupera¸c˜oes com os valores ´otimos do

m´etodo GCV.

SrLCF Imagens relativas as imagens SrLC com aplica¸c˜ao de um filtro

passa-baixa.

SrGCV F Imagens relativas as imagensSrGCV com plica¸c˜ao de um filtro

passa-baixa.

P rojK Proje¸c˜oes dex∗ nos subespa¸cos soma dos vetores singulares `a direita

deK a N, P rojK =PNk=K = vTkx∗

vk.

Cap´ıtulo 1

Escolha do parˆ

ametro na regulariza¸

c˜

ao de

Tykhonov

Em linhas bem gerais, um problema inverso corresponde a encontrar um valor para um elemento x em algum espa¸co vetorial adequado, dado um vetor de medidas b. Quando discretizamos o problema, usualmente se recai num sistema de equa¸c˜oesf(x) = b, ondef :U ⊂Rm →Rn representa a fun¸c˜ao de medidas em algum dom´ınioU doRm

adequado [27; 23]. O que vem se tornando uma marca comum aos problemas inversos consiste no fato de recairmos em problemas frequentemente mal postos, no sentido que discutiremos na se¸c˜ao 1.1 e/ou de porte computacional consider´avel. A resolu¸c˜ao de problemas inversos tem sido amplamente pesquisada ao longo das ´ultimas d´ecadas, pois muitos problemas nas ciˆencias, nas engenharias, na medicina e na ind´ustria consistem na determina¸c˜ao de grandezas que buscamos conhecer atrav´es de efeitos observados. Entre as ´areas do conhecimento que se deparam frequentemente com problemas inversos mal-postos est˜ao: medicina (tomografia e ressonˆancia magn´etica), observa¸c˜ao espacial (invers˜oes Helios´ısmicas), engenharia (problemas de vibra¸c˜oes, invers˜ao de combust˜ao, determina¸c˜ao de for¸ca inversa), geof´ısica (determina¸c˜ao de parˆametros no subsolo), entre outras.

Nosso tema geral desta disserta¸c˜ao ´e a regulariza¸c˜ao de Tykhonov de um problema linear mal condicionado, conforme discutiremos na se¸c˜ao 1.1 e nosso objetivo mais geral neste primeiro cap´ıtulo ´e discutir alguns dos principais m´etodos na literatura para a escolha do parˆametro de regulariza¸c˜ao. Em especial, os m´etodos GCV, L-curve e discrepˆancia. Nosso foco mais espec´ıfico nesta disserta¸c˜ao consiste nas simula¸c˜oes realizadas no cap´ıtulo 2 com a matriz da transformada de Rad´on que introduzimos na pr´oxima se¸c˜ao (vide ainda [30],[21] e [20]) e descrevemos com mais detalhes no apˆendice A.

2

´otimos designados como L-curve [19], GCV [14] e Discrepˆancia [28], respectivamente. Dedicamos a se¸c˜ao 1.6 a discutir algumas das compara¸c˜oes entre os m´etodos L-curve e GCV na literatura.

Com rela¸c˜ao `as simula¸c˜oes num´ericas, n˜ao tivemos nenhuma preocupa¸c˜ao com im-plementa¸c˜oes eficientes para a transformada de Rad´on, mas apenas em utiliz´a-la para estudar o comportamento de diferentes m´etodos de obten¸c˜ao do parˆametro de regula-riza¸c˜ao no m´etodo de Tykhonov dispon´ıveis, num problema linear importante e mal condicionado. Basicamente, testamos a recupera¸c˜ao com imagens discretizadas e medi-das com a transformada de Rad´on, `as quais adicionamos ruido branco em diversos n´ıveis de intensidade e numa dimens˜ao compat´ıvel com a obten¸c˜ao de solu¸c˜oes via GSVD. Utilizamos um regularizador de diferen¸cas, conforme explicamos na se¸c˜ao seguinte e uma bateria com 12 imagens de diferentes n´ıveis de “regularidade”, num certo sentido. Entendemos que o sentido desta disserta¸c˜ao est´a muito mais nas quest˜oes que levanta do que no fato de poder dizer algo definitivo. Em parte por se tratar de experimentos num´ericos praticamente sem resultados matem´aticos novos, de algum significado. Em parte por se tratar de experimentos num´ericos realizados com um ´unico operador.

Em compensa¸c˜ao chegamos a algumas observa¸c˜oes que nos parecem interessantes sobre diferen¸cas essenciais na natureza dos m´etodos L-curve e GCV, que se confirmam numericamente e que lhes conferem voca¸c˜oes diferentes e complementares. Essencial-mente, em nossos testes num´ericos, o m´etodo GCV nos parece confirmar sua voca¸c˜ao de origem para procurar imagens pr´oximas da imagem a ser recuperada na normak.k2,

dentro da fam´ılia de solu¸c˜oes regularizadas, por´em a custa de suaviza¸c˜oes excessivas em casos de medidas significativamente contaminadas por ruidos. J´a o m´etodo L-curve tem por voca¸c˜ao ser mais barato computacionalmente e procurar parˆametros que regulari-zem o problema mal posto com baixa perda de informa¸c˜oes sobre o problema original, por´em devolvendo solu¸c˜oes por vezes excessivamente contaminadas por ruidos e exi-gindo algum tipo de p´os-processamento para filtr´a-los. Em particular tornando, pelo menos neste caso da transformada de Rad´on, um pouco sem sentido realizar compa-ra¸c˜oes relativamente `a qualidade na recupera¸c˜ao das imagens pelos dois m´etodos, sem levar em conta algum tipo de p´os-processamento, como tem sido comum na literatura recente da ´area.

1.1 Problemas Inversos e Regulariza¸c˜ao 3

e de forma muito correlacionada com uma pequena janela de varia¸c˜ao relativamente r´apida dos valores singulares generalizados do par (A, L), entre dois patamares nos quais os valores singulares generalizados variam mais lentamente.

Um terceiro ponto que destacamos corresponde a uma certa ambiguidade que encon-tramos na defini¸c˜ao do ponto de m´aximo no m´etodo da L-curve e que nos conduziu a optar por um formato para resolver que nos pareceu adequadamente justificado.

Demos ainda um argumento que nos parece definitivo contra o uso do m´etodo L-curve na escala linear, que passa por mostrar a dependˆencia da solu¸c˜ao ´otima obtida com rela¸c˜ao a mudan¸cas de escala no regularizador.

Discutimos com algum detalhe, no apˆendice C, formas de classificar as imagens a serem tratadas em mais ou menos regulares, em fun¸c˜ao do decaimento de suas compo-nentes na base de vetores singulares generalizados `a esquerda, de modo a orden´a-las e testar o comportamento dos parˆametros de regulariza¸c˜ao, em fun¸c˜ao desta ordena¸c˜ao. Os testes realizados confirmam parcialmente o que se esperaria com a ordena¸c˜ao, mas n˜ao de forma integral.

1.1 Problemas Inversos e Regulariza¸

c˜

ao

Neste trabalho estamos interessados nas solu¸c˜oes de um problema do tipo resolver f(x) = b, onde f : U ⊂ Rn → Rm ´e a fun¸c˜ao de medidas e b ∈ Rm ´e o vetor de

observa¸c˜oes (usualmente acrescido de algum ruido). De acordo com Hadamard, um problema ´e bem posto quando,

• Existe solu¸c˜ao.

• A solu¸c˜ao ´e ´unica.

• Est´avel a perturba¸c˜oes nos dados do problema.

e mal posto quando uma das condi¸c˜oes acima n˜ao ´e satisfeita. Problemas Inversos s˜ao tip´ıcamente mal postos e frequentemente sequer tˆem solu¸c˜ao, principalmente quando levamos em conta ruidos na medida deb. O fato de poder nem ter solu¸c˜ao nos conduz a buscar solu¸c˜oes aproximadas de b = f(x), reescrevendo-os como um problema de minimiza¸c˜ao ,

x=minkb−f(x)kp (1.1)

1.1 Problemas Inversos e Regulariza¸c˜ao 4

de solu¸c˜oes para (1.1). Este fato deu origem a diferentes m´etodos para regularizar o problema. Os trˆes mais usuais s˜ao:

• M´etodo da itera¸c˜ao truncada

Corresponde a aplicar algum m´etodo iterativo para resolverf(x) = be usar algum crit´erio de parada antes que apare¸cam instabilidades. Como ressalta Santos em [33], “em alguns casos funciona e em outros simplesmente n˜ao funciona”. Contudo, ´e muito empregado em algumas situa¸c˜oes espec´ıficas, especialmente se o problema ´e de grande porte, como costuma ser o caso na tomografia m´edica. Al´em disto h´a tamb´em uma farta literatura a respeito, inclusive te´orica. Vide [33] e [15] para acess´a-la.

• M´etodos que explicitamente alternam passos em dire¸c˜ao a solu¸c˜ao com filtros

Artigos como [3] e [4] trabalham com m´etodos iterativos da forma xn+1 =SQxn,

ondeQx´e, tipicamente, alguma combina¸c˜ao convexa de proje¸c˜oes ortogonais, por exemplo ART, e S ´e uma matriz de suaviza¸c˜ao, que pode ser pensada como um filtro aplicado ap´os Qxn, visando regularizar o problema.

O m´etodo mais tradicional para recuperar uma imagemx, a partir de uma medida com a transformada de Rad´on (vide apˆendice A) ´e o da retroproje¸c˜ao filtrada (vide [20] e [21]). A id´eia da retroproje¸c˜ao filtrada pode ser vista sob diferentes ˆangulos. O mais usual talvez seja olhando pelo teorema das fatias de Fourier, conforme exp˜oe Kak no cap´ıtulo 3 de seu livro [21]. A id´eia de se estar alternando entre m´etodos que d˜ao passos em dire¸c˜ao `a solu¸c˜ao do problema inverso com passos visando regularizar o problema de maneira expl´ıcita fica mais clara no sentido que lhe d´a Gabor, no cap´ıtulo 8.1 de [20], sem fazer referˆencia ao teorema das fatias de Fourier, e corresponde a aplicar um filtro unidimensional numa dada etapa da opera¸c˜ao com cada uma das vistas da transformada de Radon, antes de fazer a retroproje¸c˜ao, com o objetivo de regularizar a invers˜ao. Isto ´e equivalente a alternar, num mesmo algoritmo, passos para resolver o problema com passos para suaviz´a-lo.

• M´etodo de regulariza¸c˜ao de Tykhonov

1.1 Problemas Inversos e Regulariza¸c˜ao 5

de penalizar o problema original (1.1), com um termo regularizador do problema considerado, substituindo-o por:

xλ =minkb−f(x)kmp +λ2kL(x−x0)knq (1.2)

onde a segunda parte refere-se ao termo de regulariza¸c˜ao, ou ainda, dito como de penaliza¸c˜ao. Os casos mais usuais correspondem a n =q = 1 ou n =q = 2 e a definir L como a matriz identidade, ou ent˜ao a discretiza¸c˜ao de um operador de derivadas. x0 6= 0 corresponderia a indicar uma aproxima¸c˜ao conhecida da

solu¸c˜ao e λ > 0 ´e um parˆametro de regulariza¸c˜ao que controla a quantidade de regulariza¸c˜ao imposta na solu¸c˜ao. O parˆametro de regulariza¸c˜ao pondera o termo de penaliza¸c˜ao, isto ´e, se λ for alto, suaviza muito o problema perdendo-se importantes informa¸c˜oes, caso contr´ario, os componentes do erro dominam, tendo como resultado uma solu¸c˜ao in´util. Desta forma, o termo de regulariza¸c˜ao introduz um vi´es na solu¸c˜ao a ser encontrada e um dos desafios nas aplica¸c˜oes ´e buscar formas de regularizar o problema que introduzam implicitamente, atrav´es da escolha do regularizadorLe das normaspeq, informa¸c˜ao adicional compat´ıvel com o problema. Uma boa escolha representa uma solu¸c˜ao de compromisso entre regularizar o problema e garantir fidelidade aos dados medidos. .

O caso padr˜ao na escolha do regularizador ´e fazer L=I, sendo I a identidade. Com x0 = 0, L = I significa que se penaliza solu¸c˜oes de norma grande. Quando L ´e uma

matriz de diferen¸cas, que discretiza a derivada de primeira ordem, a id´eia associada ´e a de se penalizar “saltos” no problema inicial, suavizando assim os contrastes no vetor x a ser recuperado e o λ pondera esta suaviza¸c˜ao. Por outro lado, Phillips e Scott em [31], realizaram uma bateria de testes com seis regularizadores diferentes para recuperar problemas 2D com varia¸c˜oes bruscas na imagem e concluiram que a matriz de diferen¸cas teve a melhor performance entre os seis regularizadores testados. De qualquer modo, conforme se pode ver em [16] e teremos a oportunidade de discutir rapidamente na pr´oxima se¸c˜ao, de um modo geral, a regulariza¸c˜ao com q = 2 pode ser vista sob a ´otica de eliminar as instabilidades devidas a ruidos de alta freqˆuencia nas medidas e fatalmente tende a suavizar contornos, independentemente at´e doLutilizado. A escolha de p tem a ver com a distribui¸c˜ao do ruido presente na medida b =Ax∗ +r, de uma

imagem x∗ a ser recuperada. No caso do ruido r ter distribui¸c˜ao gaussiana i.i.d., de

m´edia zero, um estimador de m´axima verossimilhan¸ca para x∗ seria (1.3) com p = 2,

1.2 SVD e GSVD 6

Nesta disserta¸c˜ao visamos discutir a escolha do parˆametro de regulariza¸c˜ao λ, no m´etodo de regulariza¸c˜ao de Tykhonov, para fun¸c˜oes lineares em dimens˜ao finita, no caso p=q = 2 e n=m= 2. Vamos adotar ainda como regularizador uma discretiza¸c˜ao da derivada de primeira ordem, sem dispor de uma aproxima¸c˜aox0previamente assumida.

Na pr´atica, com x0 = 0. De forma que, para n´os, o problema 1.2 se especializa para:

xλ =argminx∈Rnkb−Axk2

2+λ 2

kLxk22 (1.3)

Mais precisamente ainda, as simula¸c˜oes com as quais trabalharemos nesta disserta¸c˜ao correspondem `a reconstru¸c˜ao de imagens medidas pela Transformada de Radon [30; 21; 20]. No apˆendice A descrevemos a transformada de Rad´on com as caracter´ısticas que nos interessam explorar nesta disserta¸c˜ao. Em especial, no que se refere a discretiza¸c˜ao utilizada. A publica¸c˜ao original de Rad´on ´e de 1917 [32], mas sua importˆancia cresceu enormemente na segunda metade do s´eculo XX, com o advento dos computadores. Sua aplica¸c˜ao maior est´a na tomografia, que corresponde a reconstruir um objeto por meio de medidas associadas a vari´aveis que desejamos medir indiretamente, por n˜ao termos o acesso direto ao objeto estudado, e associadas a raios que percorrem o objeto a ser medido. No caso da tomografia m´edica, o exemplo mais t´ıpico corresponde a desferir feixes de raio X sobre algum peda¸co do corpo de um paciente e medir o decaimento na energia destes raios, em algum receptor, ap´os atravessar o tecido de interesse. No caso da geof´ısica, um exemplo t´ıpico ´e medir o tempo que explos˜oes realizadas em determinados pontos levam para atingir receptores previamente determinados, muito embora neste caso o problema seja n˜ao linear, por natureza, e s´o pode ser modelado pela transformada de Rad´on numa primeira aproxima¸c˜ao. Este tipo de reconstru¸c˜ao de imagens ´e bastante utilizada na medicina, em detec¸c˜ao de tumores e na ruptura da estrutura ´ossea entre outros. Na geof´ısica, em prospec¸c˜ao de petr´oleo, detec¸c˜ao de dep´ositos de res´ıduos e etc. Trata-se de um problema inverso tipicamente mal condicionado, igualmente designado como mal posto.

1.2 SVD e GSVD

Uma ferramenta matem´atica bastante ´util para analisar problemas inversos mal pos-tos ´e a fatora¸c˜ao SVD [13]. S´o para simplificar a reda¸c˜ao, discutiremos a fatora¸c˜ao SVD de matrizes com mais linhas que colunas. Em especial, este ´e o caso tratado nas nossas simula¸c˜oes.

1.2 SVD e GSVD 7

U ∈RM×M e V ∈RN×N, tais que

A=UΣVT =

N

X

i=1

σiuiviT

sendo U = (u1...uM) e V = (v1...vN). As colunas de U e de V s˜ao denominadas de

vetores singulares `a esquerda e `a direita de A, respectivamente. A matriz Σ ∈ RM×N

se divide naturalmente em dois blocos, Acima, um bloco diagonalΣN ∈RN×N. Abaixo,

um bloco de zeros. Na diagonal de ΣN est˜ao os valores singulares σi de A, que s˜ao

positivos e est˜ao dispostos em ordem n˜ao-crescente, ou seja,

σ1 ≥...≥σN ≥0

Como estamos interessados em discutir a escolha de parˆametros de regulariza¸c˜ao para a tranformada de Rad´on, vamos supor que todos os σi s˜ao n˜ao nulos, pois isto

´e o que acontece com discretiza¸c˜oes da transformada de Rad´on, muito embora tenha-mos σN cada vez menor, relativamente a σ1, `a medida que tomamos malhas cada vez

mais refinadas. Por exemplo, no nosso caso trabalharemos com recupera¸c˜ao de imagens quadradas com 128×128 pixels. No caso N = 1282 = 16384, por exemplo, obt´em-se

σ1 = 125.64 e σN = 0.0302, resultando num n´umero de condi¸c˜aoK2 =σ1/σN = 4160.

Segundo Natterer em [30], a transformada de Rad´on ´e suavemente mal condicionada, no sentido que, sem discretizar, ou seja, operando emL2, apesar de se tratar de um

ope-rador linear descont´ınuo, seus valores singulares caem para zero segundoσi =O(i−1/2).

Em especial, K2 → ∞, comN → ∞.

Podemos representar a solu¸c˜ao para o problema de quadrados m´ınimos (1.1) utili-zando a decomposi¸c˜ao SVD na solu¸c˜aoxLS. Segue que:

xLS =

h

UΣVTT

UΣVTi−1 UΣVTT b

xLS = VΣTUTUΣVT

−1

VΣUTb

ComoU e V s˜ao matrizes ortogonais resultaU−1 =UT e V−1 =VT. Portanto,

xLS = VΣ2VT

−1

VΣUTb

xLS = Σ−1V−1VΣ2VT

−1

UTb= ΣVT−1 UTb

1.2 SVD e GSVD 8

xLS = N X i=1 uT i b σi

vi, (1.4)

E ainda, lembrando que b = b∗ +r, onde x∗ ´e a solu¸c˜ao para o problema sem ruido

Ax∗ =b∗ em (1.1), temos

xLS = N

X

i=1

uT

i b∗

σi vi + N X i=1 uT i r σi vi (1.5)

Vamos nos deter um pouco na equa¸c˜ao (1.5), pois ela nos indica dois pontos relevan-tes, quando se trata de recuperar sinais medidos por operadores mal condicionados. O primeiro deles ´e a condi¸c˜ao de Picard. Veja que um sinalx∗, com significado f´ısico

x∗ =

N

X

i=1

(vTi x∗)vi = r

X

i=1

uT

i b∗

σi

vi

(1.6)

medido por Ax∗ = b∗, usualmente deveria ter um tamanho compat´ıvel com a escala

do problema onde est´a formulado e n˜ao deveria depender excessivamente de ruidos, no caso de medidas com ruido significativo. Este ´e o significado da condi¸c˜ao de Picard, que pode se formular como:

Defini¸c˜ao 1.2.1. Condi¸c˜ao de Picard Os coeficientes de b∗ =Ax∗ na base de vetores

singulares `a esquerda, ou seja, |uT

i b∗|, devem decair mais rapidamente que σi. Em

termos assint´oticos com i, isto significa que:

uiTb∗

=o(σi) (1.7)

Na figura 2.1 da se¸c˜ao 2.1 apresentamos 12 imagens Sj, com n ×n pixels, onde

n = 128, escolhidas para servirem de teste na recupera¸c˜ao com a transformada de Rad´on, variando desde imagens muito bem comportadas at´e imagens formadas por pixels aleatoriamente escolhidos. Seb∗ =As

j, 1.6 nos diz que:

vTi sj =uTi b∗/σi (1.8)

Veja que 1.7 ´e equivalente a se pedir vT

i sj → 0 e que (1.7)-(1.8) s´o fazem

verdadeira-mente sentido numa representa¸c˜ao cont´ınua das imagenssj. No apˆendice C discutimos

1.2 SVD e GSVD 9

particular, na figura C.1 do apˆendice C representamos os gr´aficos dos coeficientes desj

na base dos vetores singulares `a direitavi.

O segundo ponto relevante a se destacar da equa¸c˜ao (1.5) ´e que um ruido brancorn˜ao satisfar´a `a condi¸c˜ao de Picard, uma vez que, pelo fato de U ser uma matriz ortogonal, UTr igualmente ser´a uma distribui¸c˜ao iid, com m´edia zero e mesma variˆancia que r.

Para fixar id´eias, pensemos no seguinte exemplo:

Exemplo 1.2.1. Recupera¸c˜ao de sinal medido com Radon versus amplifica¸c˜ao de ruido branco

Considere um ruido branco r, de norma ǫkb−bmk, onde bm ´e a m´edia dos bi e uma

matrizA=UΣVT com as caracter´ısticas da matriz de Rad´on que vamos trabalhar em

nossas simula¸c˜oes. Vale dizer, com valores singulares variando numa faixa entre 0.03 e 125 e N = 1282 = 16384. Como ˆr = UTr tem exatamente a mesma variˆancia que r,

quase com toda a certeza teremos componentes ˆrgug, do ruido na base definida pelos

vetores singulares `a esquerda, comg grande, bem pr´oximo de N e|rˆg| ≈ √ǫNkb−bmk.

A recupera¸c˜ao de ˆrgug seria amplificada por 1/σg ≈1/0.03. Resulta algo da ordem

ǫ∗ kb−bmk

√ N σg

≈ ǫ128∗ kb−bmk

∗0.03 ≈0.26ǫ∗ kb−bmk .

Se uiTb∗ ≈ kb−bmk/10, isto indica que ¯x∗i =uiTb∗/σi tende a ser uma componente

importante na imagemPN

1 x¯∗ivi medida porb∗ =Ax∗. Principalmente no caso de

ima-gens satisfazendo fortemente `a condi¸c˜ao de Picard, no sentido de ter sua representa¸c˜ao na base dos vetores singulares {vi} fortemente concentrada nas componentes iniciais.

Se i for pequeno, podemos esperarσi ≈100, ou seja, da mesma ordem de grandeza de

σ1. Em ordem de grandeza, isto nos daria:

|x¯∗i| = |ui

Tb∗

σi | ≈ k

b−bmk/1000 , seguindo-se (1.9)

ˆ rg ˆ x∗ i ≈

0.26ǫkb−bmk kb−bmk/1000 ≈

260ǫ (1.10)

Vale dizer, com um ǫ na faixa de 0.01, teremos ruido sendo recuperado pela solu¸c˜ao de quadrados m´ınimos com tamanho suficiente para competir com o sinal original x∗

a ser recuperado. Ou seja, podemos esperar que uma perturba¸c˜ao r com estas carac-ter´ısticas, quase com toda a certeza, ter´a coeficientes uT

1.2 SVD e GSVD 10

valores singulares pequenos e de modo a fazer com que, mesmo com ruidos de intensi-dade relativamente modestas, tais componentes possam vir a ser dominantes, tornando assim, a solu¸c˜ao de quadrados m´ıninos (1.1) in´util.

A solu¸c˜ao para o problema (1.3) regularizado com L=I pode ser descrita usando a decomposi¸c˜ao SVD de A aplicada ao problema de quadrados m´ınimos, de maneira inteiramente an´aloga ao que fizemos para obter (1.5) e nos daria:

xλ = N X i=1 σ2 i σ2

i +λ2

uT i b

σi

vi (1.11)

xλ = N X i=1 σ2 i σ2

i +λ2

uT i b∗

σi

vi+ N X i=1 σ2 i σ2

i +λ2

uT i r

σi

vi (1.12)

Como bem aponta Hansen em [16], podemos entender a regulariza¸c˜ao de Tykhonov como um filtro de passa baixaF(λ), com

Fi(λ) =

σ2

i

σ2

i +λ2

(1.13)

Se λ << σi, Fi(λ) ≈ 1. Neste caso, a correspondente componente da solu¸c˜ao (1.11)

na dire¸c˜ao de vi ´e aproximadamente a mesma prescrita em (1.5). J´a no caso em que

λ >> σi,Fi(λ)≈0 e a correspondente componente da solu¸c˜ao (1.11) na dire¸c˜ao de vi

´e filtrada.

Conforme Hansen destaca em ([16]), a medida que consideramos vetores singularesvi

associados a valores singulares cada vez menores, ˆeles estar˜ao crescentemente concen-trados nas altas frequˆencias , em sua representa¸c˜ao em Fourier. Neste sentido, o trade off propiciado pela regulariza¸c˜ao de Tykhonov, entre fidelidade no ajuste aos dados versus regulariza¸c˜ao, pode ser pensado como um filtro para as componentes de alta frequˆencia no ruido da solu¸c˜ao obtida, que s˜ao exatamente aquelas amplificadas pelos valores singulares baixos. Na contrapartida, uma criteriosa escolha do parˆametroλ te-ria o papel de evitar maiores preju´ızos `as informa¸c˜oes relevantes do sinal, usualmente associadas aos vetores singulares com menores ´ındices, sobretudo na recupera¸c˜ao de sinais sob condi¸c˜oes de Picard favor´aveis. Em especial, este nos parece um bom ponto de vista para se analisar os diferentes m´etodos que visam otimizar a escolha do pa-rˆametro de regulariza¸c˜ao, conforme teremos a oportunidade de praticar ao analisar as simula¸c˜oes apresentadas no pr´oximo cap´ıtulo.

1.2 SVD e GSVD 11

identidade, ou sejaL6=I, consideramos importante a introdu¸c˜ao da Decomposi¸c˜ao em Valores Singulares Generalizados (GSVD). Vide [13; 16].

Teorema 1.2.2. (GSVD) Seja o par matricial (A, L) com A ∈ RM×N e L ∈ Rp×N,

com M +p≥N. Podemos decompor A e L como

A = UΣW−1 (1.14)

L = VCW−1 (1.15)

Em que, U ∈ RM×M e V ∈ Rp×p s˜ao matrizes ortogonais tais que UTU = I M e

VTV =I

p e W ∈RN×N, ´e uma matriz n˜ao-singular. A cada uma das matrizes Σ e C

est˜ao associados N n´umeros ordenados, respectivamente, da seguinte forma:

0 ≤ σ1 ≤...≤σN ≤1, (1.16)

1 ≥ µ1 ≥...≥µN ≥0 e de tal forma que (1.17)

1 = σi2+µ2i , para i= 1· · ·N (1.18)

As matrizes Σ e C tˆem estes n´umeros, ordenados desta forma, numa de suas diago-nais, da seguinte maneira:

• Se M ≥N, Σ = ΣN 0

!

e ΣN ´e uma matriz diagonal

• Se M ≤ N, σ1 = ...=σN−M = 0, Σ =

0 ΣM

e ΣM =diag(σN−M+, ....σN)

´e uma matriz diagonal

• Se p≥N, C = CN 0

!

e CN ´e uma matriz diagonal

• Se p≤N, mp+ 1 =mp+ 2 =· · ·=mN, C =

Cp 0

e Cp =diag(m1, ..., mp)

´e uma matriz diagonal

Os valores singulares generalizados γi de (A, L) s˜ao definidos, para cada i= 1, ..., N

como

γi ≡

σi

µi

. (1.19)

Observe que podemos entender a fatora¸c˜ao SVD como um caso particular da GSVD, se L = In. Neste caso, levando W−1 = C−1VT em A = U(ΣC−1)VT e fazendo β =

1.2 SVD e GSVD 12

matrizW−1deixar de ser ortogonal. Ainda assim, espera-se que seja aceitavelmente bem

condicionada. Hansen aponta em [16] que os valores singulares deW s˜ao os mesmos que os da matriz A

L !

No caso com o qual trabalharemos nas simula¸c˜oes, comN = 1282,

obtemos W com um n´umero de condi¸c˜ao de aprox. K2 = 82.

Analogamente ao que fizemos com a SVD, podemos utilizar GSVD para solucionar o problema (1.3). Teremos,

xλ =

h

W−1T

ΣTUTUΣW−1+λ2 W−1T

CTVTVCW−1i−1 W−1T

ΣTUTb (1.20)

xλ =W Σ2+λ2C2

−1 ΣUTb

xλ = p X i=1 σ2 i σ2

i +λ2µ2i

uT i b

σi

wi (1.21)

= p X i=1 γ2 i γ2

i +λ2

uT i b

σi

wi (1.22)

Igualmente a antes, podemos pensar na regulariza¸c˜ao de Tykhonov neste caso, como correspondente a aplicar filtrosFi(λ) aos coeficientes de Picard u

T ib

σi .Fi(λ) continua com

a mesma f´ormula (1.13) de antes, apenas substituindo-se os valores singulares usuais σi pelos valores singulares generalizados como definidos em (1.19).

Igualmente ao que acontecia com L = I, seu efeito ´e amortizar as contribui¸c˜oes a xλ correspondentes a valores singulares generalizados γi << λ. Em especial, como

j´a ocorria no caso SVD, filtrando ruidos de alta frequˆencia e tornando a solu¸c˜ao bem menos sens´ıvel a perturba¸c˜oes do que a solu¸c˜ao de quadrados m´ınimos, conforme analisa Hansen em [16]. Do ponto de vista computacional, uma vez obtida a fatora¸c˜ao GSVD, o c´alculo da solu¸c˜ao (1.19) ´e muito barato, pois corresponde essencialmente a uma multiplica¸c˜ao matriz-vetor. Para que se tenha uma id´eia de tempos, num computador com HD de 1 Terabyte , 24.0 Gb de mem´oria RAM, 2 processadores Xeon Intel de 3.20 GHz, como o que usamos, dispondo da fatora¸c˜ao GSVD, se pode calcular as solu¸c˜oes para 400 valores de λ em cerca de 1 minuto, no caso N = 1282 = 18384, com o

matlab. J´a para obter a fatora¸c˜ao GSVD do par (A, L) com o qual trabalhamos no caso N = 1282, foram necess´arias mais de 48 horas, no mesmo computador. Al´em

1.3 L-Curve 13

pr´oximo cap´ıtulo. Contudo, para problemas de porte maior, a fatora¸c˜ao GSVD tende a tornar-se computacionalmente invi´avel e temos de recorrer a m´etodos iterativos se queremos resolver (1.3). No caso da m´aquina que citamos, a fatora¸c˜ao GSVD para N = 256×256 j´a se tornava completamente invi´avel.

1.3 L-Curve

Como vimos nas se¸c˜oes anteriores, tipicamente os m´etodos de regulariza¸c˜ao de Tykho-nov, para propiciarem uma solu¸c˜ao est´avel apropriada, envolvem um “trade-off” entre o “tamanho” da solu¸c˜ao regularizada, medido por kLxλk e a qualidade do ajuste aos

dados, medida pelo res´ıduokAxλ−bk2. Em especial, vimos que a solu¸c˜ao “ingˆenua” de

quadrados m´ıninos (1.1) tende a ficar completamente dominada por ruidos, em pro-blemas mal condicionados, tornando, assim, essa solu¸c˜ao in´util. Se λ for relativamente grande, a solu¸c˜ao sai muito “suave” e o ajuste aos dados kAxλ−bk2 ficar´a

prejudi-cado. Caso contr´ario, se λ for excessivamente pequeno obtemos um “bom” res´ıduo, mas a solu¸c˜ao ser´a tomada pelo ruido fazendo com que a penaliza¸c˜aokLxλk2 aumente

consideravelmente.

Hansen, a partir de seus artigos seminais do in´ıcio da d´ecada de 90, [19] e [15], ´e o principal nome associado ao m´etodo designado por L-curve para encontrar um parˆame-tro ´otimo para a regulariza¸c˜ao de Tykhonov. Este m´etodo se tornou, a partir da d´ecada de 90 um dos mais populares para definir um bom parˆametro para a regulariza¸c˜ao de Tykhonov. Hansen cita ainda o livro de Lawson e Hanson de 1974, [24], como precursor na utiliza¸c˜ao do m´etodo. O m´etodo L-curve baseia-se na curva

LC(λ) = [ρλ, ηλ] , onde (1.23)

ρλ =kAxλ−bk2 (1.24)

ηλ =kLxλk2 (1.25)

Conforme veremos a seguir, a forma da L-curve sugere naturalmente uma regi˜ao na qual a L-curve varia rapidamente sua dire¸c˜ao como a mais natural para se procurar um parˆametro λ que estabele¸ca um adequado equil´ıbrio entre a regulariza¸c˜ao e o ajuste aos dados.

1.3 L-Curve 14

nesta disserta¸c˜ao, mais adiante:

ρ(λ) = kAxλ−bk2 = N

X

i=1

((1−Fi)uTi b)2+ρ20 (1.26)

η(λ) = kLxλk2 = N

X

i=1

µiFi

uT i b σi 2 = N X i=1 Fi uT i b γi 2 (1.27) (1.28) onde,

ρ0 = b−

N

X

i=1

(uTi b)ui (1.29)

Fi(λ) =

γ2

i

γ2

i +λ2

(1.30)

e γi representa os valores singulares generalizados do par matricial (A, L). (1.26-1.27)

indicam queρ(λ) ´e crescente, enquanto queη(λ) ´e decrescente e ambas s˜ao curvasC∞.

Em especial, podemos pensar emρ(λ) como uma fun¸c˜ao monotonamente crescente de η(λ). A curva [ρ(λ), η(λ)], ser´a ent˜ao uma curva C∞, tipicamente com a forma de um

L (ver figura 1.1).

Um resultado bem b´asico sobre a L-curve pode ser encontrado em [17] e essencial-mente se segue das observa¸c˜oes acima e da aplica¸c˜ao do m´etodo dos multiplicadores de Lagrange aos problemas (1.31-1.32) abaixo:

Teorema 1.3.1. Seja xλ a solu¸c˜ao para (1.2). Ent˜ao kLxλk ´e uma fun¸c˜ao mon´otona

decrescente de kAxλ−bk e qualquer ponto (ρ, η) na curva (kAxλ −bk,kLxλk) ´e uma

solu¸c˜ao para:

ρ=minkAx−bk sujeito a kLxk ≤η, 0≤η ≤ kLx0k (1.31)

η =minkLxk sujeito a kAx−bk ≤ρ, ρ0 ≤ρ≤ρ∞ (1.32)

onde, ρ∞ =ρ0+

U UTb

.

Basicamente esse teorema nos diz que ´e imposs´ıvel construir qualquer solu¸c˜ao para o problema (1.3) que esteja abaixo da L-curve. Como destaca Hansen, a solu¸c˜ao de Tykhonov xλ ´e ´otima no sentido que, dado η n˜ao existe solu¸c˜ao de (1.3) com res´ıduo

1.3 L-Curve 15

Figura 1.1 Gr´afico t´ıpico do m´etodo L-curve

quekLxλk. Em especial, ainda de acordo com Hansen, isto nos daria parˆametros para

caracterizar a qualidade de solu¸c˜oes obtidas por outros m´etodos de regulariza¸c˜ao. Ainda segundo Hansen, tipicamente, a L-curve tem trˆes partes bem distintas, cons-tituindo uma curva em forma de L, conforme se ilustra na figura (1.2). Da´ı seu nome ser L-curve:

Figura 1.2 Gr´afico t´ıpico do m´etodo L-curve dividida em 3 partes

• I - Parte “horizontal”, paraλrelativamente grande, onde os erros de regulariza¸c˜ao dominam.

• II - Regi˜ao de transi¸c˜ao relativamente abrupta, ou seja, com curvatura elevada. • III - Parte “´ıngreme”, para λ relativamente pequeno, na qual o ajuste ao erro

1.3 L-Curve 16

Em [19], entre outras coisas, Hansen demonstra esta caracteriza¸c˜ao para a L-curve, no caso L = I, supondo

i a condi¸c˜ao de Picard para a medida b∗ =Ax∗ de um sinal,

ii adiciona um ruido r que seja iid, de m´edia zero na medida b iii e tal que krk<kb∗k

Em [17] ˆele estende esta caracteriza¸c˜ao para o caso onde Ltenha seu posto igual ao n´umero de linhas, por´em sem dar uma demonstra¸c˜ao deste fato.

Em [19], Hansen explora esta propriedade da L-curve para definir m´etodos de encon-trar o parˆametro de regulariza¸c˜ao ´otimo, em algum sentido. Oλ ´otimo se encontraria em algum lugar do canto da curva, onde h´a uma rela¸c˜ao mais equilibrada entre regu-lariza¸c˜ao e ajuste de dados. Segundo Hansen [19], h´a pelo menos duas maneiras de se pensar noλ ´otimo:

1 Encontrando o λ que fornece a menor distˆancia entre a curva e a origem. Segundo Hansen, a maneira de medir a distˆancia entre a L-curve e a origem deveria levar em conta o m´etodo de regulariza¸c˜ao utilizado e que a medida de distˆancia mais natural neste caso seriaρ+λ2η. Contudo, em nossos experimentos

esse medida n˜ao funciona, pois ´e sempre crescente, com o λ. Utilizando a distˆan-cia Euclidiana usual para encontrar o ponto da L-curve mais pr´oximo da origem, fomos surpreendidos pelo fato que ele parecia produzir um λ constante, indepen-dentemente do ruido e das imagens empregadas. Na verdade, fazendo as contas, vimos que se trata de um resultado que, `a falta de outro nome, denominaremos de Lema do λ ´otimo a priori. Aparentemente trata-se de um resultado surpreen-dente, embora simples de estabelecer. ’‘Enganoso”, contudo, conforme teremos a oportunidade de mostrar na subse¸c˜ao que se segue.

Lema 1.3.1. λ ´otimo a priori

λ = 1´e o ponto da L-curve mais pr´oximo da origem, na medida euclidiana usual do R2

Demonstra¸c˜ao 1.3.1. De 1.26 e 1.27, temos

ρ(λ)2+η(λ)2 =

N

X

i=1

((1−Fi)uTi b)2+ρ02+

N X i=1 Fi uT i b γi 2 (1.33) = N X i=1

((1−Fi)uTi bui)2+

1.3 L-Curve 17

Derivando, em λ, para encontrar o ponto cr´ıtico e lembrando que Fi = γ 2

i

γ2

i+λ

2

(ρ(λ)2+η(λ)2)′ =

N

X

i=1

4λ3α2

i (γi2+λ2)

2

−2 (γ2

i +λ2) 2λ(λ4+γi2α2i)

(γ2

i +λ2)

4

=

N

X

i=1

α2i (γi2+λ2) (4λ5+ 4λ3γi2−4λ5−4λγi2)

(γ2

i +λ2)

4 = N X i=1 α2

i (γi2+λ2) (λ3−λ) 4γi2

(γ2

i +λ2)

4

= λ3−λ

N

X

i=1

4γ2

iα2i

(γ2

i +λ2)

3

Resulta um ´unico ponto cr´ıtico paraρ(λ)2+η(λ)2, como solu¸c˜ao de (λ3−λ) = 0. Ou seja, λ= 1.

2 Calculando o λ que corresponde a curvatura m´axima da L-curve.

J´a que a L-curveLC(λ) ´eC∞, sua curvatura, como se pode ver em [37], pode ser

expressa por:

k(λ) = ρ′η′′−ρ′′η′

((ρ′)2+ (η′)2)3/2 (1.35)

onde ′ s˜ao as diferencia¸c˜oes em rela¸c˜ao ao λ.

Na parteIda curva, pequenas mudan¸cas noλresultam em grandes varia¸c˜oes no res´ıduo e na parte III observa-se grandes varia¸c˜oes no valor kLxλk2 para pequenas varia¸c˜oes

de λ. Entre outros argumentos heur´ısticos, para amenizar essas varia¸c˜oes bruscas e destacar melhor a regi˜ao de transi¸c˜ao, Hansen sugere o uso da escala log-log para a L-curve. Ou seja, que se busque os pontos de m´axima curvatura para a L-curve no plano log-log, definida por:

LC(λ) = [log(ρλ), log(ηλ)] = [log(kAxλ−bk2), log(kLxλk2)] (1.36)